Robots que sienten lo que tocan

El tacto es esencial en la relación de los humanos con su entorno. También entre robots y creadores. Un proyecto europeo liderado desde la Universidad de Bolonia enseña a las máquinas a distinguir lo que palpan para aplicar la fuerza adecuada

El famoso antropólogo Ashley Montagu escribió hace muchos años que “la comunicación que transmitimos con el tacto constituye el medio más poderoso de establecer relaciones humanas”. Y aquí están, un día de primeros de mayo de 2023, un grupo de investigadores de la Universidad de Bolonia tratando de proporcionar el sentido del tacto a una máquina. Están usando dos tecnologías para darle a una mano robótica dos tipos distintos de sensibilidad: una, un poco más de trazo grueso, que cubrirá la mayor parte de la superficie de la palma, y otra que le ofrecerá una información mucho más rica y completa sobre la dureza, la aspereza o suavidad de los objetos, como la que nos transmiten las yemas de los dedos, y que el aparato tendrá precisamente ahí.

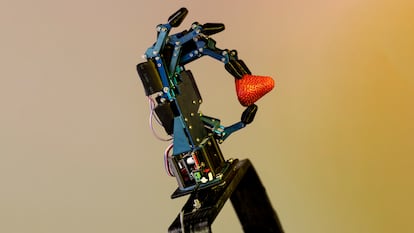

Hoy, en el Laboratorio de Robótica de la Facultad de Ingeniería, la investigadora predoctoral Alessandra Bernardini no solo se afana con infinita paciencia en explicar a los visitantes cómo funciona esto último —se colocan unos pequeños sensores semiesféricos, de un material maleable parecido a la goma, que envían al ordenador información sobre las propiedades del objeto que sujeta—, sino que está dispuesta a renunciar a dos de las fresas que ha traído para el almuerzo para ilustrar la demostración. A medida que la mano robótica va apretando el fruto rojo, los fototransmisores de los sensores traducen las perturbaciones de la goma en datos que se muestran en la pantalla en forma de gráficos de líneas que se juntan y se separan.

Junto a ella, Roberto Meattini, otro miembro del equipo, continúa con la demostración. Una vez que tiene bien sujeta a su muñeca derecha una estructura rectangular —en un extremo hay un hueco para meter la mano y en el contrario está acoplado el prototipo robótico—, comienza a encoger y a extender lentamente los dedos. Lo que está haciendo, con la ayuda de Bernardini a los mandos del ordenador, es enseñar a la prótesis a leer los movimientos de los músculos del antebrazo que dirigen lo que hace su mano, para poder después repetirlos; una pulsera colocada un poco más abajo del codo es la encargada de recoger y transmitir esa información al robot a través de unos sensores inalámbricos.

Los dos ingenieros, junto a otra media docena de compañeros y liderados por el profesor Gianluca Palli, están dando apenas los primeros pasos del proyecto IntelliMan, formado por un consorcio de 13 universidades, empresas y centros de investigación de seis países europeos, con el objetivo de desarrollar un nuevo sistema de manipulación impulsado por inteligencia artificial que permita a los robots (ya sean prótesis como la mano que hemos visto o máquinas independientes) aprender tanto del entorno como de la interacción con las personas. La Comisión Europea lo ha elegido entre los 42 primeros proyectos de inteligencia artificial y robótica lanzados dentro del programa Horizon Europe, el gran plan de investigación e innovación del continente. Han sido seleccionados por su potencial para “mejorar la sociedad en que vivimos, abordando importantes desafíos tecnológicos”, según el documento que recopila las iniciativas. Entre las elegidas hay desde un gran centro que tratará de garantizar la seguridad en la investigación en inteligencia artificial hasta propuestas para la recuperación de agua, de reciclaje o de desarrollo de drones para apoyar a los trabajadores del campo y a empleados de mantenimiento de infraestructuras en lugares peligrosos.

En el caso IntelliMan, el profesor Palli explica en su despacho de la histórica ciudad italiana qué frutos tratarán de obtener de los 4,5 millones de euros que recibirán de la Comisión entre septiembre de 2022 y febrero de 2026. En primer lugar, su objetivo es crear extremidades prostéticas con las que sus dueños sean capaces de abordar fácilmente sus actividades cotidianas, como sujetar un vaso o abrir una puerta o un cajón. El siguiente paso será transmitir esas capacidades a una máquina independiente que se pueda convertir más pronto que tarde en un asistente robótico del hogar que ponga solito el lavavajillas o recoja la mesa después de comer. La idea es que puedan interactuar con las personas, pero que nadie se imagine todavía charlando con ellos; se trata de enseñarles tareas nuevas —mostrándoles una vez cómo hacerlo, para que luego las repitan—, pero que, además, sean capaces de adaptar ese trabajo aprendido a un contexto cambiante: un obstáculo en el camino que antes no estaba ahí, un objeto más resbaladizo que el anterior.

Para eso necesitan el sentido de la vista —que se puede resolver con cámaras y sensores— y el más complicado del tacto, en el que están trabajando. Pero no solo para dárselo a la máquina, sino también para que, en el caso de las prótesis, estas se lo hagan sentir también, de algún modo, a la persona que las utiliza: “Por ejemplo, estamos trabajando en transmitir la fuerza de agarre por medio de motores vibrotáctiles, que son pequeños motores que vibran a diferente amplitud de frecuencia [dependiendo de si esa fuerza es mayor o menor]”, explica Meattini, de vuelta en el laboratorio. “Es algo que ni siquiera las prótesis más avanzadas del mercado hacen todavía”, añade.

Los investigadores se mueven en un espacio en el que hay ordenadores y modernos prototipos de maquinaria puntera, pero también muchos cables, cartones, algún rollo de cinta aislante y un gran mueble metálico del que los ingenieros van sacando todo tipo de herramientas grandes, medianas y pequeñas. Junto a ese mundo de tecnología ultramoderna, blanca y aséptica, de formas armónicas y redondeadas que preside nuestro imaginario colectivo, este laboratorio recuerda que los avances —al menos una parte y al menos en parte— siguen ocurriendo en lugares llenos de enchufes y de ángulos que pinchan, con objetos que hay que tocar para ensamblar y que hay que probar una y otra vez para encontrar la manera de que funcionen. Unos lugares donde se entremezclan estudiantes, doctorandos, investigadores en ciernes con otros ya consagrados, que trabajan en proyectos simultáneos que confluyen y a veces se solapan. Donde, quizá precisamente por todo eso, resulta fundamental descomponer cada objetivo en tareas más pequeñas para hacerlos manejables e ir avanzando pasito a pasito, pero sobre peldaños firmes, hacia el resultado final.

Ahora mismo, en lo que se refiere a IntelliMan, los ingenieros que forman el grupo boloñés están concentrados en comprender cómo funciona un agarre robótico: primero hay que llegar al objeto; luego, establecer el contacto y entender el contexto en que está establecido para saber si puede aumentar o no la fuerza de agarre, explica Meattini. Todo esto se puede hacer de distintas maneras, la más clásica de las cuales es crear modelos matemáticos que describan cómo ese proceso puede acometerse y repetirse sin fallo alguno. “El problema con esto es que, en teoría, funciona perfectamente, pero en la vida real no sabes exactamente dónde va a tocar, cómo va a hacerlo… Así que estamos trabajando en un enfoque diferente, de inteligencia artificial basada en probabilidades, de modo que podamos tomar las medidas del sensor y describirlas en nuestro modelo probabilístico y que este nos diga cómo debería ser el agarre. El mundo real es probabilístico, no es como una fórmula”, añade el investigador.

Ese mundo real —con sus fallos, sus obstáculos imprevistos y sus insólitas soluciones— está muy presente en esta investigación, en forma de trabajadores de fábricas que explican los secretos escondidos de sus funciones y de personas con amputaciones que les cuentan a los científicos qué necesitan exactamente de una prótesis para que realmente les resulte útil y nos les estorbe (el centro de rehabilitación especializado que el Instituto Nacional para la Prevención de los Accidentes del Gobierno italiano tiene cerca de Bolonia, en Budrio, forma parte del consorcio). Pero también está muy presente —de hecho, está en la base de todo este esfuerzo colectivo— esa idea de buscar aproximaciones distintas a viejos problemas. Por ejemplo, el que supone no solo que la máquina sienta lo que ocurre alrededor, sino, sobre todo, que sepa qué hacer después con esa información, algo que están intentando resolver “mezclando dos enfoques que ya están completamente establecidos, pero cuya conexión todavía estamos investigando”, destaca Palli. Y se detiene en la explicación, pues es una de las grandes singularidades de su proyecto.

Por un lado están los métodos más clásicos, que consisten en mapear y preconfigurar toda la actividad que va a desarrollar el robot en un tiempo y en un espacio, es decir, que va a coger un objeto concreto en un punto y lo va a dejar en otro. “Es difícil aplicar estas soluciones en la práctica si no tienes absolutamente toda la información del contexto en que se mueve”, señala, lo cual es sencillamente imposible en el momento en que entra en juego la impredecibilidad de la vida cotidiana y de la interacción con personas. Lo que nos lleva al segundo posible enfoque, el fundamental del machine learning y la inteligencia artificial: recopilar una cantidad gigantesca de información de contexto que se le da a la máquina a través de millones de ejemplos para que aprenda cómo se hace algo. Este también tiene una gran limitación, según Palli: requiere tal cantidad de pruebas, tal cantidad de datos, que quizá sea posible de recopilar si estás investigando, por ejemplo, en el campo de la economía, sobre la que hay infinidad de referencias disponibles; pero para una aplicación robótica como la que ellos tienen en mente ni existe ni está al alcance, ya que recoger esa información es muy caro: hace falta tiempo, equipos…

“De alguna manera, estamos tratando de definir cuál es el plan del robot y, a partir de la base de muy pocos experimentos, recopilar los datos suficientes para que adapte el plan a las condiciones reales del entorno. Pero, además, queremos que el ser humano, la persona, esté activamente presente en ese entorno, que interactúe con él, que también le enseñe”, resume finalmente el coordinador del proyecto.

Palli, de 46 años, habla con el aplomo de quien lleva varios lustros buscando soluciones para crear robots más completos e independientes y lo hace desde una institución que fue pionera en este campo; en concreto, en el desarrollo de manos robóticas antropomórficas que fueran cada vez más fiables, sencillas y baratas. Su historia se puede repasar a través de los prototipos expuestos en varias vitrinas en el laboratorio de robótica de la universidad: desde el primero, financiado en 1988 por IBM Italia —un rudimentario dispositivo con dos dedos paralelos y un pulgar opuesto controlados por músculos artificiales, tendones alimentados con varios motores y un sistema de calculadoras y equipos electrónicos—, hasta uno de los más recientes: una mano robótica, movida por un espectacular brazo con transmisión de tendones de cuerda trenzada, con la que los investigadores ya empezaron a dar los primeros pasos para introducir sensores táctiles. Sobre toda esa base de conocimiento previo —gracias a todo lo que se consiguió, pero también gracias a todo lo que se fue descartando por el camino— se avanza ahora hacia una nueva generación.

El proyecto que dirige Palli va, en todo caso, mucho más allá de la mano robótica y de las prótesis en general. No solo por los robots domésticos, sino por las aplicaciones para la industria en las que están trabajando. Por un lado, colaboran con la cadena británica de supermercados online Ocado en un robot que sea capaz de sacar frutas de una caja grande para colocarlas en otras más pequeñas, para lo cual es importante que pueda cambiar la fuerza de agarre dependiendo de si lo hace con manzanas, con naranjas o fresas. Además, intentan algo todavía más difícil para la industria automovilística (la empresa de componentes eslovena Elvez es otro de los socios del consorcio): ensamblar cables y conectores, es decir, materiales deformables cuya manipulación requiere unas destrezas bastante finas.

Están en ello. Y el próximo salto adelante dependerá de la ruptura de barreras en muchos campos de la ciencia: desde las matemáticas —para representar de la mejor manera el plan preasignado de los robots y cómo percibe su entorno— hasta los desarrollos tecnológicos paralelos —los sensores de tacto están todavía en proceso de avance y mejora—. Pero a Palli le preocupa especialmente cómo puede ser la interacción entre máquina y humano, para lo cual el proyecto cuenta con el apoyo de un equipo de psicólogos.

El papel que desempeñe el tacto en ese camino dependerá en gran medida de su desarrollo, de momento muy rudimentario. Pero no olvidemos las palabras del antropólogo británico estadounidense Ashley Montagu sobre el poder de este sentido, quizá el más complejo de todos, para la comunicación humana. En su libro clásico El tacto: la importancia de la piel en las relaciones humanas, el profesor de la Universidad de Princeton fallecido en 1999 hacía también afirmaciones como estas: “En la evolución de los sentidos, el tacto fue, sin duda, el primero en existir. El tacto es el padre de nuestros ojos, oídos, nariz y boca. […] como Bertrand Russell señaló tiempo atrás, es el sentido que nos proporciona sensación de realidad. ‘No solo nuestra geometría y nuestra física, sino toda concepción de lo que existe fuera de nosotros está basada en el sentido del tacto”.

“Estoy de acuerdo en que el tacto será cada vez más importante, porque es lo que cambia completamente el juego cuando interactúas con los objetos y el entorno. Creo que abrirá realmente la capacidad de los robots para interactuar con el entorno de una manera efectiva”, opina Palli. De momento, en todo caso, lo que él y su equipo proponen para que la relación entre humano y máquina funcione bien es una especie de autonomía compartida, en la que la persona que empieza a relacionarse con la máquina la trata como a un niño al que tiene que ir enseñando y dándole poco a poco más margen para tomar sus propias decisiones. “Eso significa que el robot parte de un punto en el que depende completamente del humano, porque no sabe cómo hacer algo. Y así el humano le enseñará qué hacer, lo que le da al robot más autonomía, porque podrá hacerlo en lo sucesivo de forma independiente”, explica el investigador. Ese proceso ayudará, además, a que la persona confíe en el robot.

Cuando a Roberto Meattini le preguntan en un contexto social a qué se dedica, suele elegir la versión corta: “Trabajo en la interacción de robots y humanos; estudio cómo conectar a los humanos con los robots y viceversa”. Porque insiste en que no se trata de crear robots, sino de esa relación, que es de hecho lo que sustenta las bases teóricas de las principales disciplinas sobre la ingeniería de sistemas automáticos con la que trabajan, explica este ingeniero que mencionó en su tesis doctoral aquel robot de juguete que le regalaron sus padres en su quinto cumpleaños. También está convencido de la importancia del tacto en el camino de mejora: “La capacidad de sentir y responder al tacto permitirá a los robots no solo realizar mejor las tareas de manipulación y las operaciones autónomas, sino también comprender las intenciones humanas y ser útiles para sus necesidades, lo que conducirá a interacciones más intuitivas y efectivas”.

Suena bien, sin duda. Pero llegados a este punto, por mucho que estemos hablando de robots con capacidades en principio básicas, resulta inevitable enfrentarse a los temores que afloran cada vez con mayor violencia en torno a las posibles consecuencias indeseadas del desarrollo de inteligencia artificial; al fin y al cabo, estamos hablando de robots capaces de aprender cosas nuevas. “Nosotros aplicamos principios éticos a toda nuestra investigación”, responde Palli cuando se le plantea el asunto. Pero, ¿tienen en mente la idea de transmitir algún tipo de ética a los robots? “No, en principio no estamos en eso. Estamos trabajando en la seguridad, que todo el trabajo que hagan lo hagan con seguridad”, responde. Y añade: “Podríamos decir que estamos trabajando en un requisito ético muy básico”.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.