Cómo lograr que el reconocimiento facial no sea racista, machista ni torpe, el gran desafío del diseño para 2019

Virales como #10yearschallenge podrían entrenar a las máquinas para identificarnos mejor, pero antes de contribuir deberíamos hacernos algunas preguntas

Miles de usuarios de todo el mundo han participado en los últimos días en el #10yearschallenge. Incluso personalidades como Madonna, Alejandro Sanz o Nicky Minaj se han sumado a este reto viral que consiste en compartir en las redes sociales una fotografía de hace una década junto a una actual. ¿El objetivo? Comprobar cómo se ha cambiado físicamente en los últimos 10 años. Este desafío a primera vista es solo un juego. Pero ya hay quien se ha planteado si se trata de una estrategia de las compañías como Facebook para recabar más datos sobre los usuarios y entrenar a sus sistemas de reconocimiento facial.

Hasta hace unos años el escaneo e identificación de rostros era solo posible en las películas de espías o en distopías como Minority Report (Steven Spielberg, 2002). Ahora esta tecnología se ha colado en nuestras vidas hasta el punto de que muchos la usan a diario para desbloquear su smartphone, y en la pantalla gigante de Piccadilly Circus, en Londres, se aplica para conocer la edad y el género de los peatones cercanos y personalizar así los anuncios que muestra. Más lejos ha llegado China, donde ya se aplica para pagar en restaurantes o identificar a sospechosos de haber cometido un delit, entre otros usos.

Problema: estos sistemas aún fallan más que una escopeta de feria, con todas las implicaciones que eso tiene. Y es este justamente uno de los grandes retos del diseño para 2019 y en adelante, pues uno de sus roles más importantes es interpretar los avances de la tecnología para asegurarnos de que nos afectan de forma positiva y no de manera negativa. En este caso, encontrar el modo de perfeccionar estos sistemas de reconocimiento facial, atendiendo a los dilemas éticos, los sesgos y las dificultades técnicas que las primeras pruebas han puesto de manifiesto, y que vaticinan serios riesgos si no diseñan de forma inteligente y sensible.

Maquillaje, peluquería o gafas de sol para engañar al sistema

El periodista de Forbes Thomas Brewster, especializado en ciberseguridad, probó que una cara impresa en 3D es capaz de desbloquear la mayoría de terminales con reconocimiento facial en el mercado. Y también hay quienes demuestran que se puede pasar inadvertido ante este tipo de sistemas con maquillaje y peluquería.

El reconocimiento facial de Amazon confundió en 2018 a 28 congresistas con sospechosos de la policía, lo que llevó a la Unión Estadounidense por las Libertades Civiles (ACLU) a señalar lo obvio en un comunicado: si se usa por parte de las autoridades, el hecho de "que una identificación sea precisa o no puede costarle a una persona su libertad o incluso su vida".

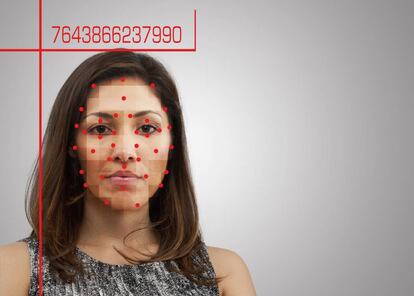

De los distintos tipos de sistemas de reconocimiento facial que existen, los más seguros son aquellos que se apoyan en criterios biométricos, que escogen determinados puntos y distancias de una cara para generar un digital faceprint. "Sería algo así como decir que cada uno de nosotros tenemos una huella facial única al transformarse esos puntos y distancias en un vector numérico. Algunos puntos son la separación entre ojos o el tamaño de la mandíbula. De esta forma se evita hacer el reconocimiento por comparación de imágenes, un método en el que influyen las condiciones de luz y ambientales, lo que haría mucho más complicado identificar caras", explica Nerea Luis Mingueza, investigadora en robótica e inteligencia artificial de la Universidad Carlos III de Madrid.

¿Forman parte de la estrategia de las tecnológicas para mejorar sus sistemas de reconocimiento el juego de los 10 años de Facebook o el de "sube un selfi y busca la obra de arte que se parece a ti", de Google Arts & Culture?

Google, Apple, Facebook o Amazon centran sus esfuerzos en incorporar el análisis de rostros en sus dispositivos (sobre todo smartphones, aunque no solo). La mayoría de teléfonos de gama alta y media fabricados en los últimos años cuentan con lectores de huellas dactilares. En 2017, Apple presentó el iPhone X, su primer dispositivo capaz de desbloquearse con un escaneo del rostro del usuario. Este método de autenticación funciona también en algunos teléfonos Android, como el Samsung Galaxy Note 9, que cuenta con un sistema de seguridad biométrico que combina el reconocimiento facial y de iris.

Las compañías defienden que estos sistemas funcionan hasta con gafas de sol. Con muchas, porque se deben exceptuar aquellas diseñadas para bloquear algún tipo de luz, como la infrarroja que usan las cámaras de reconocimiento (una idea por si en un futuro necesitas camuflarte a lo Tom Cruise en Minority Report).

Inteligencias artificiales racistas y machistas

Más allá de lo accesorio, la prueba que se llevó a cabo con el reconocimiento facial de Amazon puso de relieve la amenaza que el sistema de Bezos puede representar para las mujeres negras. Los porcentajes de error quedaron así: 35% para muejres de piel oscura, 12% para hombres de piel oscura, 7% para mujeres de piel blanca y 1% para hombres de piel blanca. Esto se debe a que los datos con los que los algoritmos son entrenados pueden estar condicionados por nuestros conocimientos y prejuicios.

"Los algoritmos generalmente se desarrollan porque, mayoritariamente, hombres blancos de entre 25 y 50 años así lo han decidido durante una reunión", explica la investigadora en robótica e inteligencia artificial de la Universidad Carlos III. Por lo tanto, según señala, "los grupos infrarrepresentados siempre se verán más afectados por los productos tecnológicos". Es el caso, de la población negra. En junio de 2015, un usuario de Google Photos descubrió que el programa etiquetaba a sus amigos negros como gorilas. La inteligencia artificial de Google no era capaz de distinguir una tez oscura de humano de la de simios como gorilas y chimpancés.

Contribuir o no contribuir a mejorar el algoritmo

Pese al enorme margen de error que arrojan, en China no solo se han comenzado a usar por parte de la policía, que lleva en su nuevo equipamiento unas gafas con reconocimiento. También hay equipos instalados en las puertas de las escuelas para combatir el absentismo escolar. La cantante estadounidense Taylor Swift usó un software de reconocimiento facial en un concierto que celebró el pasado mayo en Los Ángeles (EE UU) para detectar acosadores entre su público. Y estos sistemas se usan ya en aeropuertos y estaciones de transporte.

Normalmente las empresas que los usan aseguran que no recaban ni almacenan datos personales de los usuarios. Pero hay quienes se cuestionan que esto sea cierto (no hay más que recordar el caso Cambridge Analytica, cuando la consultora británica extrajo datos de más de 70 millones de usuarios de la red social en Estados Unidos).

En el caso del #10yearchallenge, el debate lo planteó en Twitter la periodista tecnológica de la revista tecnológica Wired, Kate O’Neill. "Yo hace 10 años: probablemente hubiera jugado con la foto de perfil con este meme del envejecimiento que está dando vueltas en Facebook e Instagram. Yo ahora: ponderar cómo todos estos datos podrían usarse para entrenar a los algoritmos de reconocimiento facial sobre progresión y reconocimiento de la edad", afirmó en la red social.

Los defensores del juego dicen que las fotos ya se encuentran en la red igualmente (aunque sin una cronología fiable y desperdigadas), y Facebook ha respondido que esta ha sido una iniciativa de los propios usuarios y que se ha viralizado sola.

En enero de 2018 la actriz Alyssa Milano también puso en duda en Twitter la fiabilidad de la aplicación Google Arts & Culture. Desde Google afirman que no existe una base de datos con fotografías y que sólo se almacenan el tiempo que la función tarda en encontrar las coincidencias (lo cual no significa que no se esté entrenando a su inteligencia artifical).

Contribuir a entrenar a los sistemas de reconocimiento facial no tiene por qué ser algo malo per se. Detrás hay una cuestión de pensamiento. Es un intercambio: pérdida de privacidad a cambio de la promesa de mayor seguridad. La respuesta dependerá de lo cómodo que cada uno se sienta con este trueque, hasta dónde está dispuesto a llevarlo, y la motivación será el grado de inseguridad que cada cual perciba (no faltan esfuerzos por parte de grupos de poder por magnificarla).

No todos los usos que se dan a estos sistemas de identificación suponen un riesgo. El año pasado la policía de Nueva Delhi los aplicó para encontrar a más de 3.000 niños desaparecidos y, si la máquina fuera capaz de predecir los cambios físicos que se producen con la edad, esta búsqueda podría ampliarse a menores desaparecidos hace, digamos, 10 años.

También el reconocimiento facial (y de edad) puede usarse para fines que no percibimos ni como buenos ni como malos. Afinar la segmentación de campañas publicitarias, como en Piccadilly Circus, sería un ejemplo. Pero sin duda plantea dilemas éticos importantes, ya que, además de los posibles sesgos, gobiernos y empresas podrían utilizar esta tecnología como una herramienta de vigilancia.

Es fundamental que los diseñadores de estos sistemas garanticen la privacidad de los usuarios. Varias empresas como Telefónica o Microsoft ya han publicado sus principios para hacer un uso responsable de la inteligencia artificial. Pero aún queda mucho camino por recorrer. Un informe del AI Now Institute, un influyente instituto de investigación con sede en Nueva York, acaba de nombrar el reconocimiento facial como un desafío clave para la sociedad y los legisladores en los próximos años.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.

Archivado En

- Cámaras video

- Reconocimiento voz

- Inteligencia artificial

- Aplicaciones informáticas

- Identificacion

- Computación

- Redes sociales

- Apple

- Buscadores

- Alphabet

- Seguridad nacional

- Policía

- Software

- Fuerzas seguridad

- Defensa

- Informática

- Internet

- Empresas

- Economía

- Telecomunicaciones

- Industria

- Comunicaciones

- Justicia

- Living

- ICON Design