Máquinas que matan sin intervención humana: la carrera para crearlas aventaja a los esfuerzos por regularlas

La ONU lleva más de seis años intentando establecer un marco normativo para los llamados robots asesinos

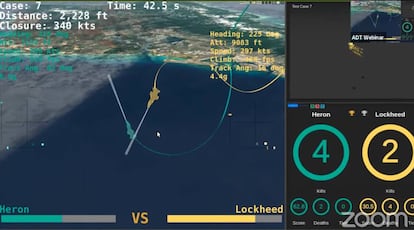

En 2024, el Pentágono espera enfrentar a pilotos humanos contra aviones controlados por inteligencia artificial en duelos reales. Lo anunció el Secretario de Defensa de los Estados Unidos, Mark Esper, en una intervención reciente. A mediados de agosto, los algoritmos desarrollados por Heron Systems ya habían demostrado ser capaces de vencer a pilotos humanos en enfrentamientos simulados. Para Esper, la hazaña es una prueba del “impacto tectónico” que la inteligencia artificial y el machine learning van a tener en las guerras del futuro. Para quienes piden una regulación que controle el desarrollo de armas capaces de matar sin intervención humana, es un indicio más de que la humanidad llega tarde.

“Incluso en estos tiempos de disrupción seguimos viendo más y más informes de nuevos tipos de armas que se están estudiando, desarrollando y probando y que incorporan autonomía en sus funciones críticas”. Estas fueron las palabras elegidas la semana pasada por Izumi Nakamitsu, secretaria general adjunta y alta representante para asuntos de desarme de la ONU, para inaugurar el encuentro del grupo de expertos gubernamentales sobre sistemas de armas letales autónomas (LAWS, por sus siglas en inglés) en la Convención sobre las Armas Convencionales de la misma entidad. Nakamitsu señaló también la urgencia de los avances del grupo, que lleva más de seis años reuniéndose para buscar un marco que regule estas armas. Una vez más y después de cinco días de conversaciones, no hay resultados tangibles.

"Llevamos un año en una situación de atasco. Hay una serie de potencias en la convención que no tienen interés en que surja una regulación vinculante", señala Joaquín Rodríguez, miembro de ICRAC y coordinador de la campaña Stop Killer Robots en España. A este boicot suma la falta de decisión de otros países entre los que incluye a España. "La Unión Europea ha emitido diversas resoluciones pidiendo a los estados que se involucren en la negociación. Luego todo acaba quedando relativamente en papel mojado", lamenta. Hasta el papa Francisco ha entrado en el debate. "Estamos presenciando una erosión del multilateralismo que es incluso más seria a la vista del desarrollo de nuevas formas de tecnología militar, como los sistemas de armas letales autónomas, que irreversiblemente alteran la naturaleza de la guerra, desvinculándola del control humano", advirtió el viernes en la 75 Asamblea General de la ONU.

Inevitablemente tarde

Las armas con diferentes grados de autonomía ya existen. "El avión no tripulado X-47B de la Marina de Estados Unidos, con un alcance de 3.800 km y una autonomía de seis horas de vuelo sin repostar, puede despegar de un portaaviones, volar al objetivo, ser reabastecido en vuelo, destruir el objetivo, regresar y aterrizar en el portaaviones", precisa Francisco Rubio Damián, coronel de Infantería de la Academia Militar de Zaragoza y director de la Ciudadela de Jaca. “Es normal que las potencias militares desarrollen armas que les den una ventaja estratégica decisiva sobre sus enemigos. Es inevitable y pensar lo contrario sería solo un loable ejercicio de candidez”, razona Rubio, doctorado en Sociología y experto en Seguridad Global y Defensa.

En 2017, Estados Unidos, Rusia e Israel concentraban más de la mitad de los proyectos mundiales de desarrollo de armas con algún tipo de autonomía en sus funciones, de acuerdo con los últimos datos recopilados por el Instituto Internacional de Estudios para la Paz de Estocolmo (Sipri). Las categorías más frecuentes eran entonces aeronaves y sistemas terrestres no tripulados, y sistemas de defensa antiaérea. Para Rubio Damián, la falta de avances en las negociaciones para que esa autonomía no se emplee de manera indiscriminada en funciones letales responde en parte al retraso en acometerlas. "Las reuniones se iniciaron cuando Estados Unidos, China y Rusia llevaban años en su particular carrera armamentística desarrollando robots militares".

En ausencia de una regulación específica, el desarrollo de sistemas de armas letales autónomas se rige por lo que establece el derecho internacional humanitario (DIH). En este contexto, cualquier uso de fuerza debe cumplir los principios de proporcionalidad (los daños a civiles no deben ser excesivos en relación con la ventaja militar anticipada con la acción), distinción (debe hacerse todo lo posible por identificar inequívocamente a civiles y combatientes) y necesidad (el objetivo debe justificarse como esencial para el avance del conflicto). “El DIH pone los umbrales mínimos que deben satisfacer estas armas, al crear un marco que aplica a cualquier arma autónoma. Sin embargo, las leyes actuales fracasan a la hora de establecer un rendimiento de cuentas por los crímenes que se cometan con sistemas automatizados”, explica Bryan McMahon, investigador en políticas de inteligencia artificial.

Imprevisibilidad y cajas negras

¿Por qué importa esto? Por que estas armas pueden cometer errores en el campo de batalla. Igual que ocurre en las carreteras, los juicios, la identificación de individuos y la vida real en general, el uso de estos sistemas puede derivar en resultados imprevisibles o imposibles de explicar. Arthur Holland, investigador asociado de inteligencia artificial y autonomía del Instituto para la investigación del desarme de las Naciones Unidas (UNIDIR), compara los riesgos de la autonomía en un arma con los que entrañaría una tostadora. “Pongamos que tienes una tostadora diseñada para funcionar en una cocina con la temperatura controlada, y la utilizas a temperaturas bajo cero. Seguramente no funcionará igual”, explicó la semana pasada en el coloquio organizado por UNIDIR en paralelo al encuentro del grupo de expertos. Su interlocutora, Pascale Fung, es directora del Centro para la Investigación en Inteligencia Artificial en Hong Kong y atribuye este fallo al entorno: cuando un sistema no está entrenado para determinados escenarios puede no ser capaz de gestionarlos.

"Además, a veces el problema no es el entorno sino el input. Si tu tostadora estaba entrenada para tostar pan de centeno y en las pruebas de campo introduces un bagel, el resultado puede ser cualquier otro", explicó Fung. El problema es que en este caso no están en juego el desayuno y las paredes de la cocina, sino las vidas de quienes se ven envueltos por un conflicto bélico: una máquina entrenada en zonas boscosas puede fallar en el desierto y otra entrenada para detectar objetivos con imágenes de personas caucásicas puede funcionar de manera distinta ante individuos de otras razas.

¿Llegarán a la guerra?

No está próximo el momento en que veamos Terminators en el campo de batalla. Un sistema así implicaría un nivel de sofisticación que no se ha alcanzado. Además, las guías elaboradas por el grupo de expertos en su reunión de 2019 recomiendan evitar el desarrollo de armas autónomas con forma humana. "Los expertos afirman que antropomorfizar los robots podría llevarnos a expectativas poco realistas de la capacidad de razonamiento y juicio moral de las máquinas", explica McMahon.

Sin embargo, el experto está convencido de que veremos otros conceptos armas capaces de matar sin intervención humana antes de lo que pensamos: "Aunque la tecnología no está madura todavía, la creciente presión geopolítica empuja las LAWS cada vez más cerca del campo de batalla". Rubio, por su parte, admite que la tecnología existe, pero cree que es "poco probable" que la veamos en acción. "Las potencias militares harán todo lo que sea necesario para no estigmatizar esta tecnología y evitarán por todos los medios que se produzca un error fatal que pueda ser achacado al empleo de robots militares".

A la imprevisibilidad se suman las dificultades para seguir y comprender el razonamiento del algoritmo. Un sistema puede aparentar absoluta precisión en el reconocimiento de combatientes y estar basando su identificación no en las personas, sino en el paisaje de fondo. Si no se abre la caja negra y se desentraña la lógica fallida de estas decisiones, no es posible corregir el error. "La tecnología creada para hacer más humana la guerra puede convertirse en las armas más brutales del campo de batalla", advierte McMahon.

"Uno de los principales problemas a los que nos enfrentamos es que hay Estados que repiten como un mantra afirmaciones que son mentira", comienza Rodríguez. El portavoz de ICRAC se refiere a quienes aseguran que es posible crear LAWS a prueba de errores. "Siempre hay márgenes de error", insiste. En este contexto, la exigencia contra la que reman las grandes potencias bélicas es que siempre haya una persona al volante en el momento en que la máquina plantea una acción letal. ¿Es suficiente? Al menos entra dentro de lo humanamente controlable, señala Rubio. "Debería ser garantía suficiente de que el robot militar no provocará daños superfluos o sufrimientos innecesarios. Si otorgamos esa confianza en el soldado-combatiente, aunque no siempre cumpla, no hay motivos para no otorgar la misma confianza al soldado-operador del sistema autónomo".

En noviembre, el grupo de expertos volverá a reunirse, pero Rodríguez se muestra escéptico, dada la complejidad de la situación. "Los recursos que se están manejando son altísimos. Pensar que todos esos países están dispuestos a congelar los activos que han puesto en investigación armamentística es poco realista", argumenta. El experto no descarta que estas negociaciones puedan avanzar fuera del marco de la ONU, pero insiste en que la institución sería el marco ideal. "Los países que están realizando un boicot no solo están dificultando este tratado sino la resolución de controversias a escala internacional de una manera dialogada".

Puedes seguir a EL PAÍS TECNOLOGÍA RETINA en Facebook, Twitter, Instagram o suscribirte aquí a nuestra Newsletter.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.