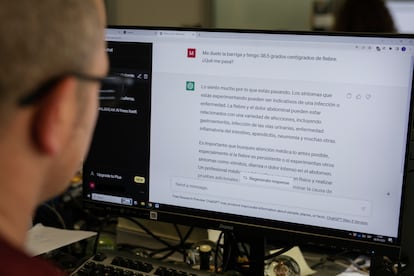

Doctor ChatGPT: cara y cruz de la inteligencia artificial en la consulta

Un estudio muestra que el ‘chatbot’ mejora a los médicos con consejos más empáticos y de calidad ante preguntas de pacientes, pero los expertos reclaman que siempre haya supervisión final del facultativo

Ante la consulta de un ciudadano sobre el riesgo de morir después de tragar un palillo de dientes, dos respuestas. La primera señala que entre dos o seis horas después de la ingesta, es probable que haya pasado ya a los intestinos y, además, mucha gente traga palillos sin que pase nada, pero advierte de que si siente “dolor de estómago”, vaya a urgencias. La segunda respuesta va en la misma línea e insiste en que, aunque es normal la preocupación, es poco probable que ocurra un daño grave tras tragar un palillo porque está hecho de madera, que no es un material tóxico ni envenena, y es un utensilio pequeño; sin embargo, agrega, si tiene “dolor abdominal, dificultad para tragar o vómitos”, debe acudir al médico: “Es comprensible que te sientas paranoico, pero trata de no preocuparte demasiado”, le consuela.

Las dos respuestas dicen lo mismo en el fondo, pero cambian en las formas. Una es más aséptica y escueta; otra, más empática y detallada. La primera ha sido generada por un médico, de su puño y letra, y la segunda, por ChatGPT, la herramienta generativa de inteligencia artificial (IA) que ha revolucionado el planeta en los últimos meses. El estudio en el que se enmarca este experimento, publicado en la revista Jama Internal Medicine, quiso profundizar en el papel que podrían tener los asistentes de IA en medicina y comparó las respuestas que daban médicos reales y el chatbot a cuestiones de salud planteadas por ciudadanos en un foro de internet. Las conclusiones, tras el análisis de las respuestas por parte de un panel externo de profesionales de la salud que desconocía quién había respondido qué cosa, es que, en el 79% de las veces, las explicaciones de ChatGPT eran más empáticas y de mayor calidad.

La explosión de las nuevas herramientas de IA en el mundo ha abierto el debate sobre su potencial también en el campo de la salud. El ChatGPT, por ejemplo, busca su hueco como apoyo a los sanitarios para desarrollar procedimientos médicos o para evitar tareas burocráticas y, a pie de calle, planea ya como un eventual sustituto del impreciso y, a menudo, desatinado doctor Google. Los expertos consultados aseguran que se trata de una tecnología con mucho potencial, pero está en pañales: hay que afinar todavía el campo regulatorio en su aplicación en la práctica médica real, solventar las dudas éticas que puedan surgir y, sobre todo, asumir que es una herramienta falible y que puede equivocarse. Todo lo que salga de ese chatbot requerirá siempre la revisión final de un profesional de la salud.

Paradójicamente, la voz más empática en el estudio de Jama Internal Medicine es la máquina y no el humano. Al menos, en la respuesta escrita. Josep Munuera, jefe del Servicio de Diagnóstico por la Imagen del Hospital Sant Pau de Barcelona y experto en tecnologías digitales aplicadas a la salud, advierte de que el concepto de empatía es más amplio de lo que puede cristalizar ese estudio. No es lo mismo la comunicación escrita que un cara a cara, ni las dudas planteadas en el contexto de una red social que dentro de una consulta. “Cuando hablamos de empatía, hablamos de muchos temas. De momento, es difícil sustituir el lenguaje no verbal, que es muy importante cuando un médico tiene que hablar con un paciente o su familia“, puntualiza. Pero sí admite el potencial de estas herramientas generativas para aterrizar el argot médico, por ejemplo: “En la comunicación escrita, el lenguaje técnico médico puede ser complejo y podemos tener dificultad para traducirlo a un lenguaje entendible. Probablemente, estos algoritmos encuentren la equivalencia entre la palabra técnica y otra adaptada al receptor”.

Joan Gibert, bioinformático y referente en desarrollo de modelos de IA en el Hospital del Mar de Barcelona, añade otra variable a la hora de valorar la potencial empatía de la máquina frente al médico. “En el estudio se mezclan dos conceptos que entran en la ecuación: el ChatGPT en sí, que puede ser útil en ciertos escenarios y que tienen la capacidad de concatenar palabras que nos generan la sensación de que es más empático, y el burnout de los médicos, ese agotamiento emocional a la hora de atender a los pacientes que no le deja a los clínicos capacidad para ser más empáticos”, explica.

El peligro de las “alucinaciones”

En cualquier caso, y como ocurre con el famoso doctor Google, hay que tener cuidado siempre con las respuestas que arroja el ChatGPT, por muy sensible o amable que pudiera parecer. Los expertos recuerdan que el chatbot no es un médico y puede fallar. A diferencia de otros algoritmos, ChatGPT es generativo, es decir, crea información a partir de las bases de datos con las que se ha entrenado, pero puede que algunas respuestas que lanza se las invente. “Siempre hay que tener en cuenta que no es un ente independiente y no puede servir de herramienta de diagnóstico sin supervisión”, insiste Gibert.

Estos chats pueden sufrir lo que los expertos llaman “alucinaciones”, explica el bioinformático del Mar: “En según qué situaciones, te afirma una cosa que no es cierta. El chat junta palabras de forma que tienen coherencia y como tiene mucha información, puede ser valioso. Pero tiene que estar revisado porque, si no, puede alimentar las fake news”. Munuera destaca la importancia, además, de “conocer la base de datos que ha entrenado al algoritmo porque si las bases de datos son insuficientes, la respuesta también lo será”.

“Hay que entender que cuando le pides que te haga un diagnóstico, puede que invente una enfermedad”Josep Munuera, Hospital Sant Pau de Barcelona

En la calle, los potenciales usos de ChatGPT en salud son limitados, pues la información que arrojan puede llevar a errores. Jose Ibeas, nefrólogo del Hospital Parc Taulí de Sabadel y secretario del Grupo de Big Data e Inteligencia Artificial de la Sociedad Española de Nefrología, señala que es “útil para las primeras capas de información porque te sintetiza información y ayuda, pero cuando se entra en una zona más específica, en patologías más complejas, la utilidad es mínima o errónea”. Munuera coincide y enfatiza que “no es un algoritmo que ayude a resolver dudas”. “Hay que entender que cuando le pides que te haga un diagnóstico diferencial, puede que invente una enfermedad”, alerta. Y, de la misma forma, el algoritmo puede responder a las dudas de un ciudadano concluyendo que no es nada grave cuando, en realidad, sí lo es: ahí se puede perder una oportunidad de atención sanitaria porque la persona se queda conforme con la respuesta del chatbot y no consulta a un médico real.

Donde más margen de maniobra encuentran los expertos a estas aplicaciones es como herramienta de apoyo a los profesionales de la salud. Por ejemplo, para ayudar a responder a preguntas de pacientes por escrito, aunque siempre bajo supervisión del médico. El estudio de Jama Internal Medicine plantea que ayudaría a “mejorar el flujo de trabajo” y los resultados de los pacientes: “Si las preguntas de más pacientes se responden rápidamente, con empatía y en un alto nivel, podría reducir las visitas clínicas innecesarias, liberando recursos para quienes los necesitan. Además, los mensajes son un recurso fundamental para fomentar la equidad del paciente, donde las personas que tienen limitaciones de movilidad u horarios de trabajo irregulares, es más probable que recurran a los mensajes”, convienen los autores.

La comunidad científica también estudia emplear estas herramientas para otros trabajos repetitivos, como cubrir fichas e informes. “Partiendo de la premisa de que siempre, siempre, siempre, todo necesitará revisión por parte del médico”, puntualiza Gibert, el apoyo en tareas burocráticas —repetitivas, pero importantes— liberan tiempo para que los médicos lo dediquen a otras cuestiones, como el propio paciente. Un artículo publicado en The Lancet plantea, por ejemplo, su potencial para agilizar los informes de alta: la automatización de este proceso podría aliviar cargas de trabajo e incluso mejorar la calidad de los informes, aunque son conscientes, dicen los autores, de las dificultades para entrenar los algoritmos con amplias bases de datos y, entre otros problemas, del riesgo de “despersonalización de la atención”, algo que podría generar resistencias a esta tecnología.

Ibeas insiste en que, para cualquier uso médico, habrá que “validar” esta clase de herramientas y fijar bien el reparto de responsabilidades: “Los sistemas nunca va a decidir. El que firma siempre al final es el médico”, sentencia.

Problemas éticos

Gibert apunta también algunas consideraciones éticas que hay que tener en cuenta al aterrizar estas herramientas a la práctica clínica: “Necesitas que este tipo de tecnología esté bajo un paraguas legal, que haya soluciones integradas dentro de la estructura del hospital y asegurar que los datos de los pacientes no sean usados para reentrenar el modelo. Y si alguien quiere hacer esto último, que lo haga dentro de un proyecto, con datos anonimizados y siguiendo todos los controles y regulaciones. No se puede compartir información sensible de pacientes a la brava”.

El bioinformático señala también que estas soluciones de IA, como el ChatGPT o modelos que ayudan al diagnóstico, introducen “sesgos” en el día a día del médico. Por ejemplo, que condicione la decisión del médico, en un sentido o en otro. “El hecho de que el profesional tenga el resultado de un modelo de IA, modifica al propio evaluador: la forma de relacionarse puede ser muy buena, pero puede introducir problemas, sobre todo, en profesionales que tienen menos experiencia. Por eso el proceso se tiene que hacer de forma paralela: hasta que el profesional no dé el diagnóstico, no puede mirar qué dice la IA”.

Un grupo de investigadores de la Universidad de Stanford también reflexionaron en un artículo en Jama Internal Medicine sobre cómo estas herramientas pueden ayudar a humanizar más la atención sanitaria: “La práctica de la medicina es mucho más que procesar información y asociar palabras con conceptos; es atribuir significado a esos conceptos mientras se conecta con los pacientes como un socio confiable para construir vidas más saludables. Podemos esperar que los sistemas de inteligencia artificial emergentes puedan ayudar a domar las tareas laboriosas que abruman a la medicina moderna y empoderar a los médicos para volver a enfocarnos en el tratamiento de pacientes humanos.”

A la espera de ver cómo se expande esta tecnología incipiente y cuáles son sus repercusiones, de cara a la ciudadanía, Munuera insiste: “Hay que entender que [ChatGPT] no es una herramienta médica y no hay un profesional de la salud que pueda confirmar la veracidad de la respuesta. Hay que ser prudente y entender cuáles son los límites”. En síntesis, prosigue Ibeas: “El sistema es bueno, robusto, positivo y es el futuro, pero como cualquier herramienta, hay que saber conducirla para que no se convierta en un arma”.

Puedes seguir a EL PAÍS Salud y Bienestar en Facebook, Twitter e Instagram.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.