La máquina de la moral y otras ideas para que los coches tomen decisiones correctas

Una máquina de la moral y filósofos colaboran con el MIT para enseñar a los coches a resolver un accidente con el menor número de víctimas posible

De entre todas las dudas que suscitan los coches autónomos, las que tienen que ver con su capacidad para tomar decisiones son las que más debate generan. Muchos usuarios aún temen que el coche pueda cometer un error y estrellarse. Pero lo cierto es que se equivocan mucho menos que los conductores humanos y que el drama real puede venir porque el coche tome la decisión de estrellarse y sacrificar a los pasajeros. Visto así parece parte de la trama de La rebelión de las máquinas, pero es algo que podría suceder en una situación en la que el daño fuera inevitable y el coche tuviera que decidir entre atropellar a tres peatones o estrellarse y dañar a un pasajero. Es como el dilema de accionar una palanca para que un tren arrolle a una persona o no accionarla y dejar que arrolle a cinco. Pero en la vida real. En este escenario, ¿quién enseña a las máquinas a elegir? ¿Quién decide qué es más correcto en cada situación?

- La máquina de la moral

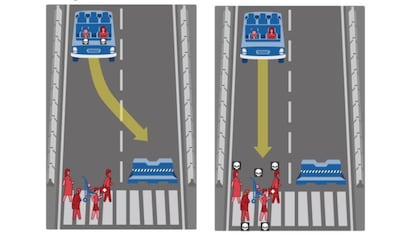

El Instituto Tecnológico de Massachusetts (MIT) trabaja con una máquina de la moral a la que han llamado Moral Machine. Es un sistema de inteligencia artificial que presenta distintos escenarios en los que los coches tienen que tomar decisiones a la hora de resolver un accidente con el menor número de víctimas posible. En estas situaciones se asume que frenar y evitar la colisión no es una opción: se trata de casos en los que el automóvil está 100% seguro de que alguien sufrirá daño pero puede actuar para seleccionar quién lo sufrirá.

Las situaciones se presentan en una página web donde cualquier persona puede jugar a decidir qué cree que debería hacer el coche en cada uno de los ejemplos. Los datos recogidos pasan a formar parte de un estudio sobre la ética de las máquinas autónomas elaborado por científicos del MIT Media Lab. En este caso, se están utilizando decisiones de la mayoría de las personas que participan para estudiar cómo los humanos creen que se deberían programar los coches autónomos. La inteligencia artificial se convierte una vez más en un reflejo de nuestras decisiones humanas.

A través de distintas preguntas, los investigadores tratan de establecer cuál sería el comportamiento más adecuado que debería tener un coche sin conductor desde un punto de vista moral para la mayoría. Analizando los resultados, los responsables han detectado que "casi por unanimidad la gente quiere coches que minimicen los daños totales". Así lo explicaba Iyad Rahwan, director de Scalable Cooperation en el MIT Media Lab, en una entrevista para Vodafone One.

Pero aún minimizándose los daños, ¿quién debe salvarse con más prioridad? ¿Quién ha respetado las señales de tráfico? ¿Los más jóvenes? ¿Los más sanos? ¿Un médico frente a un ladrón? ¿Podrán los coches llegar a detectar si una mujer está embarazada o a qué se dedican los transeúntes? Los expertos no se atreven a vaticinarlo pero todo apunta a que esta tecnología está más limitada por las cuestiones morales que por sus posibilidades de desarrollo.

- También los filósofos

En colaboración con el MIT, los especialistas en ética y filósofos han encontrado un nicho en el que contribuir a la programación de las máquinas. Ya en 2015 se organizó un congreso en la Universidad de Stanford —uno de los puntos calientes en los que se están realizando estos debates— para reunir a ingenieros y filósofos y debatir sobre la naturaleza de las decisiones de los coches autónomos. Implementaron distintas configuraciones éticas dentro del software que controla los vehículos autónomos y luego probaron el código en simulaciones e incluso en vehículos reales.

Mientras que algunos trabajan en enseñar a pensar a las máquinas, otros defienden que los coches sin conductor no deberían tomar decisiones sobre la vida o la muerte, esa es al menos la teoría que defiende el filósofo Wendell Wallach, autor de A dangerous master: how to keep technology from slipping beyond our control. Según Wallach, asumir que los coches deberían tomar estas decisiones implica aceptar que pueden sustituirnos como agentes morales. Aunque es cierto que su procesador puede analizar los datos de la situación en milésimas de segundo y tomar una decisión, las máquinas carecen de empatía y de la capacidad de captar matices.

- El verdadero dilema

Más allá de las decisiones que debe tomar el coche, los pasajeros deben plantearse una cuestión fundamental: ¿te montarías en un coche que, llegado el momento, elegiría estrellarse y sacrificarte? La respuesta de la mayoría fue la primera que te viene a la mente: ¡no! Iyad Rahwan lo explica: "El problema viene cuando les preguntamos si comprarían ese coche. Su reacción fue: nunca compraría un coche que me pudiera hacer daño a mí bajo ninguna circunstancia". Y Alfonso Rodríguez-Patón, profesor de la Universidad Politécnica de Madrid, está de acuerdo: "La mayoría de los ciudadanos van a querer que su coche les salve primero a ellos", explica. "Piensan: "que mi coche sea seguro pero para mí primero".

Pero probablemente en un futuro se regule el comportamiento ético de los coches totalmente autónomos alcanzando algún tipo de consenso ético. "Si no, cada fabricante podrá resolver estos dilemas de diferente manera", añade Rodríguez-Patón. También señala que será difícil llegar a programar el comportamiento perfecto en todos los potenciales casos no anticipados o previstos. "Muchas de estas cuestiones no están todavía ni mucho menos resueltas e implican dilemas muy complejos. Que se preparen las compañías de seguros y los abogados".

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.