Dos investigaciones dotan de visión más ‘humana’ a coches sin conductor

Los estudios avanzan en sistemas para que vehículos y robots miren, analicen y discriminen la información relevante para tomar decisiones en milisegundos

Los vehículos de conducción autónoma dependen de un sentido tan crucial para el ser humano como la visión. No se trata solo de que la máquina sea capaz de ver, que ya lo hace, sino de mirar, analizar, discriminar y proceder en milisegundos. El reto es alcanzar esta característica de las personas en el tiempo justo para tomar la decisión necesaria. Para una máquina, por ejemplo, ver un árbol junto a la vía es fácil. Lo difícil es saber que no es un objeto que se va a mover ni a interponer en el camino, y lo contrario si se trata de un peatón. La revista científica Nature publica este miércoles dos avances en este sentido: un procesador para responder rápidamente a un evento con la mínima información y un nuevo sistema (algoritmo) para mejorar la precisión de la visión mecánica con menor latencia (tiempo de respuesta).

Estas investigaciones, que son fundamentales para el desarrollo de vehículos de conducción autónoma o la robótica, ya cuentan con desarrollos avanzados en el Instituto de Microelectrónica (Imse) en la capital andaluza, del Consejo Superior de Investigaciones Científicas (CSIC) y la Universidad de Sevilla. Multinacionales como Samsung y Sony ya usan las patentes que comercializa la empresa Prophesee.

Los dos trabajos que publica Nature son innovaciones sobre estos sistemas basados en la foveación, el mecanismo humano que permite maximizar la resolución en la zona donde se enfoca la vista, mientras que la baja en las áreas de visión periférica no relevante. De esta forma, se reduce la cantidad de información, pero se mantiene la capacidad de reconocimiento visual de los datos imprescindibles para la toma de decisiones en milisegundos.

La clave es la interpretación precisa de la escena y una rápida detección de movimiento para permitir reacciones inmediatas. Las cámaras convencionales pueden captar la imagen de un encuadre y la reproducen a altísima resolución, pero toda esa información tiene que ser procesada y discriminada, lo que supone un tiempo y un gasto de recursos incompatibles con las decisiones instantáneas que exige la conducción autónoma o la robótica avanzada.

Uno de los avances lo firman Daniel Gehrig, investigador de la Universidad de Pensilvania (EE UU), y Davide Scaramuzza, profesor de robótica en la Universidad de Zúrich (Suiza). Ambos han abordado la dificultad de la toma de decisiones con imágenes de alta resolución a color. Estas precisan un gran ancho de banda para ser procesadas con la fluidez necesaria y reducir esta alta capacidad a costa de mayor latencia, de más tiempo para responder. La alternativa es usar una cámara de eventos, las que procesan flujos continuos de impulsos, pero sacrificando precisión.

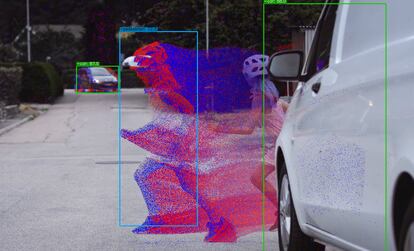

Para hacer frente a estas limitaciones, los autores han desarrollado un sistema híbrido que logra la detección eficaz de objetos con la mínima latencia. El algoritmo combina la información de dos cámaras: una que reduce la velocidad de los fotogramas en color para reducir el ancho de banda necesario y otra de eventos que compensa esa pérdida de latencia, garantizando que los objetos que se mueven rápidamente, como peatones y automóviles, puedan ser detectados. “Los resultados allanan el camino hacia la detección eficiente y precisa de objetos, especialmente en escenarios extremos”, afirman los investigadores.

“Es un gran avance. Los sistemas actuales de asistencia al conductor, como los de MobileEye —que están integrados en más de 140 millones de automóviles en todo el mundo— funcionan con cámaras estándar que toman 30 fotogramas por segundo, es decir, una imagen cada 33 milisegundos. Además, requieren un mínimo de tres fotogramas para detectar de forma fiable a un peatón o a un coche. Esto eleva el tiempo total para iniciar la maniobra de frenado a 100 milisegundos. Nuestro sistema permite reducir este tiempo por debajo de un milisegundo sin necesidad de utilizar una cámara de alta velocidad, lo que supondría un enorme coste computacional”, explica Scaramuzza.

Los sistemas actuales elevan el tiempo total para iniciar la maniobra de frenado a 100 milisegundos. Nuestro algoritmo permite reducir este tiempo por debajo de un milisegundo sin necesidad de utilizar una cámara de alta velocidadDavide Scaramuzza, profesor de robótica en la Universidad de Zúrich (Suiza)

La tecnología ha sido “transferida a una empresa de primer nivel”, según explica el investigador. “Si se aprobara, por lo general, pueden pasar muchos años desde una prueba de concepto hasta las de impacto y la implementación final”, añade.

Por su parte, Luping Shi, director del Centro de Investigación de Computación Inspirada en el Cerebro (CBICR por sus siglas en inglés) de la Universidad de Tsinghua (China), ha desarrollado con su equipo el chip (procesador) Tianmouc. Inspirado en la forma en que funciona el sistema visual humano, combina percepciones rápidas e imprecisas, como las de la visión periférica humana, con otras de mayor resolución y más lentas para procesarlas.

De esta forma, el chip trabaja también como una cámara de eventos, que en vez de fotogramas completos procesa flujos continuos de impulsos eléctricos (eventos o spikes) registrados por cada fotosensor cuando detecta un cambio suficiente de luz. “Tianmouc tiene una matriz de píxeles híbridos: unos de baja precisión, pero de rápida detección, basados en eventos para permitir respuestas rápidas a los cambios sin necesidad de demasiados detalles y otros de procesamiento lento para producir una visualización precisa de la escena”, explica el investigador. El chip se ha probado en escenarios como un túnel oscuro iluminado repentinamente por una luz deslumbrante o en una carretera por la que cruza un peatón.

Bernabé Linares, profesor de investigación del Imse y responsable de la cámara de eventos comercial de mayor resolución, resalta que Scaramuzza utiliza drones para recoger imágenes de forma convencional y con cámaras de evento. “El avance es el algoritmo utilizado para el reconocimiento de los objetos y el resultado es interesante”, resalta.

El Imse trabaja principalmente con los procesadores, y señala que desarrollos algorítmicos como los de la Universidad de Zúrich son fundamentales como complemento de los chips y para aplicaciones robóticas. Al ser tecnologías muy compactas, precisan de sistemas de cálculos ligeros y que consuman poca energía. “Para los drones es un desarrollo importante. Les viene muy bien este tipo de cámaras de evento”, resalta.

El trabajo de Luping Shi es más cercano a los desarrollos del Grupo de Sistemas Neuromórficos del Imse. En este caso se trata de un procesador híbrido. “Los píxeles se van alternando y va calculando diferencias espaciales. Almacena la luz de una imagen y la siguiente y calcula el cambio. Si no hay modificación, la diferencia es cero. Aporta datos con muy poca frecuencia a partir de un sensor bastante sofisticado”, explica Linares.

Aunque los usos destacados por Nature se orientan a la conducción autónoma, los avances en visión tienen gran relevancia en robótica, que también precisa de capacidad de discriminar información para tomar decisiones a gran velocidad. Es el caso de los procesos de automatización industrial. “Pero a los fabricantes de automóvil les interesa mucho porque buscan todo tipo de desarrollos, ya que así es más seguro y pueden sacar el mejor partido a cada tecnología”, explica Linares, quien resalta que Renault es uno de los inversores de Prophesee.

Puedes seguir a EL PAÍS Tecnología en Facebook y X o apuntarte aquí para recibir nuestra newsletter semanal.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.