La regulación de la inteligencia artificial se acelera después de que controle ya todos los ámbitos

Un total de 28 países y la Unión Europea urgen la implantación de normas que eviten entre el 20% y el 30% de los efectos negativos que se esperan de los nuevos sistemas

La inteligencia artificial (IA) se ha metido en nuestras vidas de forma vertiginosa (hace menos de un año de la irrupción de ChatGPT) y dirige ya, sin que nos demos cuenta, casi todas las actividades cotidianas, desde las películas que vemos hasta nuestro trabajo, compras o relaciones. Un estudio sobre su uso en objetivos de sostenibilidad, publicado en Nature, detectó que entre el 70% y el 80% de los usos tienen consecuencias positivas, pero el resto de los efectos pueden ser negativos. Estos porcentajes son extrapolables a otras áreas y son cruciales porque afectan a las vidas, a la salud, a la convivencia, a la democracia o a la capacidad de desarrollo. Hasta ahora solo había principios éticos insuficientes. El presidente de EE UU, Joe Biden, acaba de firmar un decreto que obliga a las tecnológicas a notificar al Gobierno cualquier avance que suponga un “riesgo grave para la seguridad nacional”. El primer ministro británico, Rishi Sunak, ha convocado este miércoles y jueves una cumbre de la que ha surgido el primer compromiso de 28 países y de la UE sobre estos sistemas (Declaración de Bletchley) y la creación de un grupo de expertos para el seguimiento de sus avances. La Unión Europea ultima su propia norma: la AI Act. La vicepresidenta primera del Gobierno en funciones y ministra de Asuntos Económicos y Transformación Digital, Nadia Calviño, estima que se aprobará en las próximas semanas.

La Declaración de Bletchley reconoce la encrucijada actual: “La inteligencia artificial presenta enormes oportunidades globales: tiene el potencial de transformar y mejorar el bienestar humano, la paz y la prosperidad. Para lograr esto, afirmamos que, por el bien de todas las personas, la IA debe diseñarse, desarrollarse, implementarse y utilizarse de manera segura, centrada en el ser humano, confiable y responsable”.

La inteligencia artificial son sistemas y programas capaces de replicar tareas propias de su homóloga humana, como el aprendizaje, el razonamiento o la toma de decisiones. Se fundamenta en datos, el alimento básico, y en algoritmos, el conjunto metódico de pasos para hacer cálculos, resolver problemas y decidir a partir de la información disponible. Y puede llegar a hacerlo sin la intervención humana: el aprendizaje automático permite que las máquinas se instruyan a partir de sus propios procesos o de otros dispositivos.

Nació oficialmente como disciplina en una conferencia de ciencias de la computación en el Dartmouth College (New Hampshire, EE UU), en 1956. Sus padres fueron John McCarthy, de la Universidad de Stanford; Allen Newell, Herbert Simon, ambos de Carnegie Mellon; y Marvin Minsky, del Instituto Tecnológico de Massachusetts (MIT) y premio Fronteras del Conocimiento de la Fundación BBVA en 2014. Todos partían de la premisa de que las máquinas pueden imitar al cerebro. Pero tras décadas de un uso restringido, en los últimos años, su utilización se ha generalizado y extendido a todas las actividades, llegando a ser accesible mediante simples comandos de voz. Y aquí surgen su enorme potencial y los conflictos. “La IA debe ser la solución, pero no el problema”, defiende Coral Calero, catedrática de Lenguajes y Sistemas Informáticos de la Universidad de Castilla-La Mancha (UCLM) e integrante del Comité Español de Ética de la Investigación creado por el Ministerio de Ciencia e Innovación.

La Inteligencia artificial es capaz de identificar las alteraciones en el genoma que provocan la aparición de enfermedades o reducir a días el hallazgo de moléculas con propiedades medicinales u optimizar procesos industriales y crear puestos de trabajo o diagnosticar a través de imágenes o generar textos, vídeos y sonidos o recrear un personaje o elegir películas y productos a partir de los gustos del usuario o seleccionar inversiones. La lista es inabarcable.

Pero esa misma tecnología es uno de los vectores emergentes de fraude más preocupantes (secuestro de datos) y puede utilizarse para generar bulos, desprestigiar a una persona, manipular precios, alterar el mercado laboral (dejando empleos y trabajadores obsoletos), atacar a competidores, influir en la opinión pública en elecciones, fortalecer el alcance de una campaña de desinformación, crear y diseminar propaganda, especialmente en tiempos de guerra, o como arma machista. Un ejemplo de esto último ha sido la detención en Almendralejo, a finales de septiembre, de una veintena de menores por recrear con inteligencia artificial desnudos de compañeras de instituto.

Ricardo Vinuesa, profesor asociado en el KTH Real Instituto de Tecnología de Estocolmo e investigador de IA, ha sido uno de los primeros en evaluar los efectos de esta tecnología a partir de su uso para alcanzar metas de sostenibilidad. “El 70% de los objetivos pueden verse afectados positivamente por la IA, pero alrededor del 30% pueden verse afectados negativamente. Tenemos muchos desafíos”, afirma en un encuentro celebrado en la Universidad de Sevilla.

En este sentido, Miguel Escassi, responsable de Política Pública en Google para España y Portugal advierte: “Tenemos una oportunidad única para acelerar el crecimiento económico y avanzar en todos los retos sociales que tenemos por delante. La capacidad de desplegar la inteligencia artificial e innovar con ella a gran escala definirá la competitividad en la próxima década. Sin embargo, para no dejar pasar estas oportunidades, los responsables políticos deben encontrar el equilibrio virtuoso entre maximizar las ventajas de la inteligencia artificial y minimizar sus riesgos, que también existen”.

Necesitamos regular la IA porque es demasiado importante para no hacerlo. Y no solo es necesaria la norma, sino hacerla bienPilar Manchón, consejera del comité de asesoramiento del Gobierno español y responsable de estrategia de investigación de Google

Pilar Manchón, consejera del comité de asesoramiento del Gobierno español y responsable de estrategia de investigación con inteligencia artificial también en Google, califica esta era marcada por la herramienta informática como “el nuevo renacimiento”, pero también reclama un marco de actuación: “Necesitamos regularla porque la IA es demasiado importante para no hacerlo. Y no solo es necesaria la norma, sino hacerla bien”.

“Tenemos que reducir las incertidumbres de la IA y esforzarnos en desarrollar herramientas que mejoren la calidad de los datos para estar seguros de que no se excluye ningún aspecto”, añade Matteo Rucco, científico de Rexasi-Pro, un proyecto europeo para desarrollar soluciones de inteligencia artificial confiables y no discriminatorias.

Si piensas en cómo trabaja la mente, cuando tomamos una decisión también imaginamos las consecuencias y eso debe ser parte de la inteligencia artificialMichael Beetz, investigador del Instituto de Inteligencia Artificial de la Universidad de Bremen

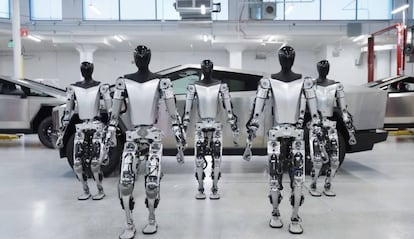

Michael Beetz, investigador del Instituto de Inteligencia Artificial de la Universidad de Bremen, se fija no solo en los prejuicios que el programador puede inferir a los algoritmos, sino también en los que se puedan derivar del aprendizaje automático, cuando la máquina va sola. “El problema general es cómo evitar los efectos negativos. Es muy complejo predecir consecuencias. Necesitamos una nueva generación de robots. No vale que la inteligencia artificial sirva para realizar una tarea. Necesitamos robots empáticos, que entiendan las consecuencias de sus actos y negocien cómo ejecutar la tarea. Esa es la nueva generación de robots. Si piensas en cómo trabaja la mente, cuando tomamos una decisión también imaginamos las consecuencias y eso debe ser parte de la inteligencia artificial”.

“Tenemos que ser más humanos”, añade María Amparo Alonso Betanzos, experta en informática biomédica y representante de la Asociación Española de Inteligencia Artificial (AEPIA). “No estoy hablando de la supervisión humana, que está en las directrices de la Unión Europea. Debemos tener en cuenta una visión más multinivel en la que incluyamos también consideraciones psicológicas y sociológicas porque nuestras herramientas van a ser utilizadas por las personas”.

De esta forma, la inteligencia artificial tiene que ser más humana en su esencia, en su concepción. Pero también en sus consecuencias, especialmente, cuando la tecnología empieza a ser accesible sin conocimientos informáticos.

Una de las grandes preocupaciones, que ya surgió con la primera Revolución Industrial, es el efecto en el trabajo, que ya ha dejado de ser un planteamiento teórico. La visión optimista es que la herramienta mejorará las capacidades de los trabajadores, ahorrará procesos tediosos, rutinarios o penosos e impulsará la economía. La pesimista, que las empresas aumentarán la rentabilidad a costa de destruir empleos susceptibles de mecanizar o aquellos que parecían a salvo, los que requieren habilidades creativas y razonamiento lógico. Ha sido uno de los ejes de la huelga de guionistas y actores de Hollywood.

Un estudio de OpenAI, Open Research y la Universidad de Pennsylvania calcula que los modelos de IA generativa, como ChatGPT, pueden tener algún efecto en el 80% de la fuerza laboral. En este sentido, la secretaria general del sindicato CCOO de Andalucía, Nuria López Marín, advierte en unas jornadas sobre transformación digital celebradas en la Universidad de Cádiz: “La digitalización es una revolución que nos está afectando en todos los planos de la vida, desde el social y económico hasta el laboral, porque todas las profesiones se ven afectadas. La transformación digital tiene que mejorar la vida de las personas y conllevar nuevos derechos laborales, porque hay un aumento de la productividad que supone mayores beneficios para la empresa y que, en consecuencia, debe suponer una mejora para los trabajadores y trabajadoras”. López Marín aboga por la revisión de aspectos como horarios, salarios, conciliación, formación e incluso las cotizaciones e impuestos. “Los robots no tributarán, pero sus dueños y dueñas sí”, reclama.

Y para evitar un reguero de víctimas del nuevo analfabetismo digital, Juan Ramón Astorga, ingeniero, profesor de la Universidad de Cádiz y directivo de Tecnalia, aboga por “educación y formación”, la primera para llevar la IA a todas las etapas escolares y universitarias y la segunda para asegurar la adaptación al cambio de todos los trabajadores. Astorga confía en la colaboración de entidades públicas y privadas.

Entre las primeras figuras la Fundación Estatal para la Formación en el Empleo (Fundae), que cuenta con una plataforma de contenidos en línea financiada con fondos NextGeneration. Entre las iniciativas privadas, IBM se ha comprometido a capacitar, con la herramienta SkillsBuild, a dos millones de estudiantes para finales de 2026. “Es fundamental que las siguientes generaciones conozcan lo que la IA aporta a las empresas y al conjunto de la economía, así como el cambio de paradigma que supone, con independencia de los estudios que cursen”, explica Pilar Villacorta, directora de Universidades y Educación Superior de IBM para España, Portugal, Grecia e Israel.

Los robots no tributarán, pero sus dueños y dueñas síNuria López Marín, secretaria general CC OO en Andalucía

La iniciativa responde a datos como los surgidos en el informe del Institute of Business Value de IBM, que calcula que la implementación de la IA y la automatización requerirá que el 39,4% de la mano de obra vuelva a capacitarse en los próximos tres años. Globalmente, este porcentaje equivaldría a 1.400 millones de los 3.400 millones de trabajadores del mundo, según las estadísticas del Banco Mundial.

En todo este complejo panorama de equilibrio inestable entre un sistema fundamental para el desarrollo y los riesgos, faltan dos herramientas clave: la legislativa y la policial, entendida esta última como el mecanismo de control y seguimiento que vigile que la primera se cumple. “Estamos dando pasos. Hemos creado ya la primera Agencia Española para la Supervisión de la Inteligencia Artificial [AEISA]”, recuerda María Amparo Alonso Betanzos. Con los estatutos aprobados en agosto, la entidad, con sede en A Coruña, comenzará a funcionar a final de año con un nuevo marco regulatorio previsto para las próximas semanas.

Europa, bajo la presidencia española, ultima en estas semanas esas reglas del juego en sus países: la AI Act o Reglamento de Inteligencia Artificial. Esta normativa establecerá las obligaciones para proveedores y usuarios en función de cuatro niveles de riesgo de la inteligencia artificial:

“Inaceptables”. Estas aplicaciones estarán prohibidas y se refieren a sistemas que manipulen, de clasificación social o de identificación biométrica remotos o en tiempo real.

“De alto riesgo”. Tendrán supervisión permanente y agrupa a modelos que puedan perjudicar la seguridad o los derechos fundamentales, como aquellas vinculadas al coche autónomo o al control de fronteras o al ámbito laboral.

“De inteligencia generativa”. Contarán con exigencias de transparencia y se refiere a aplicaciones como ChatGPT o Bard.

“De riesgos limitados”. Estarán obligadas a informar de forma fehaciente a los usuarios que están ante una creación de inteligencia artificial (imágenes, video o audio conocidos como deepfakes).

“La Unión Europea viene trabajando desde hace años en lo que será un reglamento, que es importante porque será de obligado cumplimiento, sin adaptación en cada país, como pasa con las directivas”, explica Cecilia Danesi, abogada especializada en IA y derechos digitales, profesora la Universidad Pontificia de Salamanca y otras universidades internacionales, divulgadora y autora de El imperio de los algoritmos (Galerna, 2023).

La inteligencia artificial tiene un poder expansivo enorme. Si un humano causa un daño, es limitado. El de un sistema de inteligencia artificial, en cuestión de segundos, es infinitoCecilia Danesi, abogada especializada en IA y derechos digitales

Danesi, integrante también del grupo Mujeres por la Ética de la Inteligencia Artificial (Women4Ethical AI) de la Unesco, explica que la propuesta inicial aprobada en junio ha pasado a una fase de negociación entre los Estados miembros de la UE. España, durante la presidencia de este semestre, promueve que las negociaciones “aseguren que no se socava la innovación y que, al mismo tiempo, se protejan los derechos fundamentales de las personas”, según un documento de trabajo de la delegación española. La ministra de Justicia en funciones, Pilar Llop, coincide: “No podemos renunciar a las nuevas tecnologías, incluida la inteligencia artificial, porque sería renunciar a nuestro propio futuro”. Llop advierte sobre los abusos y los sesgos para concluir: “Debemos evitar que sustituyan una habilidad que es patrimonio de la humanidad: diferenciar el bien del mal”.

Hasta ahora, lo que se regula son las consecuencias de los actos. En el caso de Almendralejo se aplica la norma sobre pederastia del Código Penal o el Código Civil en reclamaciones de indemnización, por ejemplo. “El reglamento de la UE regulará el desarrollo y el uso de la inteligencia artificial, es decir, no se cambia ni el Código Penal ni las normas de responsabilidad civil, que se van a aplicar cuando un sistema de inteligencia artificial ocasiona daños, sino que es una regulación general preventiva, porque establece las obligaciones que van a tener que cumplir los sujetos que provean herramientas basadas en inteligencia artificial. La idea, y eso para mí es muy interesante, es evitar que el daño se produzca”, detalla Danesi.

La experta en derecho digital añade que “la inteligencia artificial tiene un poder expansivo enorme. Si un humano causa un daño, es limitado. El de un sistema de inteligencia artificial, en cuestión de segundos, es infinito”.

Todos los sistemas incluidos en la propuesta de reglamento ya se están usando, como el reconocimiento facial o de emociones en ámbitos laborales o escolares o los sistemas policiales predictivos o los dirigidos a manipular la voluntad o influir en procesos electorales.

También están ya funcionando los contenidos creativos generados por la IA. “Hay un gran debate con lo que son los derechos de autor porque los sistemas de IA generativa se alimentan libremente de todo lo que circula en la red”, advierte Danesi.

Felipe Gómez-Pallete, presidente de Calidad y Cultura Democráticas, sostiene que “la tecnología, una vez desarrollada, no hay quien la pare”. “La podemos regular, atemperar, pero llegamos tarde”, advierte.

Danesi matiza esa afirmación. “No se puede regular lo que no existe y, cuando existe, la regulación llega tarde”. Pero añade: “La propuesta de legislación de la UE es la más avanzada del mundo para regular la inteligencia artificial de manera integral y era necesario que corriera agua bajo el puente para poder hacer una ley lo más coherente y concienzuda posible. En los procesos legislativos, siempre vamos a estar retrasados porque no se puede regular lo que no conocemos y es imposible saber qué aplicaciones, qué usos van a tener estos sistemas en el futuro. Por el tipo de tecnología, siempre vamos a estar un poco haciendo malabares. Por eso no tenemos que regular una tecnología concreta sino áreas, sectores e impactos de la aplicación”.

Puedes seguir a EL PAÍS Tecnología en Facebook y X o apuntarte aquí para recibir nuestra newsletter semanal.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.