Un experimento logra que una máquina relacione conceptos como hacen los humanos

El trabajo, publicado en ‘Nature’, abre la puerta a que herramientas de inteligencia artificial generativa, como ChatGPT, aprendan más rápido, de forma más eficiente y barata

El cerebro humano tiene una propiedad clave que hace posible el lenguaje y nos permite elaborar pensamientos sofisticados: la generalización composicional. Es la habilidad de combinar de forma novedosa elementos ya conocidos con otros que se acaban de aprender. Por ejemplo, una vez que un niño sabe saltar, entiende perfectamente qué significa saltar con las manos arriba o con los ojos cerrados. En la década de 1980 se teorizó que las redes neuronales artificiales, el motor en el que se apoyan la inteligencia artificial y el aprendizaje automático, serían incapaces de establecer esas conexiones. Un artículo publicado en la revista Nature ha demostrado que sí pueden, lo que abre potencialmente un gran campo de mejora en la disciplina.

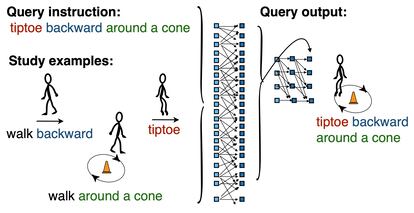

Los autores del estudio han desarrollado un innovador método de entrenamiento, que han bautizado como metaaprendizaje para composicionalidad (meta-learning for compositionality, en el original en inglés), en el que se actualiza constantemente la red neuronal y se la dirige a través de una serie de episodios para que sea capaz de relacionar experiencias. Posteriormente, realizaron experimentos con voluntarios a los que se les sometió a las mismas pruebas que a las máquinas. Los resultados muestran que la máquina fue capaz de generalizar tan bien o mejor que las personas.

“Durante 35 años, los investigadores de la ciencia cognitiva, la inteligencia artificial, la lingüística y la filosofía han debatido si las redes neuronales pueden lograr una generalización sistemática similar a la humana. Hemos probado por primera vez que sí”, afirma Brenden Lake, profesor adjunto del Centro de Ciencia de Datos y del Departamento de Psicología de la NYU y uno de los autores del trabajo.

Los grandes modelos de lenguaje, como ChatGPT, son capaces de generar textos coherentes y bien estructurados a partir de las instrucciones que se les dé. El problema es que, antes de llegar a ser capaces de hacerlo, se les tiene que entrenar con una cantidad ingente de datos. Es decir, se procesan extensísimas bases de datos y se desarrollan algoritmos de inteligencia artificial o aprendizaje automático (machine learning) que sean capaces de extraer patrones y aprendan, por ejemplo, que hay una altísima probabilidad de que a las palabras “El césped es de color” las siga la palabra “verde”.

Estos procesos de entrenamiento son lentos y muy costosos en términos energéticos. Para entrenar un modelo como ChatGPT, que tiene en cuenta más de 175.000 millones de parámetros, hace falta mucha capacidad computacional. Esto es, varios centros de datos (naves industriales llenas de ordenadores) funcionando día y noche durante semanas o meses.

“Nosotros proponemos una solución parcial a este problema que se basa en una idea de las ciencias cognitivas”, explica por teléfono Marco Baroni, investigador del ICREA y profesor del departamento de Traducción y Lenguas Sociales de la Universitat Pompeu Fabra de Barcelona y coautor del estudio. “Los humanos podemos aprender muy rápidamente porque tenemos la facultad de la generalización composicional. Es decir, que si yo nunca he oído la frase ‘saltar dos veces’, pero sí sé qué es ‘saltar’ y qué es ‘dos veces’, lo puedo entender. Eso no es capaz de hacerlo ChatGPT”, señala Baroni. La herramienta estrella de OpenAI ha tenido que aprender qué es saltar una vez, saltar dos veces, cantar una vez, cantar dos veces…

El tipo de entrenamiento propuesto por Lake y Baroni puede servir para que los grandes modelos de lenguaje aprendan a generalizar con menos datos de entrenamiento. El siguiente paso, dice Baroni, es demostrar que su experimento es escalable. Ya han probado que funciona en un contexto de laboratorio; ahora toca hacerlo con un modelo conversacional. “No tenemos acceso a ChatGPT, que es un producto propiedad de OpenAI, pero hay muchos modelos más pequeños y muy potentes desarrollados por centros académicos. Usaremos alguno de ellos”, subraya Baroni.

Una de las intenciones de los autores es, de hecho, “democratizar la inteligencia artificial”. El hecho de que los grandes modelos de lenguaje necesiten enormes cantidades de datos y de potencia de cálculo limita la cantidad de proveedores a un puñado de empresas con la infraestructura necesaria: Microsoft, Google, Amazon, Meta, etcétera. Si la propuesta de Lake y Baroni demuestra su valía entrenando este tipo de modelos, se abriría la puerta a que operadores más modestos puedan desarrollar sus propios sistemas y que estos no tengan nada que envidiar a ChatGPT o Bard.

El avance presentado por estos dos científicos puede ser de utilidad también en otras disciplinas. “Brenan y yo venimos del campo de la psicología lingüística. No creemos que las máquinas piensen como los seres humanos, pero sí que entender cómo funcionan las máquinas puede decirnos algo acerca de cómo lo hacen los humanos”, destaca Baroni. “De hecho, demostramos que cuando nuestro sistema se equivoca, el error no es tan grueso como los de ChatGPT, sino que son parecidos a los de las personas”.

Así ha sucedido, por ejemplo, con un fallo relacionado con la iconicidad, un fenómeno en lingüística presente en todas las lenguas del mundo por el que si se dice A y B, salgo de casa y voy a comer, eso quiere decir que antes salgo y luego voy a comer. “En tareas de tipo experimental, si le enseñas al sujeto humano que, cuando se dice A y B, el orden correcto es B y A, suele haber fallos. Ese tipo de error también lo hace nuestro sistema”, ilustra el investigador italiano.

¿Qué recorrido puede tener el método ideado por Lake y Baroni? Todo dependerá de qué suceda cuando se pruebe con grandes modelos de lenguaje. “No sabría decir si es una línea de investigación que vaya a ofrecer grandes avances a corto o medio plazo”, opina Teodoro Calonge, profesor Titular del departamento de Informática en la Universidad de Valladolid, quien ha revisado el código usado en los experimentos. Y añade, en declaraciones a la plataforma SMC España: “Desde luego, no creo que vaya a dar respuesta a los interrogantes que actualmente se plantean en el campo de la explicabilidad de la inteligencia artificial y, en particular, en el campo de la inteligencia artificial”.

Puedes seguir a EL PAÍS Tecnología en Facebook y X o apuntarte aquí para recibir nuestra newsletter semanal.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.