La otra cara del ‘deepfake’: un intercambio de rostros para proteger a los más vulnerables

El ‘deep learning’ permite que las personas del colectivo LGBTQI que cuentan su historia en el documental Welcome to Chechnya lo hagan mirando a cámara, sin pixelados, pero con la cara de otra persona

En Chechenia, formar parte del colectivo LGBTQI puede convertirse en una sentencia de muerte, o con algo de suerte, servir de pase a una galería de los horrores que incluye exorcismos religiosos, ingresos forzados en hospitales psiquiátricos, encarcelamientos y torturas. El propio presidente de la república, Razam Kadyrov, ha expresado públicamente su apoyo a que sean sus propios familiares quienes la ejecuten. “Si hubiera de estas personas en Chechenia, las fuerzas de seguridad no tendrían que hacer nada con ellos, porque sus familiares les enviarían a un lugar de no retorno”, ha llegado a afirmar su secretario de prensa.

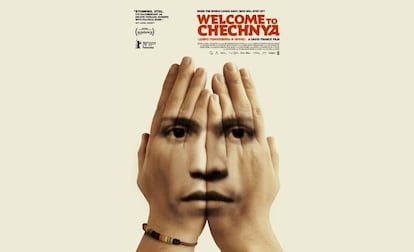

Mostrar las atrocidades que ocurren en este contexto y en este siglo, y ante la general pasividad de la comunidad internacional, era el objetivo de David France en su último documental, Welcome to Chechnya. El director, conocido por sus trabajos en The Death and Life of Martha P. Johnson y History of a Plague, quería además dar voz a las víctimas sin aumentar su ya extrema vulnerabilidad. Los encargados de protegerles han sido uno de los desarrollos tecnológicos más demonizados del momento: los deepfakes.

France no quería grabar a los supervivientes en medio de la oscuridad o con caras pixeladas. Creía que esto podría restarles humanidad. “Lo que les propuse, y fueron suficientemente valientes para aceptar, fue que me dejaran grabarles sin restricciones, con la promesa de que después encontraría alguna manera de ocultarles”, explica en el dosier del documental. El encargado de hacer realidad este compromiso fue Ryan Lanney, fundador de la compañía de efectos especiales 300Ninjas.

Para proteger la identidad de los entrevistados en el documental, se desarrollaron deepfakes que reemplazaban sus rostros por los de activistas LGBTQ de Estados Unidos. El trabajo de Lanney redefine el discurso siniestro y alarmante que por ahora domina todo lo relacionado con los deepfakes, a los que propone rebautizar como tecnologías de reemplazo facial. “Los deepfakes son inherentemente no consentidos. La persona que se introduce en el vídeo no tiene ni idea de lo ocurrido. En contraste, la gente que forma parte del documental tenía una estrecha relación con la compañía de producción”.

Un escudo computacional

Como en cualquier proyecto de deep learning, la recopilación de datos fue fundamental. El punto de partida para 300Ninjas era las imágenes originales, ya cortadas y editadas. “Revisamos la película toma a toma, tomando en cuenta la iluminación, la luz exterior y la interior”, precisa. Después, se rodaron las imágenes de los 24 activistas que donarían sus caras para proteger las de los supervivientes. “Les sentamos en diferentes escenarios que cuadraban con la iluminación y los ángulos del filme”.

El resultado son las mismas declaraciones, expresando las mismas emociones desde otros rostros. “Tuvimos mucho cuidado de hacer que no fuera perfecto”, matiza el experto. Esto se concreta en un leve difuminado en los bordes a cada una de las caras camufladas. “Lo hicimos por dos motivos. Es nuestra manera de decir ‘no estamos tratando de engañarte’ y de que se entienda el peligro en que se encuentra esta gente”.

La misma magnitud de esos riesgos exigía garantizar que en ningún caso estas imágenes permitieran identificar a los verdaderos narradores. En este contexto, los deepfakes se convierten en una máscara excepcionalmente opaca, puesto que en las imágenes finales no queda ni rastro de los píxeles originales. “No hay un filtro que puedas deshacer”. Con las voces tampoco hay nada que hacer, puesto que fueron reinterpretadas por actores de doblaje. “Nos gustaría tener también tecnología para esto en el futuro”, comenta Lanney.

Cuando ponemos a alguien en penumbra para ocultar su identidad, o detrás de una pared o solo enfocamos sus manos, perdemos muchísima información Ryan Lanney, 300Ninjas

El documental,que se ha estrenado ya en HBO en Estados Unidos, pasó antes por Sundance y la Berlinale. Obtuvo buenas críticas en ambos festivales – y despertó con su uso de los deepfakes el interés de otros documentalistas. “Este sistema permite contar una historia mucho más humana”, explica Lanney. “Cuando ponemos a alguien en penumbra para ocultar su identidad, o detrás de una pared o solo enfocamos sus manos, perdemos muchísima información. Además, pienso que es una representación más honesta que recurrir a un actor”. El otro punto fuerte es la solidez con que el deepfake enmascara al hablante. “Una persona que está en peligro puede mostrarse más dispuesta a dar su testimonio si está segura de que su identidad está a salvo”.

El experto ha dedicado hasta ahora su carrera a trabajar en el desarrollo de efectos especiales para ficción -taquillazos incluidos-, pero tras su experiencia ideando las tecnologías necesarias para Welcome to Chechnya aspira a mantenerse en esta vertiente “más cívica”. No duda que seguirán usándose para fines negativos, pero también está seguro de que seguirán siendo una herramienta narrativa más en la industria de los efectos especiales. “Queremos tener un diálogo honesto con la audiencia y con las personas implicadas, por eso pienso que el término fake no captura lo que hacemos”. Por lo que respecta al futuro y al potencial de las nuevas técnicas, la opinión de Lanney es que todo es posible. “Hace cosa de diez años, un estudiante enseñó a volar un pájaro hecho con gráficos computerizados. Creó la estructura ósea y las funciones aerodinámicas de las alas y le dijo que aprendiera a volar. Es difícil imaginar qué no seríamos capaces de hacer solo con que alguien pase tiempo entrenando a una máquina”.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.