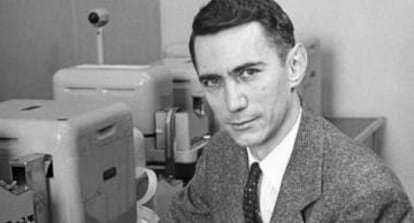

Claude Shannon: el padre de la Teoría de la Información

Hoy se cumplen cien años del nacimiento de este matemático estadounidense que desarrolló teorías que sentaron las bases de la informatica y los medios de comunicación

Google parece decidido a seguir homenajeando a aquellos hombres y mujeres que cambiaron el rumbo de la ciencia y, por ende, nuestro mundo con sus descrubrimientos. Si hace dos días era Hertha Marks Ayrton, inventora del arco eléctrico, la que protagonizaba uno de sus doodles, ahora le toca el turno a Claude Shannon, un matemático estadounidenses que nacía hace cien años un día como hoy. Sus teorías sobre la información se desarrollaron en el ámbito académico, pero sin ellas es probable que hoy no existiera el teléfono o los ordenadores. Puede que tampoco internet. Por lo que su trascendencia es incuestionable y le debemos mucho. Todo.

“¡Naturalmente! ¡Usted y yo somos máquinas y vaya si pensamos!”. Esto es lo que le contestó a una periodista cuando le preguntó si las máquinas podían pensar. Shannon tuvo una clara vocación hacia las cosas mecánicas desde pequeño, tanto que su héroe era Edison, que, casualidades de la vida, resultó ser su pariente. Esto le llevó a ingresar en 1932 en la Universidad de su Michígan natal, donde se graduó como ingeniero eléctrico y matemático, dos de sus pasiones.

Su ingreso en el departamento de ingenieria eléctrica del Instituto Tecnológico de Massachusetts (MIT) le permitió seguir investigando y su tesis fue clave a la hora de diseñar los circuitos digitales de los futuros ordenadores, tal y como reconoció un cuarto de siglo después H. H. Goldstine en su libro Las computadoras desde Pascal hasta Von Neumann.

Una teoría matemática de la comunicación, publicada en 1948, fue su trabajo más importante durante los quince años que pasó en los laboratorios Bell de Nueva York. En él demostró que tanto las fuentes de información como los canales de comunicación pueden medirse, y que de esta medida depende su capacidad y velocidad de transferencia. También sentó las bases para la supresión de ruido y la redundancia.

Pero ahí no termina el legado de este visionario que ha dado nombre a un premio que desde 1972 reconoce las contribuciones realizadas en la teoría de la información. En 1950 coqueteó con la inteligencia artifical publicando un artículo donde describe cómo una computadora puede jugar al ajedrez de una forma razonable. Sentó la base de los ordenadores tal y como los conocemos hoy.

El hombre que afirmó que las máquinas podían pensar dejó de hacerlo el 24 de febrero de 2001 por culpa del alzhéimer.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.