IBM anuncia el comienzo de la “era de la utilidad cuántica” y anticipa un superordenador en 2033

La compañía asegura haber alcanzado un sistema de computación que no se puede simular con procedimientos clásicos

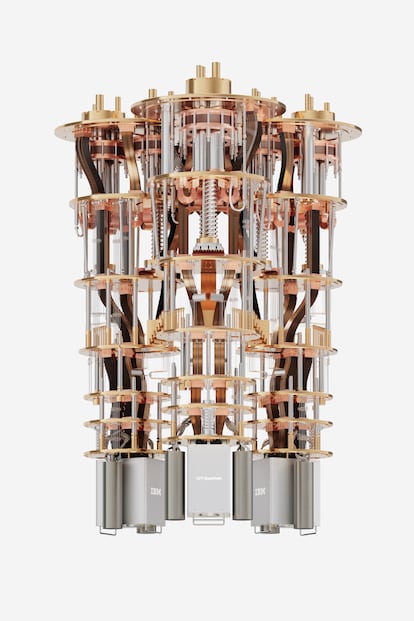

La computación cuántica no es solo cuestión de cúbits, la unidad básica de información. La clave para esta tecnología es la conjunción de sistemas que permitan construir un ordenador útil y tolerante a los fallos. La multinacional IBM ha anunciado este lunes un paso fundamental en este sentido al presentar tres avances: un procesador de 1.121 cúbits denominado Cóndor (el mayor conocido); Heron, un chip de 133 cúbits desarrollado para su interconexión y basado en una arquitectura conocida como “tunable coupler”; y un nuevo System Two, un sistema modular y flexible para combinaciones múltiples de estos procesadores con enlaces de comunicación cuántica y clásica. Estos avances, unidos a las nuevas fórmulas de mitigación y corrección de errores, anticipan lo que Darío Gil, vicepresidente de IBM y director de la división de investigación (IBM Research), califica como “la nueva era de utilidad cuántica”, que podría desembocar, según sus previsiones, en un superordenador básicamente cuántico, pero con sistemas clásicos y con corrección modular de errores en 2033.

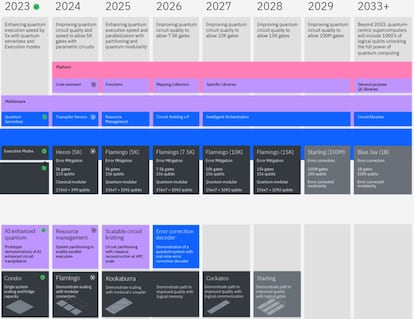

Los últimos desarrollos de IBM han hecho saltar por los aires la propia hoja de ruta de la multinacional, que ha cumplido hasta ahora con precisión matemática, para llegar más lejos y antes de lo previsto al “desbloqueo de todo el poder de la computación cuántica”, según la nueva senda tecnológica presentada este lunes.

Superar los errores, en palabras de Jian-Wei Pan, físico de la Universidad de Ciencia y Tecnología de China, “es uno de los grandes desafíos para el ser humano”. Los fallos se generan por cualquier interacción con el medio ambiente (ruido, ondas o temperatura, por ejemplo) y provocan que la superposición de estados (la propiedad física que permite a una partícula estar en una posición A y B al mismo tiempo) se degrade hasta hacerla inútil. Esa superposición es lo que permite una capacidad exponencial de la computación cuántica frente a la binaria clásica, que se limita al 0 o 1 del bit. De esta forma, si dos bits pueden almacenar un número, dos cúbits almacenan cuatro y diez cúbits pueden tener 1.024 estados simultáneos.

Para llegar a esa meta de sistemas útiles y tolerantes, IBM cree haber dado con las puertas que lo pueden permitir y que se fundamentan en avances de los procesadores, en los sistemas de interconexión de estos para permitir una computación robusta y en la mitigación y corrección de errores.

El aumento de capacidad singular lo ha conseguido IBM otra vez. “El Cóndor vuela”, bromea Gil ante el hito del nuevo procesador cuántico que sucede al Osprey, presentado el pasado año con 433 cúbits, capaz de representar un número de estados superior a la cantidad de átomos en el universo observable. Pero casi triplicar la capacidad del procesador no es lo único alcanzado. “Muchas cosas han pasado este año simultáneamente”, explica Gil.

El principal logro es que IBM considera que ya no es imprescindible continuar aumentado la capacidad de un procesador único, sino que se puede alcanzar la computación cuántica práctica con otro método. “Vamos a hacerlo a través de modularidad, con muchos chips conectados unos con otros de tal manera que podamos crear el superordenador”, asegura Gil.

Estos chips, que serían como las piezas de un juego de construcción, son ahora los IBM Quantum Heron de 133 cúbits, creados a partir de una nueva arquitectura denominada tunable coupler. Esta ingeniería permite plataformas de información cuántica de mayor tamaño y funcionalidad. “Heron puede combinarse modularmente e incorporar la comunicación clásica para acelerar los flujos de trabajo. Con el tunable coupler podemos ajustar la frecuencia de los cúbits y conseguir un procesador mucho mejor que el anterior”, explica Gil. Esta arquitectura se complementa con los 4K cryo-CMOS, controladores de estado de cúbits semiautónomos, de baja potencia y “del tamaño de una uña”.

“Heron es nuestro mejor procesador cuántico en cuanto a rendimiento hasta la fecha. Supone una mejora de hasta cinco veces con respecto al dispositivo insignia: el Eagle”, añade Matthias Steffen, jefe de arquitectura cuántica de la compañía y de tecnologías de procesadores.

La base de la interconexión de los chips Heron es la nueva generación del System Two, el sistema diseñado para combinar de forma modular y flexible múltiples procesadores en un solo sistema con enlaces de comunicación. Esta red es el componente básico de la supercomputación cuántica, ya que permite escalar el potencial computacional sin tener que progresar indefinidamente en la capacidad singular de un solo procesador.

“El System Two permitirá nuevas generaciones de procesadores centrados en tecnología cuántica, con una infraestructura central totalmente escalable y modular que permitirá ejecutar circuitos como nunca”, asegura Steffen.

El nuevo modelo ha llevado a repensar los próximos desarrollos. Gil afirma que “todas las generaciones siguientes van a estar basados en él”. “Estamos convencidos de que no necesitamos aumentar más el número de cúbits por unidad de procesador. El futuro va a ser cientos y miles de procesadores, cada uno más pequeño de 1.000 cúbits, conectados entre sí”, asegura.

El elemento clave que abrió las puertas de esta nueva senda fue la investigación publicada en Nature y que demostró que un procesador de IBM de solo 127 cúbits es capaz de medir valores esperados en operaciones de física más allá de las capacidades de los mejores métodos computacionales clásicos actuales. “Nos permite entrar en la era que hemos denominado de la utilidad cuántica, en la que ya se pueden hacer cálculos de una manera mucho más eficiente y robusta de lo que se puede hacer con cualquier tipo de simulador o con cualquier tipo de computación clásica”, asegura Gil.

Katie Pizzolato, responsable de algoritmos cuánticos y socios científicos de la compañía, cree que se trata de un momento disruptivo: “Fue la primera vez que una computadora cuántica produjo valores precisos a una escala que estaba fuera del alcance de la computación clásica de fuerza bruta y la respuesta desde entonces ha sido exactamente lo que esperábamos; desde este artículo hemos visto a muchas personas publicando investigaciones que usan la cuántica como una herramienta”.

Ya no se trata solo del Qiskit, un entorno de sistemas clásicos y cuánticos que permite llevar a la programación las soluciones frente al ruido y facilitar a los usuarios que incorporen la computación más avanzada. “Ahora hemos roto la barrera de los más de 100 cúbits con suficiente calidad”, resalta el directivo español en referencia a la investigación de Nature. Y anuncia: “Combinados con la mitigación de errores, van a permitir una explosión científica”.

Jay Gambetta, vicepresidente de IBM Quantum, destaca que ese desarrollo de programas se verá favorecido por la inteligencia artificial: “Todo el poder de la computación cuántica será impulsado por la IA generativa, que simplificará la experiencia del desarrollador”.

“Hay muchos problemas que afrontar y la naturaleza sabe cómo, pero no nos lo dice”, resume Stefan Woerner, director de Ciencia Computacional Cuántica en la sede de IBM en Zúrich (Suiza). El científico afirma que el objetivo final es llegar a una computación cuántica fundamentada en tres criterios: que sea más eficiente, barata y precisa. El modelo demostrado en Nature, según afirma, ha sido “crucial” para avanzar en esta senda.

“Será muy extraño que cualquier plataforma importante en la nube no tenga computación cuántica en 2030. Esta va a ser más impactante que la inteligencia artificial y los actuales supercomputadores”, cree Christian Weedbrook, director de Xanadu Quantum Technologies. “La computación cuántica cambiará las relaciones entre la gente, la tecnología y el trabajo”, añade Soney Trent, fundador y presidente de la también empresa tecnológica Bulls Run Group.

Las investigaciones cuánticas continúan y todas contribuyen al desarrollo de esta tecnología. Investigadores del Laboratorio Nacional Argonne del Departamento de Energía de los Estados Unidos (DOE), la Universidad de Chicago y la Universidad de Cambridge ha creado a partir del diamante cúbits más controlables y que pueden operar con equipos y gastos significativamente reducidos, según han publicado en Physical Review X. “Nuestra técnica permite elevar drásticamente la temperatura de funcionamiento de estos sistemas y reduce mucho los recursos para operarlos”, afirma Alex High, profesor asistente de la Escuela de Ingeniería Molecular Pritzker de la Universidad de California, cuyo laboratorio dirigió el estudio.

Puedes seguir a EL PAÍS Tecnología en Facebook y X o apuntarte aquí para recibir nuestra newsletter semanal.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.