El aprendizaje automático puede aprender a evitar prejuicios

Una reciente investigación explora cómo evitar que las máquinas presenten comportamientos indeseables esquivando sesgos de raza o género sin afectar a la calidad de sus resultados

La inteligencia artificial (IA) está dejando de ser un concepto difuso y académico para instalarse en nuestro día a día con naturalidad. Aunque no entendamos a la perfección su funcionamiento, como nos sucede con tantas otras tecnologías cotidianas, cada vez está más presente en nuestras vidas: tenemos IA en el móvil, en el coche y en el correo electrónico. Su éxito comercial es posible porque nos ayuda a tomar todo tipo de decisiones, desde el ámbito financiero al de la salud pasando por la educación.

El principal problema que presenta es que, como nosotros, la máquina tiene ciertos prejuicios. Uno de los casos más conocidos fue el de COMPAS, un algoritmo que se utiliza en EE UU para predecir la probabilidad de reincidencia de cada criminal. Una investigación de ProPublica desveló que, para este sistema, los acusados negros tenían más probabilidades de volver a delinquir que los blancos.

Un grupo de investigadores de las universidades de Massachusetts Amherst y Stanford ha publicado un artículo en la revista Science en el que abordan una nueva técnica para minimizar, si no evitar por completo, sesgos en algoritmos de aprendizaje automático.

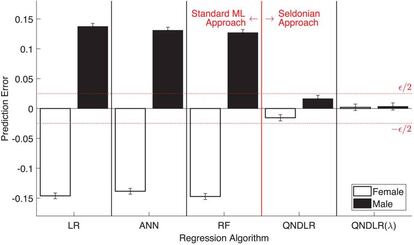

Su solución articula un sistema en el que los desarrolladores son capaces de definir una serie de condiciones de funcionamiento que impiden que los sistemas de IA crucen ciertos umbrales durante su entrenamiento y optimización para evitar que perjudiquen o discriminen a las personas. Los investigadores han bautizado estos algoritmos como seldonianos en referencia a uno de los personajes que articulan la serie de libros Fundación, de Isaac Asimov, en la que se definen las leyes de la robótica.

La investigación parte de la base de que, si es posible definir matemáticamente los resultados que podríamos considerar injustos, se pueden crear algoritmos que aprendan de los datos para evitar o reducir al mínimo estos comportamientos sin que esto perjudique al resultado. Para ello, trabajaron en un conjunto de técnicas para que los usuarios puedan especificar qué tipo de comportamiento quieren restringir —prejuicios raciales, de género, de edad...— al emplear un sistema de aprendizaje automático y que este pueda ser confiable cuando se aplique en entornos reales.

De acuerdo con el estudio, cuando los algoritmos exhiben un comportamiento indeseable o prejuicio que le lleva a alterar los resultados negativamente —”puede causar pérdidas financieras o retrasar diagnósticos médicos”, detallan—, es al usuario del sistema de IA, que no siempre tiene conocimientos de informática, a quien corresponde evitarlo. Mediante este sistema de filtrado de sesgos, la responsabilidad deja de estar en la persona que utiliza el algoritmo para situarse en el nivel anterior: en los desarrolladores de los algoritmos.

Para poner a prueba sus tesis, entrenaron a un algoritmo con instrucciones matemáticas para que predijera la nota media de un grupo de estudiantes universitarios. El sistema identificó una manera de predecirlas con un sesgo de género menos sistemático que los métodos existentes, que no contaban con filtros para evitar estos prejuicios o eran demasiado limitados.

También realizaron una prueba en medicina, para la que diseñaron un algoritmos que equilibrara una bomba de insulina autónoma, un aparato que decide qué dosis dar a un paciente diabético a la hora de la comida. Si la dosis es muy reducida, los niveles de azúcar en sangre del paciente pueden aumentar y puede derivar en enfermedades cardiovasculares. Si es demasiado alta, el azúcar en sangre puede bloquearse, con un resultado potencialmente mortal. Mediante un simulador de glucosa en la sangre, los investigadores entrenaron las bombas para fijar la dosis adecuada evitando complicaciones por exceso o defecto teniendo en cuenta patrones que otros métodos conocidos no llegaron a valorar.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.