Los rostros creados por inteligencia artificial generan más confianza que los reales

Una investigación muestra las dificultades para distinguir caras ‘fabricadas’ de las de personas

La inteligencia artificial (IA) permite ya crear imágenes de personas muy verosímiles y que estas cambien con cada actualización, gracias a webs como This person does not exit. Pero esto no acaba en humanos, también se puede generar fotografías de animales, como gatos, e incluso habitaciones de alquiler. La similitud entre las fotografías y la realidad es abrumadora. Una investigación publicada en PNAS muestra las dificultades para distinguir rostros reales de los creados a través de un algoritmo de inteligencia artificial llamado redes adversarias generativas (GAN, por sus siglas en inglés). Otra de las conclusiones que refleja es que las caras ficticias generan una mayor confianza que las reales. Aunque la diferencia no es demasiada, apenas un 7,7% más, los rostros con menor puntuación de confiabilidad eran reales y tres de los cuatro con mayor puntuación eran ficticios. Sophie Nightingale, profesora de Psicología en la Universidad de Lancaster y coautora del estudio, defiende que estos últimos resultados eran contrarios a sus expectativas: “Nos sorprendió bastante”.

La investigación consta de tres experimentos. En los dos primeros la muestra debía distinguir entre caras reales y creadas por las GAN. En la el primer experimento, el grupo, formado por 315 participantes, tuvo una precisión promedio de 48,2%, por debajo del rendimiento al azar. En la segunda parte, los 219 nuevos participantes fueron instruidos de manera básica sobre rostros sintéticos y tras cada respuesta les informaban de si habían acertado o no. El porcentaje de respuestas correctas fue un poco superior al experimento anterior y alcanzó el 59%. En ambos casos los rostros que tuvieron más dificultad para clasificar fueron los de personas blancas. Nightingale cree que, aunque estas diferencias desaparecerán con el paso del tiempo, se debe a que estos algoritmos están más entrenados con este tipo de rostro.

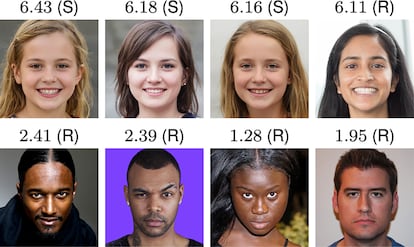

En la tercera parte quisieron ir más allá y calibrar el nivel de confianza que les generaban las caras y comprobar si las sintéticas activaban los mismos juicios de confiabilidad. Para ello, 223 personas tenían que puntuar del 1 (muy poco confiable) al 7 (muy confiable) los rostros. Para los reales, la calificación media fue de 4,48 frente a 4,82 de los rostros sintéticos. Aunque la diferencia es de un 7,7%, los autores destacan que es “significativa”. De los 4 rostros más fiables, tres eran sintéticos, mientras que los cuatro que generaban menos confianza eran reales.

Todos los rostros analizados pertenecían a una muestra de 800 imágenes, la mitad reales y la otra falsas. La mitad sintética fue creada a partir de GAN. La muestra estaba compuesta por igual entre hombres y mujeres y de cuatro razas diferentes: afroamericanos, caucásicos, asiáticos orientales y asiáticos del sur. Para las caras reales recopilaron un rostro coincidente en cuanto a la edad, género, raza y apariencia general. Cada persona analizaba o puntuaba 128 caras.

José Miguel Fernández Dols, catedrático de Psicología Social en la Universidad Autónoma de Madrid y cuya investigación se centra en expresión facial, destaca sobre el último experimento que no todos los rostros tienen la misma expresión ni postura y que eso puede “afectar a los juicios”. En el estudio se tiene en cuenta laexpresión facial y se asume que es más probable que una cara sonriente se califique como generadora de mayor confianza. Sin embargo, el 65,5% de las caras reales y el 58,8% de las sintéticas sonreían, por lo que la expresión facial por si sola “no puede explicar por qué las sintéticas se califican como más confiables”.

El investigador también considera fundamental la postura de tres de las imágenes de personas menos confiables. Los ojos adelantados con respecto a la boca, protegiendo el cuello, es una postura “previa a la agresión, según algunos autores”. “Los rostros sintéticos son cada vez más realistas y pueden generar fácilmente más confianza jugando con varios factores: la tipicidad de la cara, los rasgos y la postura”, comenta Fernández Dols. Una investigación publicada en 2015 en Sage Journals apoya uno de estos aspectos y asegura que los juicios de confiabilidad alcanzan su punto máximo alrededor del rostro típico.

Las consecuencias de los contenidos sintéticos

Además de la creación de rostros sintéticos, Nightingale predice que otro tipo de contenidos creados, como vídeos o audios, están “en camino” de ser indistinguibles del contenido real. “Lo más importante es que la democratización de las tecnologías de medios sintéticos significa que cualquiera pueda crear contenidos sintéticos sin conocimientos especializados”. Y esto podría traer consecuencias: “Esto crea una amenaza significativamente mayor para usos nefastos que las tecnologías especializadas anteriores”. En el estudio se alerta de algunos posibles problemas como imágenes íntimas no consensuada, fraudes o campañas de desinformación

Sergio Escalera, catedrático de la Universidad de Barcelona y miembro del Centro de Visión por Computador, resalta el aspecto positivo de las creaciones de rostros: “Desde un punto de vista de oportunidades es interesante ver cómo se puede generar caras que, además, pueden transmitir una emoción amigable”. El investigador plantea esta posibilidad para asistentes virtuales o para cuando se necesita transmitir una expresión concreta, como tranquilidad, a personas que padecen una enfermedad mental, por ejemplo. Para Escalera, lo fundamental es exponer, desde un punto de vista ético, las posibilidades que tiene la inteligencia artificial y, sobre todo, “ser muy conscientes en el momento de transferirlas a la sociedad de los posibles riesgos que pueda haber”. Además, defiende que la legislación actual está “un poco retrasada” en comparación con el avance tecnológico y que, aunque a nivel europeo se esté protegido por el GDPR (Reglamento General de Protección de Datos), fuera no, y aún hay “mucho que hacer”.

Puedes seguir a MATERIA en Facebook, Twitter e Instagram, o apuntarte aquí para recibir nuestra newsletter semanal.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.