B4kunAs del k0b1d: así se camufla la desinformación sobre la pandemia en las principales redes sociales

Una investigación centrada en publicaciones en español desvela cómo palabras ligeramente modificadas engañan a los sistemas de moderación de Facebook, Instagram, Twitter y Youtube

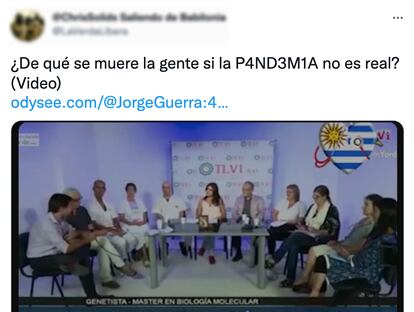

“No es v4kuna, es un experimento de horror en humanos. Es una guerra despierten”, proclama un usuario de Facebook junto a la publicación de un vídeo que lleva acumuladas al menos 13.700 reproducciones. La captura de pantalla, tomada por los investigadores la organización sin ánimo de lucro europea de EU DisinfoLab el pasado mes de octubre, ni siquiera lleva la información complementaria que la red social suele añadir a las publicaciones que tratan sobre la pandemia. La clave de su supervivencia es el camuflaje de la palabra vacuna, que al cambiar la a por un 4 y la c por una k, logra evadir al sistema de verificación de contenidos con el que Facebook trata de combatir la desinformación.

Esta breve publicación es solo una muestra de cómo quienes se dedican a distribuir bulos en las redes sociales sortean los ya insuficientes controles implementados por las propias plataformas. EU DisinfoLab también ha hallado ejemplos de estas prácticas en publicaciones en español de Instagram, Twitter y Youtube. “Monitoreamos a diario el panorama desinformativo mundial, incluyendo por supuesto el español. Eso nos pone sobre la pista de muchas cosas”, explica Ana Romero-Vicente, autora del estudio. “Cuando se hizo este estudio [en octubre], los casos de palabras camufladas no verificadas eran numerosos, no era algo aislado”. De hecho, todos los casos que identificaron siguen colgados en sus respectivas redes sociales.

La técnica que emplean es sencilla: basta cambiar algunos caracteres para que la palabra siga siendo reconocible para un lector humano pero se convierta en un galimatías a ojos de las máquinas. Y no es tan novedosa, en el mundo del cibercrimen es común encontrar estos trucos en las direcciones de páginas web que intentan suplantar a entidades reales. “Las palabras camufladas también se usan para difundir otras narrativas”, señala el estudio, que cita como ejemplo un vídeo pro-Qanon que denuncia una operación contra la p3d0fi1i4 –pedofilia– 4dr3n0cr0m0 –adrenocromo–, dos elementos centrales en las teorías de la conspiración que alienta este colectivo.

En líneas generales, la moderación de contenidos se apoya en las denuncias de usuarios o bien en los barridos hechos por sistemas de inteligencia artificial que identifican contenidos potencialmente problemáticos. En el siguiente paso se encuentran equipos de moderadores humanos que tendrían que dirimir los casos donde entran en juego más matices de los que puede detectar una máquina.

Según explica Mukund Srinath, investigador especializado en procesamiento del lenguaje natural y extracción de información, la detección automatizada de este tipo de términos puede basarse en medidas de proximidad: “Con estas técnicas, se pueden extraer palabras similares. Por ejemplo, la palabra cobid tiene una distancia de edición de 1 de la palabra covid”. Otra opción es recurrir a modelos de inteligencia artificial entrenados con ejemplos como los que ha encontrado EU DisinfoLab para reconocer publicaciones con frases similares. “Esto desde luego es menos complicado cuando uno tiene los recursos de Facebook y Twitter, porque facilita recopilar grandes cantidades de datos en el contexto correcto”, razona Srinath.

Glosario camuflado

Aunque los investigadores se han centrado en los términos vacuna, covid y pandemia, han encontrado también referencias camufladas a otras palabras clave vinculadas al mismo tema, como virus, grafeno, mascarillas o lvermectina. En estos casos el maquillaje también se empleaba para escapar de los sistemas de moderación y difundir desinformación.

En todos los textos se encontraron cinco estrategias recurrentes: la sustitución de vocales por números (p4nd3m14 en lugar de pandemia), el uso de consonantes alternativas que en español suenan igual o de forma muy similar (cobit en lugar de covid), el cambio en el orden de las sílabas (nacuva en lugar de vacuna), la inserción de signos de puntuación entre las letras (v.a.c.u.n.a.), o la utilización de palabras con significados próximos (bicho 19 en lugar de covid-19). Es una táctica simple pero efectiva: cuando los contenidos no pueden ser detectados, tampoco pueden ser retirados ni etiquetados.

En las redes más centradas en la imagen y el sonido, como Youtube e Instagram estas técnicas aparecen adaptadas al formato de los contenidos: como textos insertados en fotos o vídeos en los que se silencia una palabra pronunciada por el hablante pero se introduce por escrito como si fuera un subtítulo.

¿Qué historias cuentan estas palabras camufladas? De acuerdo con los investigadores, las narrativas principales se centran en difundir proclamas antivacunas, mensajes sobre conspiraciones y contenidos negacionistas. El lado bueno de esta tendencia es que los posts que emplean estas tácticas no son, por ahora, excesivamente virales. “La detección temprana que hacemos con este estudio pretende frenar la expansión de este método desinformador apelando a las plataformas de redes sociales a que mejoren su sistema de verificación de contenido. Con este estudio se demuestra, una vez más, que las políticas de moderación de contenido de las redes sociales tradicionales deben evolucionar constantemente para adaptarse a las nuevas amenazas”, explica Romero-Vicente.

La existencia de estas tácticas no solo demuestra que quienes se dedican a difundir información siguen buscando vías para extender sus mensajes en las plataformas más usadas. “Además de escapar de la moderación, el uso del camuflaje de palabras refuerza la identidad de grupo, la idea de ser parte de una comunidad que comparte el mismo código secreto y se enfrenta al poder de las grandes empresas tecnológicas”.

Para controlar el problema los investigadores de EU DisinfoLab, prescriben el uso de mejores sistemas de reconocimiento óptico de caracteres que afinen la identificación de textos inapropiados insertados en fotos y vídeos, así como mejorar las técnicas de detección teniendo en cuenta las dificultades actuales. “Las plataformas no son transparentes en absoluto sobre las herramientas que utilizan para conducir la moderación de contenido y desconocemos qué tan eficientes son. La próxima regulación de la UE tendrá que obligar a las plataformas a ser transparentes sobre por qué actúan, pero también sobre por qué no actúan sobre la desinformación”.

Puedes seguir a EL PAÍS TECNOLOGÍA en Facebook y Twitter o apuntarte aquí para recibir nuestra newsletter semanal.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.