El discurso del odio es fácil de encontrar en las redes sociales

Si las redes quieren evitar seguir siendo o convertirse en vectores de guerra informativa y plagas de ideas y memes de odio, tienen que ser mucho más activas

Poco después del tiroteo perpetrado en una sinagoga de Pittsburgh, observé que la palabra “judíos” era tema de tendencia en Twitter. Como investigadora de las redes sociales y educadora, me preocupaba que la violencia se extendiese por Internet, al igual que sucedió en el pasado.

La actividad del supuesto atacante en la red social Gab ha llamado la atención sobre la función que esa red tiene como alternativa llena de odio a opciones más convencionales como Facebook o Twitter. Estas últimas se encuentran entre las plataformas de redes sociales que han prometido luchar contra el discurso del odio y los insultos en sus páginas.

Sin embargo, cuando exploré la actividad en Internet tras el tiroteo, enseguida me quedó claro que los problemas no están solo en sitios como Gab. Por el contrario, el discurso del odio sigue siendo fácil de encontrar en las redes sociales convencionales, incluida Twitter. También he determinado qué medidas adicionales podría tomar la empresa.

Respuestas incompletas a nuevos términos de odio

Yo esperaba que apareciesen en Internet nuevas amenazas relacionadas con el tiroteo de Pittsburgh, y había señales que indicaban que ya estaba ocurriendo. En un reciente ataque antisemita, el líder de Nación del Islam, Louis Farrakhan, empleaba la palabra “termitas” para describir a los judíos. Busqué este término, sabiendo que era probable que los racistas lo utilizasen como palabra clave para evitar ser detectados al expresar el antisemitismo.

Twitter no había suspendido la cuenta de Farrakhan tras otra de sus declaraciones antisemitas, y la función de búsqueda de la red sugirió automáticamente que tal vez yo buscase la expresión “termite eats bullets” [la termita come balas]. Eso convierte la caja de búsqueda de Twitter en un cartel del discurso de odio.

Sin embargo, la empresa había ajustado al parecer algunos de sus algoritmos internos, porque en mis resultados de búsqueda no apareció ningún tuit con usos antisemitas de la palabra “termita”.

Mensajes que han pasado desapercibidos durante años

Al continuar mis búsquedas de discursos de odio y llamamiento a la violencia contra los judíos, encontré pruebas aún más inquietantes de los defectos del sistema de Twitter para moderar contenidos. Tras las elecciones presidenciales de 2016 en Estados Unidos y el descubrimiento de que Twitter se había utilizado para influir en ellas, la empresa afirmó que estaba invirtiendo en aprendizaje de máquinas para “detectar y mitigar el efecto de la actividad de cuentas falsas, coordinadas y automáticas sobre los usuarios”. Basándome en mis resultados, esos sistemas no han detectado siquiera amenazas violentas y discursos de odio claros y directos que llevan años en este sitio.

Cuando informé de que un tuit subido en 2014 proponía matar a judíos “por diversión”, Twitter lo retiró ese mismo día, pero su aviso automático general no daba ninguna explicación de por qué había permanecido intacto durante más de cuatro años.

El odio engaña al sistema

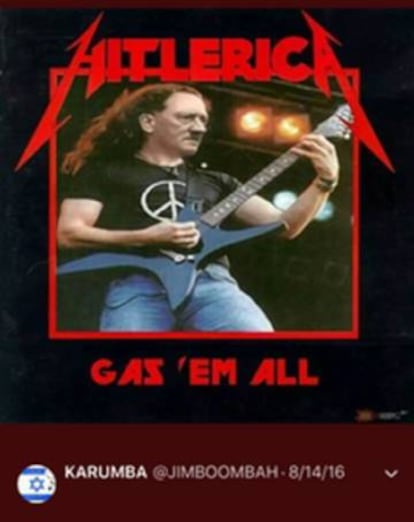

Cuando revisé tuits de odio que no habían sido detectados en años, comprobé que muchos no tenían texto y contenían solo una imagen. Sin texto, los tuits son más difíciles de detectar tanto para los usuarios como para los propios algoritmos utilizados por Twitter para detectar el odio. Pero los usuarios que buscan específicamente discurso de odio en Twitter pueden muy bien desplazarse por la actividad de las cuentas que encuentran, viendo aún más mensajes de odio.

Twitter parece ser consciente de este problema: a los usuarios que informan sobre un tuit se les anima a revisar otros tuits de la misma cuenta y a someter más contenido a revisión, pero sigue dejando margen para que algunos no sean detectados.

Ayuda para gigantes tecnológicos en apuros

A medida que iba encontrando tuits que en mi opinión incumplían las políticas de Twitter, fui informando sobre ellos. La mayoría los eliminaron con rapidez, incluso en menos de una hora. Pero algunos mensajes ofensivos tardaron hasta varios días en desaparecer. Sigue habiendo unos cuantos mensajes de texto que todavía no se han eliminado, a pesar de incumplir claramente las políticas de Twitter. Eso demuestra que el proceso de revisión de contenido de la empresa no es consecuente.

Puede parecer que Twitter está mejorando en la eliminación de contenido perjudicial y que está retirando mucho contenido y memes, y suspendiendo cuentas, pero mucha de esa actividad no está relacionada con el discurso de odio. Buena parte de la atención de Twitter se ha centrado más bien en lo que la empresa denomina “manipulación coordinada”, como bots y redes de perfiles falsos dirigidos por secciones de propaganda gubernamentales.

En mi opinión, la empresa podría dar un paso significativo y solicitar la ayuda de la ciudadanía, así como de investigadores y expertos como mis colaboradores y yo, para detectar el contenido de odio. Es normal que las empresas tecnológicas –Twitter incluida– ofrezcan una remuneración a quienes detecten vulnerabilidades en su soporte informático. Sin embargo, todo lo que la empresa ofrece a los usuarios que informan sobre contenido problemático es enviarles un mensaje generado automáticamente dándoles las “gracias”. La disparidad entre el modo en que Twitter trata los problemas de codificación y las denuncias de contenido transmite el mensaje de que da prioridad a la tecnología sobre la comunidad.

En vez de eso, Twitter podría pagar a los usuarios que informen sobre contenido que incumple sus directrices comunitarias, ofreciendo recompensas económicas por señalar las vulnerabilidades sociales de su sistema, como si esos usuarios le estuviesen ayudando a determinar problemas de software o de hardware. Un ejecutivo de Facebook expresó la preocupación de que esta posible solución fallase y generase más odio en la red, pero yo creo que el programa de recompensas podría estructurarse y diseñarse de modo que evitase ese problema.

Queda mucho por hacer

Hay otros problemas de Twitter que van más allá de lo que se publica directamente en su sitio. Los que cuelgan discurso de odio a menudo aprovechan otra herramienta clave de Twitter: la capacidad de incluir enlaces a otro contenido de Internet. Esa función es clave en el uso de Twitter, y sirve para compartir contenido de intereses mutuos en la red. Pero es también una forma de difundir el discurso de odio.

Por ejemplo, un tuit de apariencia totalmente inocente, que diga “Esto tiene gracia” e incluya un enlace. Pero el enlace –a contenido no incluido en los servidores de Twitter– presenta un mensaje lleno de odio.

Además, el sistema de moderación de contenido de Twitter solo permite a los usuarios denunciar tuits de odio y amenazadores, pero no cuentas que contengan mensajes similares en su propio perfil. Algunas de estas cuentas –con fotos de Adolf Hitler, y nombres y direcciones de Twitter que animan a quemar judíos– ni siquiera cuelgan tuits o siguen a otros usuarios. A veces solo existen para que los usuarios los encuentren cuando busquen palabras en sus perfiles, convirtiendo de nuevo la caja de búsqueda en un sistema de difusión. Y aunque es imposible saberlo, es posible que estas cuentas se utilicen también para comunicarse con otros en Twitter mediante mensaje directo, usando la plataforma como un canal de comunicación encubierto.

Sin tuits ni otra actividad pública, es imposible que los usuarios denuncien estas cuentas a través del sistema habitual de denuncia de contenido. Pero son igual de ofensivos y peligrosos, y es necesario evaluarlos y moderarlos en igual medida que cualquier otro contenido del sitio. A medida que los que desean difundir el odio se vuelven más expertos, las directrices comunitarias de Twitter –y lo que es más importante, sus esfuerzos para aplicarlas– deben actualizarse y estar al tanto.

Si las redes sociales quieren evitar seguir siendo o convertirse en vectores de guerra informativa y plagas de ideas y memes de odio, tienen que ser mucho más activas y, como mínimo, tener miles de empleados de moderación de contenido a tiempo completo, como hizo una profesora en el transcurso de un fin de semana.

Jennifer Grygiel es profesora Adjunta de Comunicaciones, Universidad de Syracuse

Cláusula de Divulgación. Jennifer Grygiel posee una pequeña cartera de acciones en las siguientes empresas de redes sociales: FB, GOOG, TWTR, BABA, LNKD, YY, and SNAP.

Este artículo fue publicado originalmente en The Conversation. Lea el original.

![]()

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.