Oxford te enseña cómo hacer que el algoritmo del banco te dé el crédito

El investigador sobre inteligencia artificial Brendt Mittelstadt, junto con sus compañeros Sandra Wachter y Chris Rusell, emplea los 'hechos objetivos' para desvelar el proceso de toma de decisiones de esta herramienta digital

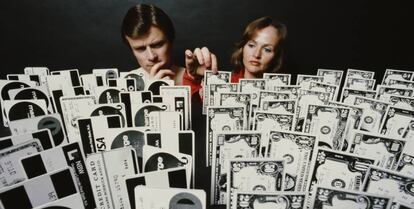

A los algoritmos les rodea cierto misticismo. Campan a sus anchas por todas partes, pero nadie los ha visto nunca. Poco más que se han convertido en meigas. Lo mismo se encargan de determinar qué vemos en nuestro muro de Facebook que de aprobar un préstamo hipotecario. Hasta en Estados Unidos dictan sentencias judiciales. Eso sí, que nadie se moleste en comprender a la inteligencia artificial porque, en la mayoría de casos, es opaca. Le gusta moverse por la oscuridad. Esto es precisamente lo que el investigador Brendt Mittelstadt, junto con sus compañeros del Oxford Internet Institute Sandra Wachter y Chris Rusell, pretende revertir. Arrojar luz sobre cuál es su proceso de toma de decisiones.

La algoritmia basada en machine learning construye modelos muy complejos basados en infinidad de datos. Hasta sus propios creadores tendrían difícil explicar su funcionamiento. Aquí es donde surge lo que Mittelstadt denomina counterfactual explanations -aunque en castellano no existe una traducción literal, nos valdremos de la idea de hechos objetivos-. Como explica, la idea de este modelo es averiguar por qué la tecnología ha llegado a una conclusión que ni tú mismo esperabas. “No se trata de detallar por completo cómo funciona un algoritmo, sino de establecer un camino alternativo para llegar al objetivo que pretendías”, argumenta.

Con un pequeño ejemplo, todo se entiende más fácilmente. El investigador de Oxford opta por las diferencias existentes a la hora de pedir un préstamo. “Si tus ingresos son de 30.000 euros, te rechazan la petición. Ahora bien, si fueran de 45.000, el algoritmo que usa el banco no te habría puesto problema alguno. Esto es lo que la inteligencia artificial no te cuenta”, sostiene. Pero los hechos objetivos no se detienen aquí. Ahora toca aportar detalles de lo que puedes corregir para lograr este dinero. Lo mismo se trata de que trabajes en otros sitios, conduzcas un coche diferente o cambies tu lugar de residencia. “Nuestro método establece cuáles son los cambios más pequeños posibles que necesitas para modificar el resultado final”, zanja.

Por si alguien anda tentado de pensar que los hechos objetivos solo se han quedado entre las paredes universitarias, Mittelstadt sale al quite con una aseguradora de drones en Reino Unido que ya ha apostado por ellos. Cuando introduces los parámetros, la empresa ofrece detalles de lo que puedes modificar para beneficiarte de unas tarifas u otras. Evidentemente, todo está estipulado por la mano negra del algoritmo. “No cuesta lo mismo volar una cantidad de kilómetros que otra. Lo justo es que la propia compañía te especifique cómo puede variar la cotización de tu seguro según la cantidad que determines”, añade.

El choque con la propiedad intelectual

Las grandes tecnológicas, aunque también vale para cualquier organización, guardan gran celo en mantener a los algoritmos a salvo. Como si de una caja negra se tratara. Indestructible ante los imprevistos. La razón principal es la propiedad intelectual que los salvaguarda. Por esta razón, tal y como asegura Mittelstadt, su intención no exponer sus secretos ni dar acceso a los usuarios para que recorran sus entrañas. Nadie va a comerciar con una tecnología amparada por los derechos de autor. “Otra cosa es la vulneración de nuestro derecho fundamental a la privacidad. Sí que deberíamos controlar las ideas que infieren los algoritmos a partir de los datos que producimos”, alerta.

El investigador de Oxford lleva casi una década dedicada al estudio de la inteligencia artificial. Su inquietud por luchar contra la discriminación y las malas prácticas le condujo hasta los hechos objetivos. “No puede ser que haya anuncios personalizados según nuestra orientación sexual cuando no la hemos compartido con ninguna plataforma”, expone. Al igual que su metodología ayuda a corregir estas deficiencias, también pone el acento en la ética que debe acompañar al machine learning. “Dependemos de la buena voluntad de quienes desarrollan los algoritmos. Por mucho que una empresa diga que son justos, la realidad es que hay personas marginadas y discriminadas”, lamenta.

La solución que propone nada tiene que ver con una legislación genérica -“aunque ayudaría”, matiza-. Mittelstadt defiende atender al contexto en el que la matemática se apodera de decisiones tan trascendentales para nuestro día a día. “No podemos perder el matiz de en qué situación operan si queremos lidiar con los sesgos y la equidad. Es imposible determinar lo que es justo sin mirar a nuestro alrededor”, concluye. Los hechos objetivos aportan algunas herramientas para corregir la tiranía de las meigas del siglo XXI. Las disonancias entre los despachos matemáticos de las grandes tecnológicas y lo que sucede sobre el terreno han conseguido acortarlas. Lo de menos es comprender su funcionamiento, sino que mejoren realmente para lo que fueron programados.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.