¿Para qué necesita un portal de empleo conocer nuestro sexo?

La experiencia de una usuaria que recibió mejores ofertas al cambiarse el género de su perfil vuelve a alertar sobre el peligro de sesgos discriminatorios en la inteligencia artificial

Todo empezó como una broma que ha terminado cuestionando otra vez la neutralidad de los algoritmos que seleccionan nuestros perfiles para lanzarnos ofertas. E. G., que prefiere no ser identificada, es doctora e investigadora. Pero esta primavera acaba su beca y se ha inscrito en portales de empleo. Cansada de recibir “propuestas en femenino” de secretaria y administrativa, probó a cambiar el género de su currículum. A los pocos días, empezó a recibir ofertas de trabajos de mayor responsabilidad y mejor pagados. La plataforma niega que el género se tenga en cuenta y atribuye el caso a un cambio en los comportamientos de búsqueda, pero los expertos en análisis de datos advierten de que la discriminación se da, no por la plataforma sino porque las máquinas aprenden de la realidad. E. G. plantea una pregunta clave: si no tienen en cuenta el género, ¿por qué es el primer dato que piden en la inscripción?

Caroline Ragot, directora de Producto de Infojobs, la plataforma donde se registró el caso de E. G., asegura que el género y la edad son “datos estadísticos comunes en los recursos humanos y que solo se utilizan con carácter interno”. “No se usa como variable”, afirma tajante.

La directiva asegura que es la primera vez que registran un caso así entre 2,5 millones de candidaturas y lo atribuye a una modificación en el patrón de búsqueda de la candidata tras cambiar de género (“El algoritmo devuelve palabras claves introducidas en el buscador”, defiende), a una mayor oferta disponible los días de la alteración del currículum, a un error, al uso de un perfil para buscar empleo para un amigo con criterios diferentes, a la incorporación de puestos de trabajo muy demandados o a lo que denominan “filtros colaborativos”, que permiten enviar propuestas que otros candidatos con perfiles similares hayan consultado y que hayan pasado inadvertidas para el usuario.

Ragot insiste en que Infojobs promueve las vacantes inclusivas y la igualdad así como las ofertas sin discriminación de género, por lo que remiten a las empresas recomendaciones de buenas prácticas que incluyen la descripción del puesto ofertado sin género o con terminaciones en masculino y femenino.

Este periódico ha mantenido durante una semana dos perfiles iguales de un hombre y una mujer. A lo largo de ese plazo, las ofertas recibidas han sido las mismas y solo han variado levemente al modificar el patrón de búsqueda de uno y otro perfil.

Gemma Galdón, doctora en políticas públicas especializada en vigilancia, impacto social, legal y ético de la tecnología, advierte de que la clave es que el sesgo está en la realidad, no en la plataforma. “El algoritmo aprende lo que ve, pero no corregirlo lo empeora”, advierte para defender la necesidad de eliminar el género y cualquier dato que pueda terminar en una discriminación.

Esta socia, fundadora y directora de investigación de Eticas Research & Consulting recuerda el caso de Tay, un robot creado por Microsoft para conocer más sobre la interacción entre las computadoras y los seres humanos a través de Twitter. Tuvo que ser anulado a los pocos días al reproducir mensajes racistas y machistas. “Tay aprendió lo peor, lo más ofensivo”, reconoció Diana Kelly, jefa de cibersegurdad de Microsoft en el reciente encuentro de Cybertech celebrado en Israel. “Si no aprendemos inclusión, seguiremos creando exclusión”, afirmó para defender que la diversidad es “más efectiva y productiva”

“Hay que disponer de fórmulas de corrección de los algoritmos indeseables porque estos recogen mecanismos de la sociedad”, recomienda Galdón, quien recuerda que, a través de ingeniería inversa, se puede “acompañar” a la máquina para evitar efectos indeseados como el que detectó su equipo en un portal de salud que terminó recomendando a las mujeres que se pinten las uñas.

Una investigación de la Universidad Carnegie Mellon descubrió que las mujeres tenían menos posibilidades de recibir anuncios de trabajos bien pagados en Google porque los programas que se usan en los departamentos de contratación de algunas empresas se inclinaban por nombres usados por hombres.

Amazon tuvo que cancelar su sistema de Inteligencia Artificial de selección de personal al detectar graves sesgos que perjudicaban la contratación de mujeres, según un informe de Business Insider.

Y también puede haber discriminación racial, como ha comprobado el equipo de Galdón al analizar un programa de asignación de vivienda pública que buscaba una distribución más eficiente y terminó creando guetos.

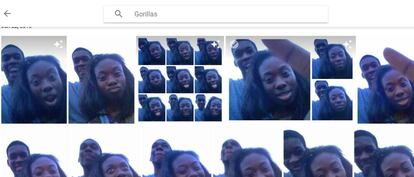

El sesgo incluido por falta de formación de los programadores o por la falta de seguimiento se puede ver agravado por la incorporación de herramientas de reconocimiento facial, como le sucedió a Jacky Alcine, un joven de Brooklyn que descubrió que Google Photos había clasificado como “gorilas” una imagen suya con una amiga. La empresa rectificó tras la denuncia.

“Las empresas rectifican cuando se encuentran ante una crisis de reputación, pero no se pueden escudar en la neutralidad del cálculo matemático”, concluye Galdón.

180 prejuicios definidos y clasificados

"Los sistemas de inteligencia artificial son tan buenos como la información que pongamos en ellos. Los datos malos pueden contener prejuicios implícitos raciales, de género o idológicos. Muchos de esos sistemas de inteligencia artificial seguirán aprendiendo a utilizar los malos datos, haciendo que crezca el problema, Pero creemos que puede corregirse y los sistemas que lo hagan serán los que prosperen", afirma IBM en su página de investigación.

Eliminar los prejuicios y la discriminación, según esta compañía, es "crucial para humanos y máquinas" por lo que defiende la necesidad de desarrollar sistemas confiables y "enseñarlos" con información imparcial.IBM calcula que existen más de 180 prejuicios definidos y clasificados que afectan a los procesos de toma de decisiones, que se incorporan a los sistemas de inteligencia artificial y que hacen desconfiar de ellos.

La investigadora de IBM Francesca Rossi, en una presentación de la compañía, defiende que no toda la información parcial es mala (se puede usar para destacar fuentes confiables y relevantes) y que la perjudicial podría ser eliminada en un plazo de cinco años por aquellas compañías que sean más sensibles con la importancia de la diversidad y los efectos de la incorporación de prejuicios a los sistemas.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.