El habla humana ya no es solo de los humanos

Google DeepMind crea sofisticadas voces de personas inexistentes usando inteligencia artificial

En breve, oiremos voces salir de nuestro teléfono y no seremos capaces de distinguir si se trata de una persona, grabada o en directo, o de una máquina. Sentiremos que respira, coge aire, entona en función del mensaje, modula la voz para enfatizar y todo tipo de dejes e imperfecciones habituales en el habla humana. Mientras a algunos esta idea les produce escalofríos, algunos de los mejores expertos en inteligencia artificial trabajan en pulir unas voces que ya son lo más humano que se ha escuchado nunca... surgido por entero de un ordenador.

WaveNet permitirá asistentes en los móviles mucho más personales, pero ya se ha demostrado capaz hasta de componer pequeñas piezas de piano

"Los primeros modelos los probamos sin texto. Cuando tuvimos el primer audio supimos que el modelo era bueno: parece que sea inglés pero no era inglés ni nada. Pero oías hablar a alguien que respira y eso me sorprendió muchísimo", recuerda Oriol Vinyals, uno de estos especialistas de Google DeepMind que ha desarrollado este programa para crear voces humanas de la nada. Luego le dieron textos a la máquina para que dijera cosas inteligibles y el resultado fue convincente. WaveNet, como se denomina el proyecto, permitirá asistentes en los móviles mucho más personales, pero ya se ha demostrado capaz hasta de componer pequeñas piezas de piano.

El modelo aprovecha las capacidades de la inteligencia artificial basada en redes neuronales que están desarrollando en DeepMind, la filial londinense de Alphabet (Google) que está liderando las conquistas más vistosas en este campo. Del mismo modo que esas redes neuronales veían las jugadas ganadoras en el Go, ganando al campeón en este complejo tablero oriental, ahora son capaces de dibujar ondas de audio que parezcan voces humanas.

La máquina se alimenta de voces reales y aprende a dibujar una onda de audio de voz humana a partir de los ejemplos

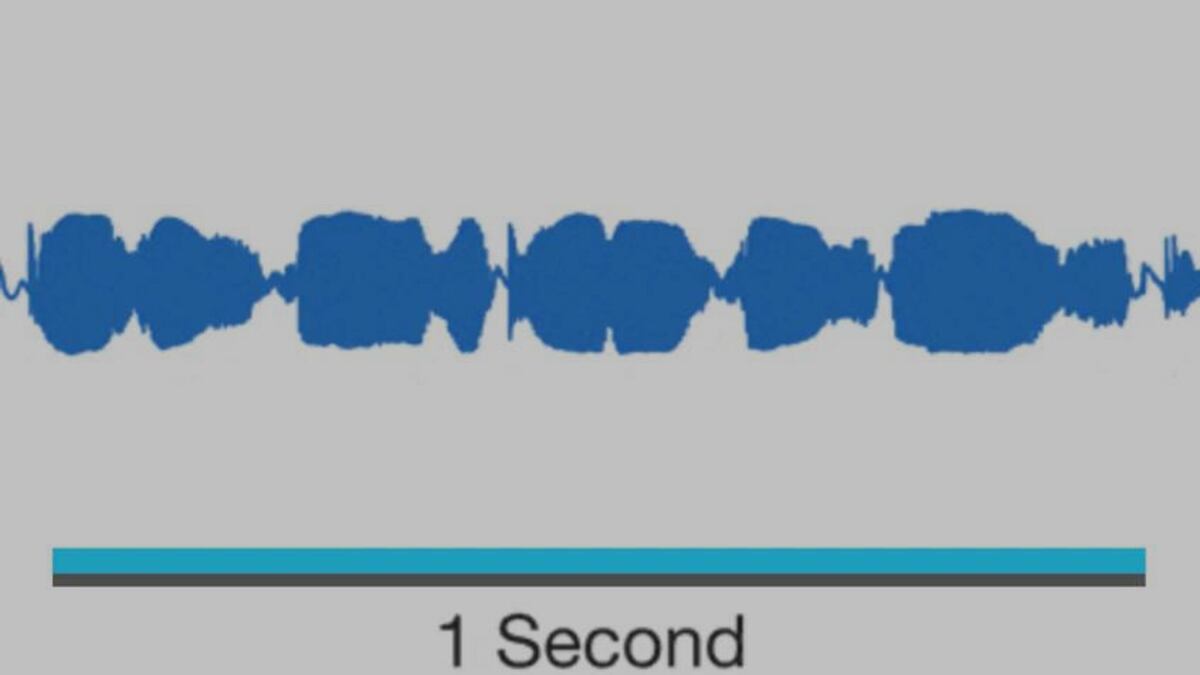

Para conseguirlo, primero alimentan a la máquina con horas y horas de audios y, a partir de ahí, WaveNet aprende a generar simulaciones de voces emulando la frecuencia de los sonidos, la fluidez de los fonemas y el ritmo de conversación de las personas. En una onda de audio, desmenuzada al detalle, se encuentran todos los matices de una voz real: temblor, entonación, silencios irregulares, ruidos de respiración, etc. Son puntos en una línea, 16.000 puntos en un segundo de voz. "Con unas cuantas horas de voz, WaveNet tiene muchos puntos de entrenamiento", afirma Vinyals.

En otros sistemas de voz artificial se recurre a fragmentos de discurso troceados que se encadenan para formar palabras y frases: fonemas enganchados uno tras otro como los vagones de un tren de juguete. De ahí que no sirvan para entonar o enfatizar en condiciones. Sin embargo, lo que hace WaveNet es simular la onda que crearía un humano al hablar, después de aprender cómo se encadenan todos los puntos de una onda de audio. "Va eligiendo dónde se coloca el siguiente punto de la onda, 16.000 veces por segundo, a lo largo de la señal temporal de muy alta frecuencia, lo cual es bastante difícil, un hito en el campo de la generación de voz", asegura Vinyals, formado en la Universidad Politècnica de Catalunya y único español de la lista del MIT de 35 innovadores de menos de 35 años.

Un compositor artificial

Pensando en el futuro, Vinyals reconoce que WaveNet necesita mejorar en la rapidez de generar voz. Y añade: "Lo que está muy claro es que Google va a impulsar su asistente virtual, eso es obvio". Pero lo más fascinante de su trabajo, reconoce, es la capacidad de crear música. Del mismo modo que aprende cómo diría un humano una frase, WaveNet puede aprender cómo suena una pieza de piano y simular una por su cuenta (escucha los ejemplos).

"Lo más bonito desde el punto de vista de investigación pura sería trabajar en el campo de la creación de música, que aprendan de escuchar a Chopin o a Mozart y decirle: 'Dame otra sinfonía que no sea ninguna de las que existen pero que sea de su estilo", asegura. "Para la voz está mucho más claro, el modelo tiene muchas más pistas de cómo se genera un habla que parezca humana. Para generar una canción de tres minutos que tenga coherencia, que sea agradable, que transmita sentimientos... es una posibilidad mucho más lejana", reconoce.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.

Sobre la firma