Ni EE UU suelta cocodrilos para frenar la migración ni el Louvre se ha incendiado: cómo detectar si una imagen ha sido generada con IA

Las herramientas para detectar si un contenido está creado con inteligencia artificial son útiles, pero no infalibles

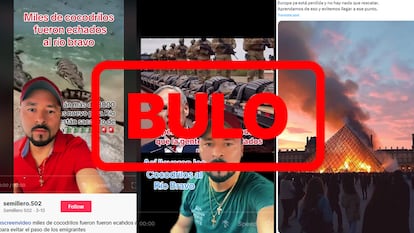

Ni Estados Unidos ha soltado “8.000 cocodrilos en el Río Bravo” para evitar el cruce de migrantes ni se ha incendiado la pirámide del Museo del Louvre. Tampoco han encontrado este pulpo gigante en la orilla de una playa, a Big Foot ni al monstruo del Lago Ness. Todas estas desinformaciones surgen de imágenes generadas con inteligencia artificial. Mientras que compañías tecnológicas como Google, Meta y OpenAI tratan de detectar contenidos creados por IA y crear marcas de agua resistentes a manipulaciones, los usuarios se enfrentan a un difícil reto: el de discernir si las imágenes que circulan en redes sociales son reales o no. Si bien algunas veces es posible hacerlo a simple vista, existen herramientas que pueden ser de ayuda en casos más complejos.

Generar imágenes con inteligencia artificial es cada vez más sencillo. “Hoy en día cualquiera, sin ninguna habilidad técnica, puede escribir una oración en una plataforma como DALL-E, Firefly, Midjourney u otro modelo basado en mensajes y crear una pieza de contenido digital hiperrealista”, afirma Jeffrey McGregor, CEO de Truepic, una de las compañías fundadoras de la Coalición para la Procedencia y Autenticidad del Contenido (C2PA), que busca crear un estándar que permita verificar la autenticidad y la procedencia del contenido digital. Algunos servicios son gratuitos y otros ni siquiera requieren una cuenta.

“La IA puede crear imágenes increíblemente realistas de personas o eventos que nunca sucedieron”, afirma Neal Krawetz, fundador de Hacker Factor Solutions y FotoForensics, una herramienta para verificar si una imagen puede haber sido manipulada. En 2023 se viralizó, por ejemplo, una imagen del papa Francisco con un abrigo de plumas de Balenciaga y otras del expresidente de Estados Unidos, Donald Trump, huyendo de la policía para no ser arrestado. Krawetz destaca que este tipo de imágenes pueden usarse para influir en las opiniones, dañar la reputación de alguien, crear desinformaciones y proporcionar un contexto falso en torno a situaciones reales. De esta forma, “pueden erosionar la confianza en fuentes que de otro modo serían fiables”.

Las herramientas de IA también se pueden utilizar para representar falsamente a personas en posiciones sexualmente comprometedoras, cometiendo delitos o acompañadas de delincuentes, como señala V.S. Subrahmanian, profesor de informática en la Universidad Northwestern. El año pasado decenas de menores de Extremadura denunciaron que circulaban fotos de falsos desnudos suyos creadas por IA. “Estas imágenes se pueden usar para extorsionar, chantajear y destruir la vida de líderes y ciudadanos comunes”, cuenta Subrahmanian.

Y no sólo eso. Las imágenes generadas por IA pueden representar una grave amenaza para la seguridad nacional: “Pueden utilizarse para dividir a la población de un país enfrentando a un grupo étnico, religioso o racial contra otro, lo que podría conducir a largo plazo a disturbios y agitaciones políticas”. Josep Albors, director de investigación y concienciación de la compañía de seguridad informática ESET en España, explica que muchos bulos se basan en este tipo de imágenes para generar controversia y suscitar reacciones. “En un año electoral en muchos países, esto puede decantar la balanza hacia uno u otro lado”, afirma.

Trucos para detectar imágenes generadas con IA

Expertos como Albors aconsejan sospechar de todo en el mundo online. “Tenemos que aprender a convivir con que esto existe, con que la IA genera realidades paralelas, y simplemente tener eso en la cabeza cuando recibimos un contenido o vemos algo en redes sociales”, afirma Tamoa Calzadilla, editora jefa de Factchequeado, una iniciativa de Maldita.es y Chequeado para combatir la desinformación en español en Estados Unidos. Saber que una imagen puede haber sido generada por IA “es un gran paso para no ser engañados y compartir desinformación”.

Algunas imágenes de este tipo son fáciles de detectar con sólo fijarse en detalles de las manos, los ojos o los rostros, como cuenta Jonnathan Pulla, fact-checker de Factchequeado. Es el caso de una imagen creada con IA del presidente Joe Biden vistiendo un uniforme militar: “Uno se puede dar cuenta por los tonos de piel diferentes en su rostro, los cables de teléfono que no van a ningún lado y la frente de un tamaño desproporcionado de uno de los soldados que aparecen en la imagen”.

También pone como ejemplo unas imágenes manipuladas del actor Tom Hanks posando con camisetas con mensajes a favor o en contra de la reelección de Donald Trump. “Que [Hanks] tenga la misma pose y solo cambie el texto de la camiseta, que su piel sea muy lisa y su nariz irregular indican que pueden haber sido creadas con herramientas digitales, como inteligencia artificial”, explican los verificadores de Maldita.es sobre estas imágenes, que se viralizaron a principios de 2024.

Muchas imágenes generadas por IA pueden ser identificadas a simple vista por un usuario entrenado, especialmente aquellas generadas por herramientas gratuitas, según Albors: “Si nos fijamos en los colores, muchas veces notaremos que estos no son naturales, que todo tiene aspecto como de plastilina y que, incluso, algunos componentes de estas imágenes se funden entre ellos, como el pelo en la cara o varias prendas entre sí”. Si la imagen es de una persona, el experto sugiere fijarse además en si hay algo anómalo en sus extremidades.

Si bien los generadores de imágenes de primera generación cometían “errores simples”, con el tiempo han mejorado notablemente. Así lo indica Subrahmanian, que destaca que antes representaban con frecuencia a personas con seis dedos y sombras antinaturales. También plasmaban incorrectamente los letreros de calles y tiendas, cometiendo “errores ortográficos absurdos”. “Hoy en día, la tecnología ha superado en gran medida estas deficiencias”, asegura.

Herramientas para identificar imágenes falsas

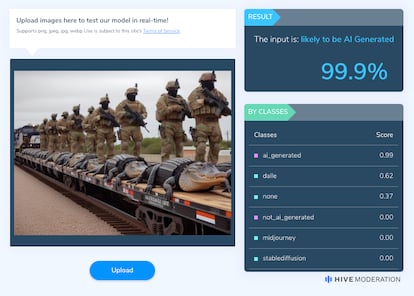

El problema es que ahora “una imagen generada por IA ya es prácticamente indistinguible de una real para muchas personas”, como señala Albors. Existen herramientas que pueden ayudar a identificar este tipo de imágenes como AI or NOT, Sensity, FotoForensics o Hive Moderation. OpenAI también está creando su propia herramienta para detectar contenido creado por su generador de imágenes, DALL-E, según anunció el pasado 7 de mayo en un comunicado. En el ámbito de los deepfakes sonoros, el programa VerificAudio ayuda a identificar voces sintéticas.

Este tipo de herramientas, según Pulla, resultan útiles como complemento a la observación, “ya que a veces no son muy precisas o no detectan algunas imágenes generadas por IA”. Los verificadores de Factchequeado suelen recurrir a Hive Moderation y FotoForensics. Ambas pueden usarse de forma gratuita y funcionan de forma similar: el usuario sube una foto y solicita que se examine. Mientras que Hive Moderation ofrece un porcentaje de cómo de probable es que el contenido haya sido generado por IA, los resultados de FotoForensics son más difíciles de interpretar para alguien sin conocimientos previos.

Al subir la imagen de los cocodrilos que supuestamente han sido enviados por EE UU al Río Bravo para evitar el cruce de migrantes, del Papa con el abrigo de Balenciaga o una de un happy meal de McDonald’s satánico, Hive Moderation da un 99,9% de probabilidades de que ambas hayan sido generadas por IA. Sin embargo, con la foto manipulada de Kate Middleton, la princesa de Gales, indica que la probabilidad es del 0%. En este caso, a Pulla le resultaron útiles Fotoforensics e Invid, que “pueden mostrar ciertos detalles alterados en una imagen que no son visibles”.

Pero, ¿por qué resulta tan difícil saber si una imagen ha sido generada con inteligencia artificial? La principal limitación de dichas herramientas, según Subrahmanian, es que carecen de contexto y conocimientos previos. “Los humanos utilizan su sentido común todo el tiempo para separar las afirmaciones reales de las falsas, pero los algoritmos de aprendizaje automático para la detección de imágenes deepfake han avanzado poco en este sentido”, afirma. El experto considera que cada vez será más improbable saber con un 100% de certeza si una foto es real o generada por IA.

Incluso si una herramienta de detección fuera precisa el 99% de las veces al determinar si el contenido fue generado por IA o no, “esa brecha del 1% a escala de internet es enorme”. Sólo en un año la IA generó 15.000 millones de imágenes. Así lo indica un informe de Everypixel Journal, que destaca que “la IA ya ha creado tantas imágenes como las que han tomado los fotógrafos en 150 años”. “Cuando todo lo que se necesita es una imagen convincentemente fabricada para degradar la confianza, 150 millones de imágenes no detectadas es una cifra bastante inquietante”, afirma McGregor.

Aparte de los píxeles manipulados, McGregor subraya que también es casi imposible identificar si los metadatos de una imagen —la hora, la fecha y la ubicación— son precisos después de su creación. El experto considera que “la procedencia del contenido digital, que utiliza criptografía para marcar imágenes, será la mejor manera para que los usuarios identifiquen en el futuro qué imágenes son originales y no han sido modificadas”. Su compañía, Truepic, dice haber lanzado el primer deepfake transparente del mundo con estas marcas —con información sobre su origen—.

Hasta que estos sistemas estén ampliamente implementados, es fundamental que los usuarios adopten una postura crítica. En una guía elaborada por Factchequeado, con apoyo del Instituto de Periodismo Reynolds, figuran 17 herramientas para combatir la desinformación. Entre ellas, hay varias para verificar fotos y videos. La clave, según Calzadilla, está en ser consciente de que ninguna de ellas es infalible y 100% fiable. Por ello, para detectar si una imagen ha sido generada con IA, no vale una única herramienta: “La verificación se realiza mediante varias técnicas: la observación, el uso de herramientas y las clásicas del periodismo. Es decir, contactar con la fuente original, revisar sus redes sociales y verificar si la información que se le atribuye es cierta”.

Puedes seguir a EL PAÍS Tecnología en Facebook y X o apuntarte aquí para recibir nuestra newsletter semanal.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.