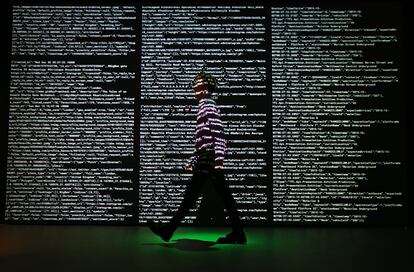

¿Podemos fiarnos de las máquinas inteligentes? La respuesta está en la ética

Los expertos en filosofía y la reciente declaración de la UNESCO en inteligencia artificial establecen límites para el buen uso de la tecnología

No solo hacen tareas mecánicas. Los robots que conocemos hoy han aprendido a pensar. Es fácil toparse con máquinas inteligentes que toman decisiones en el cine. Solo en Una odisea en el espacio o en Black Mirror tenemos varios ejemplos; algunos, no muy halagüeños. Tampoco hace falta acudir a la ficción para conocer creaciones inteligentes. Ahí están la popular robot humanoide Sophia ―que no solo conversa, sino que se ha consagrado como artista―, los sistemas de reconocimiento facial y los coches autónomos. Pero que haya máquinas que hagan tareas en lugar de personas está ligado al escepticismo. ¿Y si nos quitan el trabajo? ¿Y si se vuelven contra nosotros? ¿Y si nos discriminan? La cuestión es que detrás de la toma de decisiones de una máquina hay una inteligencia artificial (IA) o una programación que ha sido creada por humanos. Así que, llegados a este punto, ¿podemos fiarnos de las máquinas? La respuesta está en la ética.

La revolución tecnológica es imparable. Será aún mayor con el 5G y la computación cuántica, pero lo es ya, en gran parte, por la inteligencia artificial. Aunque hace décadas que existe, hoy se compone de algoritmos matemáticos muy sofisticados que recogen datos del entorno, los interpreta y toma decisiones de forma automática. Como ocurre, por ejemplo, cuando Google Maps ofrece un camino alternativo cuando detecta un atasco.

Francesca Rossi, una de las mayores investigadoras mundiales en ética e inteligencia artificial y la mayor representante de la materia en IBM, parte de una premisa: “El objetivo de la inteligencia artificial es aumentar la inteligencia humana, no sustituirla”. Pero para que esta inteligencia —y en consecuencia, la decisión que una máquina toma— sea lo más honesta posible es importante que la ética esté presente. “Se puede construir la tecnología de forma que sea digna de confianza, de manera que quien la utilice o se vea afectado por la decisión de sus sistemas, pueda confiar en lo que la IA le proporciona”, apunta la experta.

Ocurre, sin embargo, que uno de los principales problemas de la IA es que las máquinas podrían aprender o interpretar los datos de forma sesgada. Rossi lo explica. “Imagina que una máquina que usa IA es responsable de conceder créditos bancarios. Si los datos de los que dispone dicen que la totalidad de solicitudes concedidas fueron a hombres y las rechazadas fueron a mujeres, la máquina podría extrapolar que no debe conceder préstamos a ellas”. Se trata de una generalización, pero basta el ejemplo para comprender que es preciso evitar posibles discriminaciones por género, ideología, raza u otra variable. “Hay que comprobar que las conclusiones de las máquinas no tengan sesgos. Y si los hay, habrá que eliminarlos”, aclara.

Rossi, que lleva más de dos décadas como investigadora y siete años liderando el desarrollo de un marco ético para la tecnología de IBM, habla por videollamada desde Nueva York para aclarar que, para poder confiar en las máquinas es necesario que todas las partes del ecosistema, incluido los trabajadores, sean responsables o éticos. Y eso pasa por la transparencia en la toma y manejo de los datos y de sus procesos, pero también por la regulación. Por eso, cada vez existen más empresas tecnológicas que, como IBM, incorporan comités éticos en sus plantillas y ofrecen formación a sus trabajadores para que la tecnología en la que trabajan sea lo más fiable ―transparente― posible.

Se trata, al fin y al cabo, de salvaguardar nuestros derechos. Una realidad que los expertos en tecnología, los filósofos e investigadores como Rossi llevan años debatiendo en congresos internacionales. Y en todos se ha llegado a una conclusión: se necesita establecer un marco legislativo consensuado que marque, de forma ética, los límites sobre cómo debe conformarse la inteligencia artificial de las máquinas que afectan nuestro día a día.

No es tarea fácil. Y sin embargo, la UNESCO aprobó en noviembre de 2021 la declaración universal de la inteligencia artificial. Un hito aceptado por sus 193 estados miembros. La medida propone un marco para controlar ciertas tecnologías controvertidas, como los sistemas de recomendación de las aplicaciones o los sistemas de reconocimientos facial. Como explicó en un artículo de EL PAÍS la directora general de la UNESCO, Audrey Azoulay, se trata de “un llamamiento a cambiar el modelo de negocio para lograr que la IA y la tecnología sean seguras, justas e inclusivas”. En definitiva, que la tecnología cumpla su propósito: ayudar a los humanos.

Puedes seguir a EL PAÍS TECNOLOGÍA en Facebook y Twitter o apuntarte aquí para recibir nuestra newsletter semanal.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.