Google arregla su algoritmo ‘racista’ borrando a los gorilas

Google Photos confundía personas negras con simios. Este parche muestra la opacidad de los algoritmos

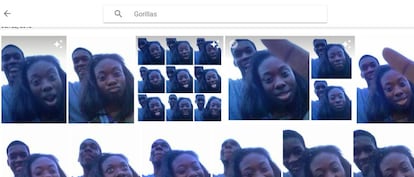

En junio de 2015, un usuario de Google Photos descubrió que el programa etiquetaba a sus amigos negros como gorilas. La inteligencia artificial de Google no era capaz de distinguir una tez oscura de humano de la de simios como gorilas y chimpancés. Ese sesgo racista de la máquina obligó a disculparse a Google, que se comprometió a buscar una solución al error. Dos años después, la solución está clara: para que el programa no confunda a humanos con gorilas, han sacado a los gorilas del buscador. Y a los chimpancés. Y a los monos.

En Wired han hecho la prueba, alimentando a la máquina con miles de fotos, incluidas las de estos grandes simios y también de otras especies de monos. El programa —ideado para clasificar las fotos de los usuarios por sí solo, usando inteligencia artificial— responde a la perfección cuando le pides que encuentre orangutanes, gibones, babuinos o monos tití, encontrándolos sin problemas. Pero se queda en blanco cuando le preguntas por "monos", "gorilas" y "chimpancés", aunque tenga unos cuantos en sus entrañas. El parche de Google es hacer desaparecer estos animales del léxico de esta aplicación para la gestión de fotos personales (no el buscador de imágenes). El programa tampoco sabe buscar "hombre negro" o "mujer negra".

La forma de solucionar el problema es borrar el problema: autocensurar esas etiquetas. "La tecnología de etiquetado de imágenes todavía es joven y lamentablemente no es perfecta", respondió un portavoz de Google, admitiendo el parche. Flickr generó un problema similar, al etiquetar a negros como simios. El algoritmo de Facebook permitía discriminar por su raza a los usuarios. Estos subproductos inesperados están por todas partes.

"Los que están en grupos históricamente marginados —mujeres, no blancos y menos educados— se muestran como los más temerosos ante la tecnología", asegura un estudio

Este episodio es un ejemplo perfecto de algunos de los problemas que se están descubriendo en el ámbito de la inteligencia artificial. Por ejemplo, que los algoritmos heredan sesgos y prejuicios presentes en las bases de datos (alimentadas por humanos) y en las manos de los programadores que los desarrollan. Los innovadores, los inventores, tienden a ser hombres blancos de buena familia, y eso termina asomando de algún modo en el fruto de su trabajo.

También demuestra que la tecnología que permite a las máquinas el reconocimiento visual es mucho más difícil de perfeccionar de lo que a veces creemos. Es posible que dentro de poco tengamos coches automatizados circulando por las calles, tomando decisiones difíciles como a quién atropellar. En caso de duda, ¿qué ocurre si a las máquinas les cuesta diferenciar a un animal de una persona? ¿Elegirá salvar a la persona de tez más clara y atropellará a la de piel oscura porque puede ser un mono? "Es muy difícil modelar todo lo que verá su sistema una vez que esté en vivo", reconoce Vicente Ordóñez Román, profesor de la Universidad de Virginia, en Wired.

Este incidente ilustra un problema mayor: las máquinas terminan siendo una caja negra, opaca y llena de secretos, incluso para sus propios desarrolladores

Además, este incidente ilustra un problema mayor sobre el que vienen advirtiendo los expertos en inteligencia artificial: las máquinas terminan siendo una caja negra, opaca y llena de secretos, incluso para sus propios desarrolladores. El programador sabe con qué elementos ha alimentado al algoritmo y sabe cuáles son los resultados, pero no conoce en detalle los procesos que suceden dentro del cerebro de silicio. Cuando algo falla, como en este caso, no saben exactamente por qué ni pueden ir directamente a solucionar el problema porque no saben dónde está. "Podemos construir estos modelos, pero no sabemos cómo funcionan", reconocía un especialista en diagnóstico de enfermedades usando inteligencia artificial.

"La toma de decisiones automatizada puede plantear riesgos significativos para los derechos y libertades de las personas que requieren salvaguardias apropiadas", advertía un informe de AI Now, un instituto dedicado a la investigación sobre los problemas derivados del uso de la inteligencia artificial. Ese informe criticaba la opacidad con la que operan esas cajas negras. En algunos casos opacas para sus creadores y por lo general opacas para la sociedad a la que afectan sus decisiones: finanzas, sanidad, seguros, mercado de trabajo, decisiones judiciales... Todos se ven afectados ya por decisiones algorítmicas.

Un estudio reciente sobre la percepción social de los robots mostraba una conclusión interesante en este contexto: "Los que están en grupos históricamente marginados —mujeres, no blancos y menos educados— se muestran como los más temerosos ante la tecnología". Seguramente no sea casual.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.