De cuando la filosofía rescató a la inteligencia artificial

Tenemos que aprender a tratar a nuestros robots de forma ética, sostiene el autor. Muy posiblemente, nuestros robots serán más éticos que nosotros ya que sabrán tomar decisiones imparciales

Año 2055. Detrás de un vehículo autónomo (VA) circulan tres autobuses escolares. De repente, se cruza un borracho por la carretera. ¿Qué debe hacer el vehículo? ¿Frenar y salvar al peatón, lo que provocaría un accidente en cadena, o atropellar al peatón y evitar un accidente de peores consecuencias?

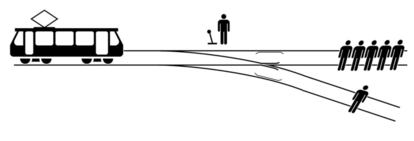

Esta es una versión del famoso Dilema del Tranvía planteado por la filósofa británica Philippa Foot en 1967: un tren descontrolado va a arrollar a cinco personas. Accionando una palanca, un observador puede desviar el tren y, en ese caso, sólo moriría una persona. ¿Qué decisión es más ética? ¿Permitir que el tren siga su curso sin interferir o sacrificar a una persona para salvar a cinco?

El 90% preferiría salvar a cinco personas y sacrificar a una, y además según un reciente estudio de Natalie Gold (Universidad de Oxford), también hay importantes diferencias culturales entre oriente y occidente. Esta decisión mayoritaria se ajustaría a la teoría utilitarista del filósofo inglés Jeremy Bentham, que sostenía que la elección moralmente correcta es aquella que maximiza el bien común. Sin embargo, el utilitarismo tiene sus contradicciones porque, ¿qué hubiese dicho ese 90% si la persona de la segunda vía fuera hijo suyo?

Michael Stevens, psicólogo estadounidense, hizo el experimento simulado del Dilema en 2017 y descubrió que la intención ética y el instinto no tienen nada que ver. Según sus investigaciones, el 90% nunca accionaría la palanca, sino que se justificaría (“seguro que el tren lleva sensores”, “alguien se dará cuenta”). Nadie quiere tener que elegir entre dos opciones horribles y luego responsabilizarse de las consecuencias, explica.

Entonces, si hay decisiones éticas que ni siquiera nosotros podemos tomar, ¿cómo vamos a programar máquinas inteligentes que sí lo hagan?

Para complicar las decisiones éticas un poco más, debemos resaltar que el resultado de cualquier decisión depende de la variable tiempo, ya que no siempre las acciones tienen un resultado inmediato. Los investigadores Nidhi Kalra y David Groves de la RAND Corporation, calcularon que la libre introducción de VAs haría que sus algoritmos de conducción aprendieran más rápidamente. Esto salvaría cientos de miles de vidas futuras. El beneficio de la acción, por lo tanto, iría a parar a la siguiente generación.

Cualquier aplicación de IA presenta dilemas éticos, no solo los vehículos autónomos. Por ejemplo, ¿cómo tratan los datos personales que recogen Siri (Apple) y Alexa (Amazon) en casa para aprender y mejorar la asistencia personalizada? Con el tiempo, Siri y Alexa se convertirán en robots que ayudarán en las tareas de la casa. Pero, ¿qué conceptos éticos les enseñaremos si en muchos casos ni siquiera sabemos tomar decisiones éticas?

El bioquímico y escritor Isaac Asimov escribió las Tres Leyes de la Robótica que vimos en la película I, robot para intentar apaciguar el miedo que nos generan las máquinas. Los humanos desconfiamos incluso de las que funcionan mejor que nosotros mismos y, por otra parte, les exigimos una perfección que no tenemos. Un ejemplo: Waymo, el vehículo autónomo de Google, puede conducir sin fallo durante más de 8200 kilómetros pero, según un estudio del Pew Research Center, el 56% de los estadounidenses no se subiría jamás a un vehículo de estas características.

Las tres leyes son demasiado abstractas y carecen de contexto para una máquina que sólo entiende de unos y ceros, dice James Kuffner, catedrático de robótica en la Carnegie Mellon University. Y para el filósofo de IA Aaron Sloman, tampoco son capaces de resolver la cuestión del daño a corto o largo plazo en relación al beneficio.

Aparte de saber implementar conceptos éticos, nuestro principal problema será el aprender como humanos a tratar a nuestra IA de forma ética. Con relativa facilidad podemos dotar a las cosas de cualidades humanas y emocionales, como el actor Joaquin Phoenix a su novia virtual en la película Her. Nuestro antropomorfismo se acentúa aún más si podemos tocar al robot y además, éste puede moverse. Muchos recordamos la historia del robot hitchBOT, creado por David Smith de McMaster University. hitchBOT apenas hablaba y su única misión era hacer auto-stop. Llegó a Viajar por Europa y Norteamérica gracias a la simpatía que generaba. Su asesinato en Philadelphia en 2015 tuvo una repercusión emocional en todo el planeta.

Tenemos que aprender a tratar a nuestros robots de forma ética, pero no porque puedan rebelarse contra nosotros, sino porque el no hacerlo nos dañaría psicológicamente, sostiene Kate Darling del Massachussetts Institute of Technology. Los robots son un reflejo de nuestra humanidad y su desarrollo nos está llevando a cuestionar muchos conceptos éticos fundamentales que aún están por solucionar.

La aceptación de la IA en la sociedad dependerá de hasta qué punto es segura, asimila nuestros códigos de conducta y genera confianza. Y, muy posiblemente, nuestros robots serán más éticos que nosotros ya que sabrán tomar decisiones imparciales. Quién sabe si en el futuro los robots nos enseñarán a estar en el mundo de una forma más ética y justa.

Diego Miranda-Saavedra es científico de datos y profesor en los máster de Inteligencia de Negocio y Big Data de los estudios de de Informática, Multimedia y Comunicacion de la Universitat Oberta de Cataluya (UOC).

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.