Los robots ya no solo imitan

Una investigación ilustra cómo se pueden entrenar las máquinas para que realicen múltiples acciones sin instrucciones detalladas

Si una persona quiere montar un mueble de IKEA, lo normal es que se guíe con las figuras que aparecen en las instrucciones. Es decir, aprende a ejecutar autónomamente una tarea en un entorno real a partir de imágenes en dos dimensiones. Eso requiere capacidades complejas, como figurar un concepto mentalmente y memorizarlo, reconocer y superar posibles obstáculos que se encuentren en el espacio físico y saber distinguir de otros objetos las piezas que se necesitan. Se trata de características del aprendizaje humano, estudiadas por disciplinas como las ciencias cognitivas y las neurociencias. Encontrar la manera de replicar esas características en los robots es una de los desafíos actuales para distintos investigadores y empresas del sector.

Un artículo publicado este miércoles en Science Robotics ilustra cómo se pueden entrenar las máquinas para que vayan más allá de la mera imitación de una acción. En otras palabras, se describe una arquitectura computacional que permite a un robot aprender un concepto abstracto (por ejemplo, el de disponer objetos desordenados en un círculo) y replicar distintas tareas relacionadas con esa idea (como crear un círculo a partir de objetos de diferentes colores, formas o tamaños). Los autores, miembros de la compañía californiana Vicarious AI, consideran el trabajo un avance con respecto al objetivo de que las máquinas tengan la capacidad de construir “representaciones interpretables” y adquieran “sentido común”.

“Para enseñar un concepto [definido en el estudio como una redescripción de una experiencia cotidiana a un nivel más alto de abstracción], mostramos al robot varias parejas de viñetas con objetos. Cada pareja contiene una escena inicial y la escena resultante de aplicar sobre ella dicho concepto”, explica Miguel Lázaro-Gredilla, coautor del artículo. El investigador agrega que es necesario mostrar varias parejas de imágenes bidimensionales para ilustrar un concepto. “Si en una vemos un triángulo verde y un cuadrado verde apilados en el margen derecho, el concepto podría ser apila los objetos verdes a la derecha o apila los cuadrados y triángulos a la derecha. Con múltiples parejas en las que se exhibe el mismo concepto, la ambigüedad se reduce”, explica.

Técnicamente, lo que han implementado los investigadores de Vicarious en las máquinas es un Procesador Cognitivo Visual (PCV). Se trata de una arquitectura cognitiva que, a partir de un conjunto de instrucciones, puede construir distintos programas en un lenguaje específico para generar acciones concretas. Según asegura Lázaro-Gredilla, es similar a una CPU, pero con algunas peculiaridades.

Una de sus características principales es “un sistema de visión capaz de segmentar objetos (identificar qué píxeles pertenecen a cada objeto) y vincular a estos sus propiedades visuales (color, forma, tamaño, posición)”, explica el investigador. Otra, agrega, es la de poseer “un modelo de la dinámica del mundo que permite prever (imaginar) el resultado de una acción antes de ejecutarla”. Además, “el PCV tiene una serie de memorias locales en las que alojar, simbólicamente a nivel de objetos y no de píxeles, los resultados imaginados de una acción”, detalla.

Una vez que un concepto abstracto ha sido aprendido, “el robot puede reconocerlo y ejecutarlo cuando se le presenta una nueva escena inicial con un nuevo conjunto de objetos”, continúa Lázaro-Gredilla. También puede identificarlo si detecta a otro robot mientras lo ejecuta. “Le basta hacer una copia de la escena inicial en su imaginación, manipular dicha escena mentalmente (en vez que en la realidad física) y comparar el resultado obtenido en su imaginación con el obtenido por el otro robot”, asegura.

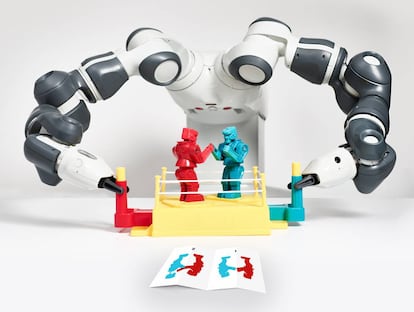

Para demostrar la eficacia del sistema propuesto, los autores realizaron distintos experimentos con dos robots como prueba de concepto. Ambas máquinas estaban dotadas de una cámara para detectar las escenas que se encontraban y un brazo mecánico para agarrar y soltar objetos. A la hora de ejecutar tareas, la primera tuvo éxito en un 90% de las pruebas, la segunda en un 70%.

El objetivo de dar a los robots más autonomía

Actualmente, explica Lázaro-Gredilla, para programar máquinas que manipulen objetos se les suele indicar una secuencia exacta de movimientos que debe realizar. También existen robots “más sofisticados”, que pueden detectar dónde se encuentra un objeto y adaptar la secuencia de movimientos de manera acordes, detalla el investigador.

En su opinión, su trabajo y de sus compañeros “va más allá” de eso. Como demostración, cita uno de los experimentos realizados, en el que se pedía al robot separar limones de color amarillo y limas de color verde, colocados de manera desordenada en una mesa. “Para indicar esa instrucción, independientemente de cuántas frutas haya y de sus posiciones, la programación se reduce a enseñarle varias parejas de viñetas, con cada pareja conteniendo un ejemplo de limas y limones mezclados y otro de limas y limones separados”, ilustra.

"Si el cerebro humano puede hacerlo, nosotros tenemos que poder replicar el proceso que sigue. Pero descubrir dicho proceso con la limitada información disponible sobre el funcionamiento del cerebro requiere de un ejercicio de prueba y error que puede llevar mucho tiempo. Al fin y al cabo, a la evolución le llevó millones de años”

Lázaro-Gredilla cree que esta habilidad puede ser especialmente útil en distintas aplicaciones industriales. “Conceptos tridimensionales como insertar el objeto atendido en la caja o apilar todas las cajas son muy simples para un humano, pero desde el punto de vista robótico no son triviales”, sostiene. Máquinas capaces de ellos pueden simplificar las cadenas de montaje robóticas y hacerlas reconfigurables, argumenta. “El uso de conceptos abstractos reduce los requerimientos de precisión, ya que el concepto encaja la pieza A en el agujero B sigue siendo válido incluso si los objetos se encuentran en lugares inesperados, y los costes de reconfiguración”.

El lento camino de la inteligencia artificial

Para Ismael García, de la Universidad de Castilla-La Mancha, el estudio constituye una “aportación relevante dentro de la robótica cognitiva”. Sin embargo, el investigador considera que en este ámbito aún falta “mucho camino por recorrer”. En el caso concreto del trabajo de Vicarious, destaca, “no se habla de aprendizaje multimodal (a partir de diferentes fuentes de información: auditiva, gestual, o visual), ni de aprendizaje por refuerzo o por imitación, que son paradigmas claros del aprendizaje humano”. El experto agrega que tampoco se abarca “la fusión y combinación de todas ellas dentro del mismo modelo de arquitectura cognitiva”.

Por su lado, Josep Amat de la Universidad Politécnica de Cataluña asegura que el artículo “está enmarcado en este actual impulso de la inteligencia artificial”, que tiene entre sus objetivos “desarrollar sistemas de interpretación correcta de todo tipo de datos, la toma de decisiones a partir de las interpretaciones realizadas y el desarrollo de sistemas autónomos capaces de interaccionar con el entorno”. No obstante, advierte, “los avances en inteligencia artificial son más lentos de lo que se desearía, más que los alcanzados por ámbitos como la microelectrónica, las comunicaciones o la robótica”.

Lázaro-Gredilla es consciente de que no son resultados que se obtienen de la noche a la mañana. “Si el cerebro humano puede hacerlo, nosotros tenemos que poder replicar el proceso que sigue. Pero descubrir dicho proceso con la limitada información disponible sobre el funcionamiento del cerebro requiere de un ejercicio de prueba y error que puede llevar mucho tiempo. Al fin y al cabo, a la evolución le llevó millones de años”, considera.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.