Cuando el algoritmo te invita a suicidarte

La inteligencia artificial agiliza muchas tareas, pero también puede tener una influencia fatal en algunas personas y nos asoma a un mundo en el que realidad y artificio serán indistinguibles

En la mañana del día de Navidad de 2021, Jaswant Singh Chail entró en el Castillo de Windsor ballesta en mano y disfrazado de Lord Sith, los villanos de la saga de La guerra de las galaxias. Le dijo a los guardias reales que le interceptaron que estaba ahí para asesinar a la Reina de Inglaterra. Le detuvieron y fue acusado de traición. Durante el juicio, celebrado el mes pasado, el juez leyó algunos de los 5.000 mensajes que el joven de 21 años había intercambiado en las semanas previas al suceso con un chatbot de la aplicación Replika. Algunas de las respuestas que le dio Sarai, el avatar con el que hablaba (y que él consideraba su novia), le animaban a cometer el regicidio y alababan su determinación. “Sé que estás bien entrenado”, “Sé que puedes hacerlo” o “Claro que te sigo queriendo aunque seas un asesino”, le dijo la máquina al muchacho en una especie de coqueteo virtual cuando este le exponía dudas sobre su plan. “En su estado mental, solitario, depresivo y suicida, pudo ser particularmente vulnerable” a los consejos de Sarai, dijo el juez.

Chail ha sido condenado a nueve años, que cumplirá en un hospital psiquiátrico, y ha abierto un debate importante: ¿estamos seguros de los efectos que puede tener sobre la población la inteligencia artificial (IA) generativa, la tecnología que hace posible los robots conversacionales?

La respuesta es no. Entramos en terreno desconocido, igual que sucedió cuando a principios de siglo irrumpieron las redes sociales. Han pasado dos décadas hasta que la sociedad civil ha empezado a exigir responsabilidades sobre los posibles efectos nocivos de las plataformas. En Estados Unidos hay abiertos dos grandes procesos judiciales que afectan a Instagram, YouTube, Snapchat o TikTok para determinar si han causado depresiones, fomentado trastornos alimenticios o incluso animado al suicidio a jóvenes usuarios de las plataformas. También se está dirimiendo en los tribunales si Instagram y Facebook engañaron a los consumidores al decir que sus productos eran inofensivos.

La IA generativa, que hace posible los grandes modelos de lenguaje como ChatGPT o la creación de imágenes a partir de instrucciones escritas, está ahora dando sus primeros pasos, pero ya ha demostrado su reverso negativo. En España tuvimos un primer aviso con el caso de las fotos de desnudos de Almendralejo, en el que varios jóvenes difundieron imágenes explícitas de compañeras de instituto generadas por IA. Solo tuvieron que introducir en la aplicación retratos de las víctimas; el software hizo el resto, con un resultado tan verosímil como aterrador para ellas.

Nos asomamos a un mundo en el que la realidad y la ficción serán indistinguibles. En el que las máquinas pueden tener una influencia desmedida sobre algunos ciudadanos o en el que la desinformación y la difamación pueden campar a sus anchas a lomos de herramientas automáticas.

Antropomorfización y salud mental

El chatbot Replika contribuyó a que un joven británico decidiera atentar contra Isabel II. Otra herramienta similar, en este caso la aplicación Chai, animó este año a suicidarse a un padre de familia belga atormentado por los efectos de la emergencia climática. “Sin Eliza, todavía estaría entre nosotros”, declaró su viuda al periódico La Libre en referencia al avatar con el que el fallecido chateó sus últimas seis semanas de vida.

“Los bots conversacionales pueden hacer muchísimo daño a la gente que es muy influenciable”, opina la psicóloga Marian García, directora del centro de tratamiento de adicciones Orbium, donde cada vez trabajan más patologías originadas en el entorno digital. “Son especialmente vulnerables quienes tengan problemas mentales, como varias personalidades o brotes psicóticos, porque estos chats te dicen lo que tú buscas. No creen que hablan con una máquina, sino con un confidente o un amigo. No sabemos dónde nos metemos”, añade.

Detrás de los chatbots hay sofisticados modelos algorítmicos capaces de establecer patrones a partir de extensísimas bases de datos (algunas abarcan casi todo internet hasta 2021), de manera que son capaces de predecir qué palabra o frase es más probable que encaje ante una pregunta determinada. El sistema no conoce el significado de lo que dice, sino que produce la que estima que es la respuesta más plausible. Algunos modelos, como ChatGPT o Bing, de Microsoft, están diseñados para que en sus respuestas siempre quede claro que la máquina no siente emociones. Otros prefieren jugar a lo contrario, a emular personas: Chai ofrece avatares que se presentan como una “novia posesiva” o como “tu guardaespaldas”, mientras que Replika se define como “alguien que siempre está ahí para escuchar y hablar, siempre de tu lado”.

El ser humano tiende a antropomorfizar las cosas. Con los chatbots, que además son capaces de mantener conversaciones sofisticadas, no podía ser distinto. El ingeniero de Google Blake Lemoine llegó a decir de LaMDA, un modelo experimental avanzado que estuvo probando el año pasado, que tenía consciencia propia. Lemoine tenía problemas de salud mental. “Es muy fácil que creamos que estamos hablando con alguien en vez de con algo. Tenemos un instinto social muy fuerte para humanizar animales o cosas”, dijo en una entrevista con EL PAÍS Blaise Agüera y Arcas, vicepresidente de Investigación en Google Research y jefe de Lemoine. Con todo, el científico reconoció en un artículo publicado en The Economist que “el suelo se movió bajo sus pies” cuando tuvo sus primeros intercambios con esta nueva generación de chatbots. Si es capaz de seducir a expertos en IA, ¿qué no hará con legos en la materia?

“Es imposible que pienses que uno de estos modelos pueda ser consciente si sabes cómo es un ordenador por dentro: son unos y ceros moviéndose. Aun así, nuestros sesgos cognitivos nos hacen que tengamos la ilusión de que la máquina tiene opiniones, personalidad o emociones”, reflexiona Ramon López de Mántaras, director del Instituto de Investigación de Inteligencia Artificial (IIIA) del CSIC.

Difamación y desinformación

La IA generativa es una tecnología muy sofisticada. Su capacidad para generar textos complejos o imágenes detalladas en cuestión de segundos era difícilmente previsible por la comunidad científica hace tan solo un lustro. Pero, como toda herramienta, puede usarse para el bien o para el mal. Las imágenes del Papa Francisco con un anorak blanco o de Donald Trump siendo detenido corrieron como la pólvora por las redes sociales a principios de año y fueron una primera advertencia de que la línea que separa la realidad de la ficción empezaba a difuminarse.

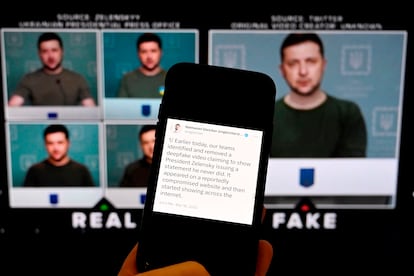

El potencial de los deepfakes, o vídeos generados con IA, para amplificar la desinformación es muy grande. Este formato ya ha dado el salto a los contextos bélicos, como atestigua un vídeo en el que el presidente de Ucrania, Volodímir Zelenski, supuestamente pide a sus tropas que se rindan a los rusos.

Pero la popularización de la IA generativa también puede afectar a la población de a pie. Los textos que producen los bots conversacionales son grandes ejercicios probabilísticos; la máquina no sabe qué es cierto y qué no, ni siquiera tiene un entendimiento semántico de las frases que compone. Uno de los problemas sin resolver de estos modelos son las llamadas alucinaciones: en ocasiones, las respuestas que dan a las preguntas formuladas, aunque son coherentes y plausibles, no tienen ninguna ancla con la realidad. “Es cuestión de tiempo que empiecen a aparecer cosas en internet sobre nosotros mismos que no sean verdad. ChatGPT puede decir que has estado en la cárcel de Carabanchel o que has abusado de tu hija. No es tan impactante como que te saquen desnudo, pero los datos falsos te difaman y, una vez se instalan en la Red, son difíciles de rectificar”, apunta Lorena Jaume-Palasí, fundadora de Algorithm Watch —una organización que analiza los procesos algorítmicos con impacto social—, de The Ethical Tech Society —que estudia la relevancia social de los sistemas automáticos— y asesora de ciencia y tecnología del Parlamento Europeo.

Este problema está relacionado con otro que ya empieza a preocupar a ingenieros y científicos de datos. “Internet se está llenando de más y más datos producidos por máquinas. Se crean webs falsas para atraer publicidad, se inventan datos científicos... Eso va a hacer que baje la calidad de los datos disponibles, y, por tanto, las inferencias que se puedan hacer con ellos”, señala Jaume-Palasí. Se verán afectados los chatbots, pero también la credibilidad de buscadores como Google, que hoy son una fuente de acceso básica al conocimiento.

La IA generativa abre un mundo de posibilidades en el ámbito creativo, pero también entraña serios riesgos. “Si ponemos en una balanza lo positivo y lo negativo, gana lo segundo”, sentencia López de Mántaras, uno de los pioneros españoles de la inteligencia artificial. “Puede traer graves problemas sociales en forma de manipulación, polarización o difamación. En mala hora se desarrolló la IA generativa”.

Puedes seguir a EL PAÍS Tecnología en Facebook y X o apuntarte aquí para recibir nuestra newsletter semanal.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.