¿Cómo piensa una inteligencia artificial? La gran sorpresa es que ‘intuye’

Ha ocurrido algo extraordinario, aunque aún no nos hemos dado cuenta del todo: unos algoritmos son capaces de resolver tareas intelectuales. Estos modelos no son réplicas de la inteligencia humana. Su inteligencia es limitada, distinta y, curiosamente, resulta que funcionan de un modo que se parece bastante a la intuición. Esta es una de las siete lecciones que hemos aprendido hasta ahora sobre ellas y sobre nosotros

La inteligencia artificial nació en los años cincuenta cuando un grupo de pioneros se preguntó si podrían hacer que sus ordenadores “pensaran”. Después de 70 años, algo tremendo ha ocurrido: las redes neuronales resuelven tareas cognitivas. Durante 300.000 años, esas tareas fueron un monopolio en exclusiva de seres vivos. Ya no. No es controvertido: es un hecho. Y ha ocurrido de golpe. El aprendizaje automático con redes neuronales ha resuelto problemas que eludieron a las máquinas durante décadas:

- ChatGPT, Gemini o Claude manejan el lenguaje

- Tienen conocimiento fluido y enciclopédico

- Escriben código a nivel súperhumano

- Describen imágenes a nivel humano

- Transcriben a nivel humano

- traducen a nivel humano

- Otros modelos generan imágenes realistas, predicen huracanes, arrasan al Go o conducen coches en Phoenix.

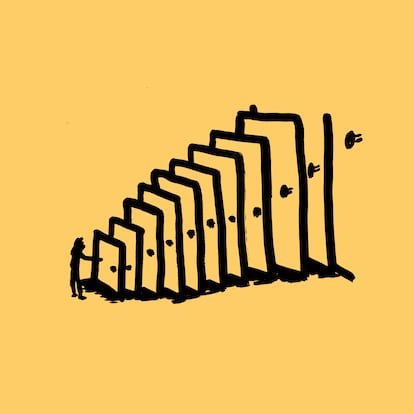

El investigador en IA François Chollet lo resume así: “En la última década, el aprendizaje profundo ha logrado nada menos que una revolución tecnológica”. Cada uno de estos logros habría sido un avance notable por sí solo. Resolverlos todos con una misma técnica es como descubrir una llave maestra que abre de golpe todas las puertas.

¿Por qué ahora? Convergieron tres piezas: algoritmos, cómputo y datos masivos. Incluso podemos ponerles rostro, porque detrás de cada elemento hay una persona que hizo una apuesta. El académico Geoffrey Hinton siguió trabajando en redes neuronales cuando sus colegas las abandonaron. Jensen Huang, el CEO de Nvidia, mejoró los chips de cálculos paralelo mucho más de lo que necesitaban los videojuegos que sostenían su negocio. Y la investigadora Fei-Fei Li arriesgo su carrera para construir ImageNet, una colección de imágenes que parecía estúpidamente grande. Pero esas tres piezas se alinearon. En 2012, dos estudiantes de Hinton, Ilya Sutskever y Alex Krizhevsky, las combinaron para conseguir un éxito espectacular: construyeron AlexNet, una red neuronal capaz de “ver”, reconocer imágenes, mucho mejor que nada anterior.

El rumor corrió deprisa entre los laboratorios: esto funcionaba. El equipo de Hinton había dado con una fórmula: redes, datos y cómputo en cantidades gigantescas.

El impacto de esta transformación será profundo. Como ha dicho Ethan Mollick, uno de los observadores más agudos del momento, aunque el desarrollo de la IA se parase mañana, “todavía tendríamos una década de cambios en industrias enteras”.

Nadie sabe hasta dónde llegarán estas máquinas. Entre el hype que promete inteligencia sobrehumana cada año y la negación que ignora lo evidente, nos perdemos algo crucial: los modelos IA actuales, por sí solos, ya son algo fascinante. La última gran sorpresa es que funcionan de un modo que recuerda bastante a la intuición. Su desarrollo nos enfrenta a preguntas profundas, sobre su funcionamiento y el nuestro. Y ya nos ha dejado algunas respuestas.

Lección 1. Las máquinas pueden aprender

Es la lección más ignorada y menos controvertida: las máquinas aprenden. Es la lección más ignorada y menos controvertida: las máquinas aprenden. El regulador centrífugo de James Watt (1788) ya ajustaba la velocidad de las máquinas de vapor sin supervisión. Era el principiode un descubrimiento: no es necesario especificar por completo las reglas de un artefacto para que funcione.

La programación clásica consiste en definir unas reglas y esperar respuestas: “Así se suma; ahora suma 2 y 2”. Pero el aprendizaje automático funciona al revés: le das ejemplos y el sistema descubre las reglas. Chollet lo resume en Deep Learning with Python (aprendizaje profundo con Python, sin traducir al español): “Un sistema de aprendizaje automático se entrena en lugar de programarse”. El caso más potente son los grandes modelos de lenguaje como Claude, Gemini o ChatGPT. Son redes neuronales: madejas de unidades de cálculo conectadas en capas sucesivas —que imitan las neuronas del cerebro—, con cientos de miles de millones de parámetros que se ajustan durante su entrenamiento. Cada acierto y cada error ajusta esos parámetros. Este aprendizaje es un proceso larguísimo, que se vuelve opaco por enormidad, pero que no es misterioso. Es matemático. Y ha funcionado.

Se esconde aquí lo que en el campo llaman la “lección amarga”. Durante décadas, los expertos intentaron codificar su conocimiento en las máquinas. Fracasaron. Lo que tuvo éxito fue crear las condiciones para que el conocimiento emergiese… y apartarnos.

Lección 2. Las IA tienen habilidades emergentes

La lección amarga esconde una idea profunda: de procesos simples puede emerger algo complejo. Es el principio que organiza la vida. La evolución no diseñó cada órgano; lanzó un proceso —mutación, recombinación, selección— y de ahí brotaron ojos, alas, cerebros. Ahora hemos replicado ese proceso en máquinas.

Volvamos a los grandes modelos de lenguaje (LLM, por sus siglas en inglés). Sin entrar a delimitar sus capacidades—algo divisivo—, es evidente que manejan el lenguaje con flexibilidad. Puedes conversar con ChatGPT, detecta el sarcasmo, responde a contextos cambiantes. Pero nadie le programó gramática, ni le explicó el sarcasmo. ¿Cómo es posible? La mayoría de expertos asumían que dominar el lenguaje con fluidez requeriría una inteligencia general (que fuese similar a la humana en un amplio rango de tareas). Sin embargo, resultó que el entrenamiento de “predecir la siguiente palabra” tenía poder emergente.

El procedimiento es fácil. El primer entrenamiento de un LLM es lo que llamamos pretraining: al modelo se le presentan fragmentos de texto de internet y se le pide predecir el siguiente token (una palabra o fragmento). Cuando falla, se ajustan los parámetros responsables del error. Este simple proceso, repetido un número astronómico de veces, acaba creando modelos que predicen palabras muy bien… y que en el camino aprenden mucho más.

Para Carlos Riquelme, investigador en Microsoft AI, este fue un hallazgo esencial. Nos contó su asombro de 2017, cuando trabajaba en Google Brain: “Me sorprendió el poder de la escala. Al escalar un método muy sencillo (predecir la siguiente palabra) con gran cantidad de datos y con modelos potentes, termino resultando evidente que se podía replicar en buena parte la capacidad lingüística del ser humano”.

La clave es la siguiente: para predecir palabras necesitas capturar nociones complejas. Supón que tienes que completar estas frases que recoge Blaise Agüera y Arcas en un brillante libro recién publicado, What is Intelligence? (qué es la inteligencia).

- “En monedas de un centavo apiladas, la altura del monte Kilimanjaro es…”

- “Tras morir el perro, Jen no salió de casa en días, así que sus amigos decidieron…”

Llenar estos huecos exige conocimiento geográfico, matemáticas, sentido común y hasta “teoría de la mente”, para ponerte en el lugar de Jen y sus amigos. De esta manera, “lo que parecía una estrecha tarea lingüística —predecir la siguiente palabra— resultó contener todas las tareas”, argumenta Agüera y Arcas en su libro. Por ejemplo, cuando se le pasa la frase de Kilimanjaro, el último modelo de Google, Gemini 3, piensa un minuto y luego responde (correctamente): “La altura del monte es de aproximadamente 3.9 millones de centavos de dólar”. Para los amigos de Jen, ofrece opciones diferentes, desde “presentarse en su puerta con helado” hasta “turnarse para visitarla”.

Agüera y Arcas nos daba otro ejemplo en un intercambio de correo electrónico: las multiplicaciones. Un LLM como Gemini o ChatGPT podría haber memorizado de internet completados comunes, como “2 × 7”. Pero también predicen “871 × 133”, que no aparece en ningún sitio. ”Acertar estas operaciones en general implica haber inferido algoritmos no triviales a partir de ejemplos”. Es el truco de la emergencia: un proceso simple produce capacidades complejas.

Lección 3. La IA aprende con una “evolución cutre”

Nuestras IA no aprenden como las personas. Un niño nace con mucha “maquinaria” innata, y luego aprende con pocos datos y pocas experiencias, con una eficiencia notable. El pretraining de un LLM es muy distinto: comienza con una tabula rasa y aprende muy lentamente con millones de ejemplos. El tópico son los gatos: entrenar una IA para identificar gatos en una imagen necesita miles de fotos, pero una niña de dos años los distingue viendo tres.

Hay un símil mejor: la evolución. El célebre investigador Andrej Karpathy describe el entrenamiento de un LLM como una especie de “evolución cutre”. En un podcast reciente hablaba de lo sorprendente que ha sido su desarrollo: “Podemos construir estas ‘entidades espectrales’ imitando documentos de internet. Esto funciona. Es una manera de crear algo con un montón de conocimiento e inteligencia incorporada, similar quizás a lo que hizo la evolución”.

¿Por qué funciona esta analogía? Porque la evolución también surge a partir de una cantidad enorme de tiradas y cambios diminutos (mutaciones y simbiosis), repetidos durante millones de años. Es un proceso ciego y lento que acaba incrustando capacidades en los seres vivos: instintos, reflejos o patrones. Es desordenado y ruidoso. Por eso cada gen incide en muchas características de un organismo; y por eso las medicinas tienen efectos secundarios, porque perturban otros circuitos además del deseado.

En realidad, la sorpresa de que una IA domine el lenguaje prediciendo palabras —lo que sorprendió a Riquelme— me recuerda al shock que provocó Darwin: ¿cómo aceptar que los animales, las personas y hasta sus poemas son el subproducto de un proceso ciego que solo busca “maximizar copias”?

Lección 4. Hemos automatizado la cognición

François Chollet es cauteloso al hablar de inteligencia artificial. Prefiere llamarla “automatización cognitiva”. La verdadera inteligencia, a su juicio, exigirá algo que los modelos actuales no tienen, “autonomía cognitiva”, la habilidad de enfrentar lo desconocido y adaptarse. Chollet quiere frenar las exageraciones, aunque al mismo tiempo reconoce un logro notable: estamos automatizando tareas cognitivas a escala industrial. “Lo sorprendente del deep learning es cuánto se puede lograr con memorización pura”, dice por correo. Para él, los LLM no tienen el razonamiento deliberado y eficiente que los humanos sí tenemos. Por eso al principio cometían errores burdos, como fallar contando las erres en la palabra raspberries. Su sorpresa es que a menudo pueden suplantar ese razonamiento: “Si tienes experiencia casi infinita, la inteligencia no es tan crítica”.

Otros expertos ven más que memorización: ¿estamos ante inteligencias reales? Andrej Karpathy cree que sí. En el podcast de Dwarkesh Patel explicaba que el pretraining hace dos cosas: “Primero, captura un montón de conocimiento. Segundo, se vuelve inteligente. Observando patrones algorítmicos en internet, realmente activa circuitos dentro de la red neuronal para luego poder aprender en contexto y más”.

Jeremy Berman, creador del algoritmo líder en ARC Prize, se convenció con los modelos razonadores, que llegaron hace cosa de un año y que tienen etapas de aprendizaje sin ejemplos: “Me sorprendió que puedes entrenar un modelo en sus propios intentos y eso le permite pensar y aprender por sí mismo”, explica en un intercambio de mensajes. Se refiere al aprendizaje por refuerzo (RL) que describieron los creadores de DeepSeek R1. “Si le planteas un problema matemático a un LLM, lo dejas responder 100 veces y entrenas sobre sus mejores respuestas, el LLM aprende. Esto escapa a la pura memorización del pretraining”. Gracias a eso los modelos de última generación resuelven problemas largos y complejos que sus versiones de hace unos meses eran incapaces.

Carlos Riquelme apunta que hay diferencias semánticas: “Se pueden memorizar algoritmos, mecanismos, maneras de razonar. Alguien puede llamar a eso ‘circuitos para pensar’ y otros decir que simplemente se memorizó el algoritmo, como nosotros aprendemos a sumar”. Además, Riquelme destaca que el RL es un aprendizaje más activo. Desde el momento en que el modelo genera sus respuestas y recibe retroalimentación, “puede terminar memorizando algo que no estaba en sus datos iniciales”.

Agüera y Arcas cree que la IA es inteligencia real. Sin más calificaciones. Cree que los modelos de Gemini, ChatGPT o Claude muestran una capacidad de generalización que va más allá de lo que podemos llamar memorización. Y le sorprende que Chollet sostenga lo contrario: “¿Qué evidencia busca?”, nos dijo. Para él, la naturaleza ya demuestra que hay muchas formas de inteligencia, como las arañas Portia (que planifican ataques astutos) o los pulpos (que distribuyen su cognición entre sus patas).

Lección 5. Es más intuitiva que racional

Aquí llega la paradoja. En el imaginario del siglo pasado, los robots serían fríos artefactos racionales: lógica, cálculo, deducción. Pero la IA actual funciona al revés.

El psicólogo Daniel Kahneman, premio Nobel de Economía, distinguió dos sistemas en el pensamiento humano. El Sistema 1 es rápido, automático, intuitivo; usa atajos y patrones. El Sistema 2 es lento, deliberado, racional; requiere esfuerzo consciente. El primero domina nuestra vida. Un bebé sabe mamar, retiramos la mano del fuego, sostenemos un vaso con la fuerza justa… Cosas que a los robots les costaron décadas.

La sorpresa es que los primeros LLM funcionan más cerca del Sistema 1 que del Sistema 2. Copian el estilo de Borges, escriben con ritmo. Hacen cosas sin “saber” explicar cómo, igual que nosotros. No razonan paso a paso: han capturado patrones a escala masiva. Precisamente el razonamiento deliberado —la deducción, el conteo, la lógica— son sus debilidades.

Por eso la innovación reciente busca añadir razonamiento. Los modelos “razonadores” mencionados —desde DeepSeek R1 hasta la generación actual— escriben para sí mismos antes de responder, generan cadenas de pensamiento paso a paso, más cautas y reflexivas. Otros avances buscan lo mismo: entrenamientos con refuerzo que premian el razonamiento correcto, lanzar múltiples intentos en paralelo para luego escoger el mejor, o conectar los modelos con herramientas matemáticas externas que superen sus limitaciones. Es el intento de construir un Sistema 2 artificial. Está funcionando al menos en cierto grado: los nuevos modelos arrasan en matemáticas y tests espaciales, donde los primeros LLM fallaban.

Lección 6. Los humanos somos también patrones

Si la IA captura patrones y con eso escribe, traduce y dibuja, surge una pregunta incómoda: ¿cuánto en nosotros funciona igual? Quizás más de lo que nos gusta admitir. Ya sabemos que nuestro cerebro aplica continuos atajos. Viendo el desempeño del aprendizaje automático, es inevitable preguntarse cuánto hay de automático en capacidades humanas que tradicionalmente unimos al talento o la experiencia —escribir con ritmo, escoger colores, captar tono—.

La historia de la ciencia es la historia de acabar con nuestra excepcionalidad. Galileo demostró que no somos el centro del universo; Darwin, que no somos creaciones especiales; la neurociencia, que no somos uno sino una multitud. Ahora la IA añade otra lección: habilidades que sentíamos muy nuestras pueden capturarse mediante patrones a escala masiva.

Lección 7. Vivimos una explosión cámbrica de IA

Las IA actuales tienen limitaciones profundas. Algunas las enumeró Andrej Karpathy en el podcast ya mencionado: “Carecen de suficiente inteligencia, multimodalidad, uso fluido de ordenadores o aprendizaje continuo. Cognitivamente son insuficientes. Creo que llevará una década resolver todos esos problemas”. Pero se ha abierto una veta con la fórmula exitosa de redes, datos y computación. Por eso vivimos un periodo cámbrico. Como aquella explosión de vida hace 540 millones de años, cuando surgieron repentinamente un montón de animales, ahora vemos una explosión de enfoques novedosos para la inteligencia artificial. Hay laboratorios explorando direcciones fascinantes: Sara Hooker trabaja en sistemas adaptativos, Fei-Fei Li quiere construir modelos que descifren el mundo físico, François Chollet investiga con IA que escriben y evolucionan sus propios programas lógicos.

¿Hasta dónde llegarán estos intentos? Blaise Agüera y Arcas no ve límites: “Nuestros cerebros logran hazañas increíbles de razonamiento, creatividad, empatía. Y esos cerebros son circuitería: no son algo sobrenatural. Y si no son algo sobrenatural, pueden modelarse de forma computacional”.

¿Lo lograremos en la práctica? Nadie lo sabe. Pero la pregunta ha dejado de ser teórica. Estamos viendo cómo unos algoritmos aprenden a leer, escribir, programar y razonar — torpemente a veces, sorprendentemente otras—. Pase lo que pase a partir de ahora, esto ya ha ocurrido. Y es algo extraordinario. Quizás acabe siendo la transformación más importante de nuestras vidas.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.