Superordenadores para descifrar la vida

La biología exige elevada potencia de cómputo para los grandes flujos de datos que genera

La investigación biológica ha superado su escenario tradicional de laboratorio con microscopios, probetas y cultivos, y se ha convertido en una disciplina ansiosa de potencia de computación. Sin ordenadores para comparar y ensamblar ingentes cantidades de datos no se habría podido descifrar el genoma humano. Ahora se trata de pasar de la era de la genómica a la de proteómica, aún más hambrienta de potencia de cálculo. Y los ingenieros están diseñando ya supercomputadoras a medida de las necesidades de la ciencia de la vida, basadas en el cómputo masivamente paralelo. Un objetivo crucial es poder enfrentarse a la enfermedad, al diagnóstico y a la terapia con perspectivas radicalmente nuevas.

Los expertos diseñan ordenadores de cómputo masivamente paralelo para biología

Los requisitos de computación en biología se acercan a los de física e ingeniería

"Las ciencias de la vida están a punto de una gran transformación desde una disciplina cualitativa, experimental y pobre en datos, a una ciencia cuantitativa, rica en datos en la que las simulaciones predictivas guían e interpretan los experimentos", señaló Aristides Patrinos (Departamento de Energía estadounidense) en el simposio Supercomputación y la nueva biología, de la reunión de la Asociación Americana para el Avance de la Ciencia (AAAS), celebrada en Denver (EE UU).

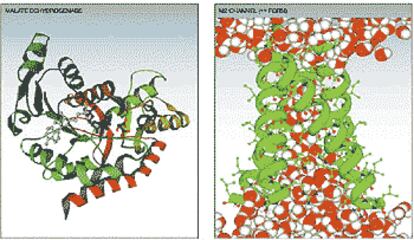

Computación y simulación son los dos ejes de esta nueva biología, que abarcan tanto la llamada bioinformática (computación para ensamblar, anotar y analizar la información del ADN, la estructura de las proteínas y otros datos biológicos) como las simulaciones biomoleculares (aplicación de métodos de modelización química para estudiar fenómenos bioquímicos). Además, señaló Patrinos, están emergiendo nuevas áreas, como los modelos químicos dinámicos de rutas metabólicas y reguladoras, o los modelos de reacción y difusión entre células.

En opinión de William Camp, (Laboratorios Nacionales Sandia, SNL), "por primera vez, los requisitos de computación de datos en bruto en biología se acercan a los de la física y la ingeniería".

Los participantes en el simposio coincidieron en que el enfoque tradicional de la supercomputación es poco apropiado para muchas tareas de la biología. Los problemas de física e ingeniería, que hasta ahora han sido los usuarios privilegiados de las máquinas superpotentes, exigen sobre todo solucionar muchas y complejas ecuaciones; sin embargo, las tareas de biocomputación que se vislumbran no son tan intensas en ecuaciones como en intercambio masivo de grandes flujos de datos, por ejemplo para la comparación de genomas o la resolución de estructuras de proteínas a partir de sus componentes bioquímicos.

"En la carrera por la velocidad de cálculo no se ha prestado suficiente atención a la comunicación en la computación", destacó Grant Hellefinger (SNL), coordinador del simposio. "Nos hacen falta máquinas más equilibradas". Las necesidades de computación van de un teraflop (un billón de operaciones por segundo) para tareas de secuenciación e identificación de genes, a mil teraflops para desentrañar respuestas celulares, pasando por el análisis de funcionalidad estructural o identificación de dianas terapeúticas, explicó.

La estrategia de supercomputación capaz de dar respuesta a las exigencias es la arquitectura de cómputo masivamente paralelo, que permite superar el límite de crecimiento de los sistemas multiprocesador fuertemente acoplados normales. La clave está en los llamados sistemas ligeramente acoplados del cómputo masivamente paralelo, que han sido posibles al superarse el problema de la interconexión entre procesadores trabajando al unísono. Esto dota al sistema de altísima velocidad de cómputo y facilidad de crecimiento de las máquinas, y permite acometer tareas con un flujo masivo de datos, como es el caso de tantos programas de biología. Los expertos dicen que la arquitectura del masivamente paralelo es como conducir un Ferrari, mientras que el paralelo de los sistemas fuertemente acoplados es como llevar muchos Seat 600 atados con una cuerda.

Peter Ungaro, de IBM, explicó en el simposio de la AAAS cómo será el Blue Gene, un nuevo superordenador específicamente concebido para la investigación biológica, mientras que Hellefinger expuso las prestaciones del futuro Red Storm, que se desarrolla en el SNL en colaboración con la empresa Cray, con un presupuesto de 90 millones de euros. Esta máquina, que debe estar lista en 2004, tendrá una potencia de 40 teraflops con una arquitectura de masivamente paralelo. Con ella no sólo los biólogos podrán acometer problemas de simulación muy complejos, sino que también servirá para la simulación de armamento nuclear.

Los expertos dedicados a las ciencias de la vida también están trabajando en Grid, un sistema en desarrollo imprescindible para tareas como el análisis de los datos que generarán los detectores del nuevo gran acelerador de partículas LHC (del Laboratorio Europeo de Física de Partículas, CERN), pero para el que se planean ya tareas en varias otras áreas dependientes de la supercomputación.

El Grid conjuga las bases de datos distribuidas y la computación distribuida, con líneas de intercomunicación de alta velocidad. La idea es poder utilizar centenares de ordenadores diferentes dispersos en institutos y centros de muchos países para una misma tarea de cómputo, de forma que cada uno almacena y computa una parte del cálculo. Su versión biológica es el Biogrid.

En EE UU, explicó Ungaro, se ocupan del desarrollo del llamado TeraGrid cuatro instituciones: el Centro Nacional de Aplicaciones de Supercomputación (NCSA), el Centro de Supercomputación de San Diego (SDSC), el Laboratorio Nacional Argonne y Caltech, especializándose en computación intensiva, manejo de grandes flujos de datos, visualización y análisis de colecciones de datos, respectivamente.

"Necesitamos una revolución, no sólo una evolución", resumió en Denver Marshall Peterson, de la organización TCAG (TIGR Center for the Advancement of Genomics).

Mil billones de operaciones

Uno de los proyectos más ambiciosos del mundo de la supercomputación es Blue Gene, una maquina que debe ser 500 veces más potente que los ordenadores más rápidos actuales. IBM ha asignado un presupuesto de 100 millones de euros a esta iniciativa. Blue Gene hará más de mil billones de operaciones por segundo (un petaflop), lo que significa "mil veces más potente que el Deep Blue que ganó al campeón del mundo de ajedrez Gary Kasparov en 1997 y unos dos millones de veces más potente que los ordenadores personales actuales", según IBM. Los dos superordenadores más rápidos del mundo son máquinas del programa ASCI (Departamento de Energía), de dos teraflops. Blue Gene estará lista en 2005 y se concibe como una supercomputadora orientada a problemas de investigación biológica, sobre todo los mecanismos del plegamiento de las proteinas. Se trata de "avanzar en el estado del arte de la simulación biomolecular, así como del diseño por ordenador y el desarrollo de software para sistemas de escala extremadamente alta", resumió Peter Ungaro, de IBM, en el simposio de la AAAS.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.