Este hombre puede acabar con la tecnología de reconocimiento facial en Estados Unidos

Robert Williams fue detenido porque un algoritmo le confundió con otro. Acaba de presentar una demanda para prohibir estos sistemas en Detroit. Si gana, el ejemplo puede cundir en el resto del país

Robert Julian-Borchak Williams fue detenido el 9 de enero de 2020 según llegó del trabajo a su casa en el barrio residencial de Farmington Hill, a las afueras de Detroit. Un coche patrulla paró con un frenazo tras su camioneta recién aparcada, bloqueándole la salida. Dos agentes le preguntaron su nombre y, tras mostrarle una orden de arresto, le esposaron y se lo llevaron. Melissa, su mujer, asistió a la escena desde la puerta de la vivienda con su hija pequeña en brazos, tratando de contener a la mayor para que no saliera del porche. Pasó la noche encerrado en un centro de detención sin saber de qué se le acusaba. Le soltaron 18 horas después: los dos detectives que le interrogaron comprobaron que Williams no se parecía a quien había robado unos relojes de lujo en una tienda del centro. Cuando le mostraron la foto del sospechoso, se la puso al lado de la cara y le dijo al agente: “Este no soy yo. Espero que no piensen que todos los negros somos iguales”. Los dos policías se miraron y luego uno le replicó: “El ordenador dice que es usted”.

El ordenador falló. El sistema de reconocimiento facial empleado por el Departamento de Policía de Detroit (DPD) cruzó una imagen tomada por la cámara de seguridad del establecimiento con su base de datos. Saltó una coincidencia: la foto del carnet de conducir de Williams. Ambas personas son negras y corpulentas, pocos más parecidos se pueden sacar. “Podían haber llevado la foto consigo, mirarla antes de detenerme e irse. No lo hicieron”, se lamenta en un vídeo difundido por la Unión Estadounidense de Libertades Civiles (ACLU).

Williams pidió ayuda a esta organización para que su caso no quedara impune. Inmediatamente elevaron una queja a la policía. Ante la falta de respuesta, la ACLU, junto con la la Iniciativa de Litigio de Derechos Civiles (CRLI) de la Universidad de Michigan, presentaron hace dos semanas una demanda contra el Departamento de Policía de Detroit. No solo denuncian el arresto injusto que sufrió su cliente: reclaman también que se prohíba el uso de esta tecnología, que cruza de forma automática las imágenes que toma de ciudadanos en lugares públicos con bases de datos de sospechosos. Si los tribunales les dan la razón podría prender la chispa que acabe dinamitando los sistemas de reconocimiento facial en el resto del país.

El de Williams, que hizo público The New York Times el pasado verano, es el primer caso conocido en EE UU de detención irregular por el uso defectuoso de un algoritmo de reconocimiento facial. Desde entonces ha habido al menos dos más, siempre con personas negras como protagonistas. Uno de ellos también en Detroit y con el agravante de que al joven al que se detuvo por robar un móvil, a diferencia del infractor real, tiene el cuerpo y hasta la cara llena de tatuajes, lo que hace todavía más evidente el error. “Por los indicios que tenemos, creemos que hay incontables casos similares en los que incluso sus abogados defensores no tienen ni idea de que esta tecnología se usó contra ellos”, explica por videollamada Deborah Won, una de las abogadas del equipo que asesora a Williams. Su cliente, de hecho, se enteró de manera fortuita de que fue un algoritmo quien ordenó su detención: si no llega a ser por el comentario del agente en la sala de interrogatorios, Williams hubiera creído sufrir un caso de mala praxis policial como tantos otros.

El ‘efecto George Floyd’

Estados Unidos vive un momento delicado en lo tocante a la cuestión racial. No es casualidad que la demanda del caso Williams se haya presentado coincidiendo con el juicio del policía acusado de asesinar a George Floyd en Minneapolis en mayo del año pasado. Sí es fruto del azar que sucediera en plenas protestas contra el tiroteo de Daunte Wright, el chico al que mató de un tiro una policía que confundió su arma con un Táser. “Esperamos que el momentum ayude”, señala Won. “El reconocimiento facial está muy relacionado con la discriminación racial. Williams me dijo que le impactó mucho el caso de George Floyd, y que de hecho le dio más energía todavía para asegurarse de que su caso sea conocido para que no vuelva a pasar”.

La jurista explica que hay estudios del Gobierno Federal que prueban que esta tecnología es 100 veces más proclive a confundir individuos negros que blancos. “Los algoritmos que hay detrás del reconocimiento facial se entrenaron con rostros de personas blancas, de ahí que el ordenador sea mejor identificando a blancos”, añade Philip Mayor, abogado de ACLU que lleva también el caso de Williams. “Estos sistemas son mejores con hombres que con mujeres y aciertan más en edades medias”.

La movilización social que provocó el asesinato de George Floyd tuvo otra consecuencia sobre el reconocimiento facial. IBM, Amazon o Microsoft han congelado o suspendido definitivamente la venta de estos sistemas a los departamentos de policía. Al no haber una regulación federal que afecte a esta tecnología, son los Estados y las ciudades quienes a la práctica están restringiendo su uso. San Francisco fue en 2019 la primera. Le siguieron Oakland y Berkeley. Portland (Oregón), Minneapolis (Minnessota) y seis ciudades de Massachussetts, entre las que se incluye Boston, también las han prohibido o limitado. Este Estado es, de hecho, el primero en introducir una normativa que acota el uso de esta técnica digital de vigilancia. California, por su parte, ha impuesto una moratoria de tres años, y el Estado de Nueva York estudia endurecer su uso por parte de la policía.

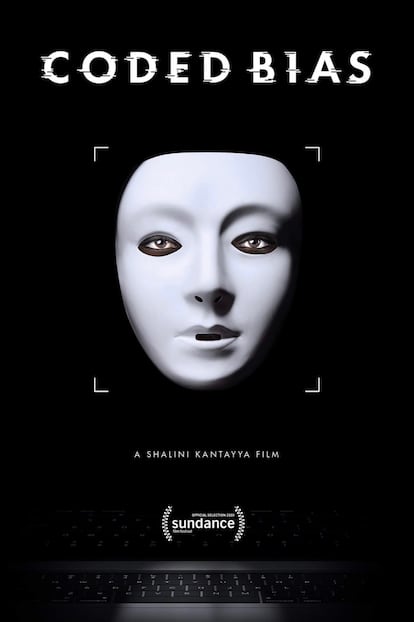

“Estas herramientas son demasiado poderosas, y su potencial para provocar defectos graves, como sesgos demográficos o fenotípicos extremos, es claro”, dijo Joy Buolamwini, investigadora del MIT Media Lab, durante una comparecencia ante el Comité de Supervisión y Reforma de la Cámara de Representantes. La estadounidense de origen ghanés fundó la Algorithmic Justice League (AJL) en 2016 cuando se dio cuenta de que algunos sistemas de reconocimiento facial no detectaban su rostro a menos que se pusiera una careta blanca. “Los algoritmos, como los virus, pueden propagar sesgos a escala masiva y a un ritmo acelerado”, dice en una charla Ted que acumula millón y medio de visualizaciones.

Amnistía Internacional, la Electronic Frontier Foundation (EFF) y la propia ACLU son algunas de las organizaciones más activas en las peticiones para que se prohíba el reconocimiento facial en EE UU. “Es una tecnología muy peligrosa cuando no funciona, como ilustra el caso de Williams, pero también cuando funciona, porque le da a los gobiernos una vía para vigilarnos de forma muy eficiente”, ilustra Mayor. En el caso de su ciudad, Detroit, hay cámaras que apuntan a iglesias, mezquitas, centros médicos o edificios de viviendas públicas. La situación es la misma en buena parte del país. El reconocimiento facial se ha usado para identificar a manifestantes en ciudades como Baltimore. A nivel federal, se sabe que es empleado por el FBI, la agencia de lucha antidrogas (DEA), los servicios de fronteras e inmigración y las fuerzas militares.

El oasis europeo

“Nunca imaginé que tendría que explicarle a mis hijas por qué detuvieron a su papá. ¿Cómo se le explica a dos niñas pequeñas que un ordenador se equivocó, pero que la policía le hizo caso igualmente?”, escribió Robert Williams en The Washington Post en junio, cuando su caso ya había salido a la luz. La intención de Bruselas es que nadie tenga que llegar a ese extremo. El proyecto de reglamento europeo para la inteligencia artificial, presentado el pasado 21 de abril y pendiente de aprobación por el Parlamento Europeo, prohíbe los llamados “sistemas de identificación biométrica remota” con contadas excepciones, entre ellas usarlos con “fines de prevención, detención o investigación de crímenes graves o terrorismo”.

Moisés Barrio, letrado del Consejo de Estado y experto en derecho digital, participó en la elaboración del Libro Blanco en el que se ha inspirado el reglamento. “Propusimos un enfoque centrado en el riesgo: las aplicaciones que procesen cuestiones peligrosas deben tener más controles que el resto”, explica. El reconocimiento facial entra en ese grupo, aunque no hay un consenso cerrado al respecto: países como Polonia o Hungría, por ejemplo, son partidarios de su uso.

En España, un grupo de académicos presentó en marzo una carta al Gobierno solicitando la moratoria de esta tecnología. La filósofa Carissa Véliz fue una de ellas. Desde su punto de vista, el problema no es tanto la discriminación, que eventualmente se podría corregir con una mejor base de datos, como la amenaza que supone contra el anonimato. “El anonimato que trajeron consigo las grandes ciudades fue importantísimo para el desarrollo de la literatura, de la política, del pensamiento y de la propia democracia: hasta ese momento no se podía protestar sin miedo a las represalias”, apunta la autora de Privacy is Power.

Incluso si el uso del reconocimiento facial por parte de la policía no produjese errores como el de Robert Williams, opina Véliz, otorgar esta tecnología a la policía es darle mucho control a las fuerzas de seguridad. “Y hay una relación muy fuerte entre las sociedades de control y el autoritarismo”, sentencia.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.