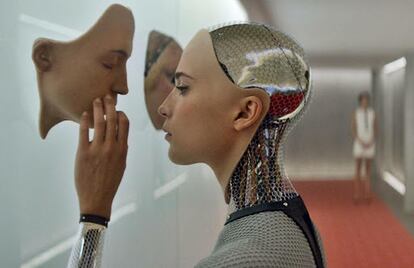

No habrá inteligencia artificial general

Los grandes modelos de lenguaje podrían convertirse en agentes inteligentes con la capacidad de entender el mundo, pero no lo harán porque viven encerrados en un mundo de palabras

En enero de 2020, un físico teórico y profesor en la Universidad Johns Hopkins llamado Jared Kaplan publicó un paper llamado Leyes de Escalamiento para Modelos de Lenguaje Neurales. Su influencia es tan grande que la hipótesis que proponía nos parece hoy de cajón. Decía que los modelos generativos mejoran de manera predecible al aumentar el número de parámetros, la cantidad de datos de entrenamiento y la potencia computacional. Es la ley de escalamiento: cuando más grande y más datasets digiere, mejor “piensa” el modelo. Salvo por un detalle, que en aquel momento no parecía importante. Cuando más sofisticado es el modelo, más sofisticadas son sus “alucinaciones” y, por lo tanto, más difíciles de detectar.

Kaplan y su equipo entrenaron varios modelos de diferentes tamaños con diferentes cantidades de datos. Comprobaron que, al aumentar la cantidad de datos y el tamaño del modelo, aumentaba la precisión y la coherencia de las respuestas y se reducían los errores de predicción. Como ocurre en la naturaleza, la exposición a una mayor diversidad de ejemplos parecía ayudarles a “entender” mejor las complejidades del lenguaje humano. Kaplan detectó también que aumentaba su habilidad para generalizar conocimientos y aplicar con éxito lo aprendido a situaciones y contextos nuevos. Es irresistible la comparación con el niño o animal que aprende a medida que se expone al mundo. Esa comparación sería falsa y engañosa. Incluso la palabra aprendizaje es una estafa. Alucinación también lo es.

Los grandes modelos del lenguaje, sean Gemini, Claude o GPT, son sistemas complejos, igual que las especies de animales, las ciudades, los negocios o las lenguas. Quiere decir que están compuestos de muchas partes interconectadas que interactúan entre ellas de acuerdo a leyes que no pueden ser inferidas a partir la suma de sus partes. El primero en notarlo estas leyes que llamamos “de potencia” fue Galileo, cuando observó que los árboles no crecían hasta el infinito porque, a partir de cierto tamaño, su tronco deja de crecer hacia arriba y se ramifica de forma más compleja y jerárquica.

Conocemos algunas de esas leyes. La ley de Kleiber dice que cuando un organismo duplica su tamaño, su tasa metabólica no se duplica, sino que crece solo un 41%. En otras palabras, un animal el doble de grande que otro no necesita comer el doble porque su eficiencia metabólica aumenta con su tamaño, lo que quiere decir que envejece más lentamente. La ley de Zipf dice que la segunda palabra más frecuente de cualquier lengua aparece aproximadamente la mitad de veces que la más frecuente, la tercera palabra un tercio, y así sucesivamente.

La ley de escalamiento de Jared Kaplan sugiere que, con acceso a más máquinas, más energía y más contenidos, los modelos se convertirán en agentes inteligentes con la capacidad de entender el mundo. Es la única base de la actual carrera hacia la inteligencia artificial general (IAG). La persistencia de las alucinaciones es la prueba de que no sucederá, al menos con esta tecnología. Los modelos viven encerrados en un mundo de palabras, un universo wittgensteniano compuesto exclusivamente de signos, jerarquías y estadística. No pueden mentir, alucinar o equivocarse porque todas las palabras son verdaderas cuando dejan de describir el mundo. No habrá IAG con esta tecnología. Cualquiera que diga lo contrario miente, o se ha dejado engañar.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.