¿Cuánto falta para que un robot salga en 'El club de la comedia'?

Algunos algoritmos ya son graciosos, pero a menudo sin querer

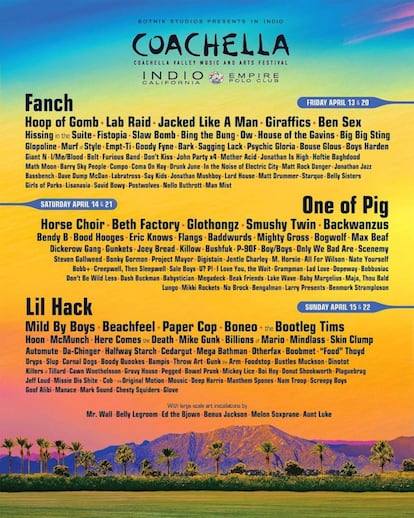

Jiraffics, Horse Choir, Paper Cop, Deep Harris… Estos son algunos de los muchos nombres de bandas que aparecían en un cartel del festival Coachella. Eran todos falsos y todos los había generado un algoritmo. Este mismo algoritmo, obra de la empresa Botnik, ha firmado parodias de guiones de Juego de Tronos y de Arrested Development e incluso una falsa secuela de Harry Potter: Harry Potter y el retrato de lo que parecía un montón grande de ceniza. La empresa también ha trabajado para Amazon, ayudando a desarrollar funcionalidades para Alexa, su asistente virtual.

Muchos de estas obras viralizaron porque las parodias sonaban convincentes, aunque siguieran sonando raras en ocasiones, como cuando se dice que Ron estaba “bailando algo parecido a claqué” mientras el fantasma de Harry caminaba hacia el castillo. Pero hay trampa: en estas obras han intervenido humanos.

Botnik es una empresa en 2016 por Jamie Brew, antiguo editor en Clickhole (la parodia de medios virales de The Onion) y Bob Mankoff, exeditor de viñetas cómicas del New Yorker. En parte funciona como muchos otros sistemas parecidos: el programa, llamado Voicebox, se alimenta con textos parecidos, como las novelas de J. K. Rowling o artículos sobre bitcoin.

La diferencia es que el programa no devuelve un texto formado, sino que ofrece "teclados predictivos temáticos". De hecho, en eso se basa la idea de Jamie Brew, cofundador y consejero delegado de la empresa, en los experimentos de frases absurdas que, a modo de juego, a menudo hacía con su teléfono. Como mucha otra gente, claro.

Cita este tweet empezando por "Pedro Sánchez me ha nombrado Ministro/a/e de..." y completa con el teclado predictivo.

— Merveilleuse (@MaggieMacGill) June 6, 2018

Se puede probar en su web: uno puede escribir como si parodiara un guion de Seinfeld, una receta de crêpes, una canción de Beyoncé o el manifiesto comunista. Como en este ejemplo (traducido del inglés): “La lucha de la clase proletaria se desarrolló por las condiciones modernas de la individualidad burguesa”. No es gracioso, pero es creíble.

La idea de Botnik es que su máquina, Voicebox, sea una herramienta para humoristas y escritores, una especie de “Minecraft para escritores”, en el sentido de que con materiales en apariencia limitados pueden surgir muestras complejas. Brew nos pone un ejemplo en conversación telefónica: la banda So, Sorry está usándolo para escribir las letras de sus canciones, después de haber alimentado al algoritmo con letras de disculpas de empresas.

Para mostrar las posibilidades de su sistema, la empresa organiza espectáculos cómicos en vivo en los que se suceden actuaciones e improvisaciones con material generado con ayuda del sistema.

Para ellos, esta interacción con los humanos es imprescindible. Su solución al problema de si la inteligencia artificial puede contar un chiste es sencilla: que lo cuente un humano. Parece trampa. Pero en realidad explica por qué los demás intentos han fracasado.

Van dos y hay que reiniciar al de enmedio

Ha habido bastantes proyectos de programas informáticos que crean chistes: JAPE, STANDUP, WISCRAIC. En ¡Ja! La ciencia de cuándo nos reímos y por qué, Scott Weems explica que a menudo se ha atacado este problema como una cuestión “de creatividad combinatoria”, en la que se manipulan rimas o se sustituyen palabras. Como JAPE, que propone que FBI significa “Fantastic Bureau of Intimidation”. Jejeje...

Otro de ellos, Deviant, identifica palabras con potencial para tener significado sexual y no sexual, y luego añade aquello de “that’s what she said” (eso dijo ella). El problema es que 71% de los chistes eran “falsos positivos”. Es decir, no tenían gracia.

No es de extrañar que muchos consideren que el humor es uno de los problemas más complejos en inteligencia artificial. Uno de los factores que influye en esta complejidad es la subjetividad del humor, como explica a Verne Paolo Rosso, profesor del departamento de sistemas informáticos y computación de la Universidad Politécnica de Valencia, y autor de varios trabajos sobre la ironía en internet. El humor es tan subjetivo que a menudo se aprovecha la ambivalencia para excusar mensajes ofensivos con un “estaba bromeando”. “Si además añadimos que en el humor suele haber ironías, metáforas... se complica aún más”, añade Rosso.

Otro de los problemas de estos programas es que no son, en palabras de Weems, “transformadores de forma creativa”, es decir, “no rebasan límites y no sorprenden con hallazgos inesperados” (eso dijo ella, por cierto). El algoritmo es simplemente una serie de normas para elaborar un tipo concreto de chiste a partir de un material determinado.

La propuesta de Brew es menos sofisticada tecnológicamente, pero da resultados que nos resultan más divertidos. La clave es que no elimina el factor humano. Brew cree que las máquinas son buenas para ciertas cosas y que los humanos lo somos para otras. Puede que las máquinas sean mejores o más rápidas a la hora de procesar información, pero a nosotros aún “se nos da mejor reconocer patrones” incluso en los resultados aún extraños que dan esos algoritmos que intentan imitar a Rowling.

La habitación de los chistes

¿Pero podemos decir que estos programas son graciosos? Botnik no pretende escribir ninguna parodia de Rowling o de Juego de Tronos: el texto que nos ofrece es lo que en su opinión es un ejemplo similar a lo que esta escritora o esta serie hacen. Algo parecido ocurre con programas con JAPE y Deviant: se limitan a seguir una serie de normas sin ninguna intencionalidad.

Por otro lado, si se tratara de un robot que cocinara una tortilla de patata sacando los ingredientes de nuestra nevera y siguiendo una receta paso por paso, no dudaríamos de que está cocinando. ¿El humor es diferente? ¿Se puede hacer humor si no se tiene la intención de hacer reír (caídas al margen)?

Con esto llegamos a un experimento mental sobre la inteligencia artificial propuesto por John Searle en 1980: la habitación china. Imagina que no sabes ni una sola palabra de chino y que estás encerrado en una habitación que se comunica por el exterior con una serie de ranuras por las que pueden pasarse hojas de papel.

No sabes el idioma, pero tienes una serie de normas con unas reglas que permiten relacionar los caracteres chinos entre sí (“si ves un símbolo con esta forma, responde con estos otros símbolos con estas otras formas”), de tal modo que cuando se te pasa un texto en chino, eres capaz de responder con otro texto en chino, aunque no tienes ni idea de lo que estás escribiendo. ¿Significa eso que sabes chino? Y, volviendo a los algoritmos que cuentan chistes, ¿significa esto que Deviant y Botnik son graciosos? Al fin y al cabo, solo siguen instrucciones.

Una de las respuestas más habituales a este experimento mental (la da el filósofo Daniel Dennett en su Bombas de intuición, por ejemplo) es que es todo el sistema el que sabe chino. No sabe chino la persona que está dentro de la sala o el libro de instrucciones, sino todos los elementos cuando interactúan. Esto también ocurre con nosotros mismos: la comprensión -escribe Dennet- se crea “gracias a una serie de competencias apiladas sobre otras competencias”.

Los algoritmos que se han desarrollado hasta ahora no tienen todavía muchas competencias que apilar, pero podría llegar el caso de que ocurriera tal cosa. Y quizás, quién sabe, uno de estos algoritmos llene salas y teatros e incluso llegue a protagonizar un especial de Netflix.

De momento, lo más parecido que tenemos es The Humans Are Dead, de The Flight of The Conchords.