¿Por qué alucinar con GPT-4? Una idea escurridiza sobre su poder

Una crítica común a estas inteligencias artificiales es decir que ‘solo’ son modelos estadísticos que han aprendido a predecir la siguiente palabra de un texto. Pero quizá esa característica, más que una limitación, sea un motivo de asombro

Ha sido una semana importante para la inteligencia artificial. Los gigantes Google y Microsoft, inmersos en una feroz competición, anunciaron cada uno por separado que van a integrar una IA asistente en sus aplicaciones más populares, desde Gmail a Word. Un algoritmo escribirá tus correos; Google Docs podrá reescribir tus peores párrafos, y un copiloto, como lo llaman en Microsoft, sabrá analizar tus tablas de Excel para decirte con palabras lo que encuentra.

Además, claro, llegó GPT-4.

Se acaba de actualizar el modelo de lenguaje que mueve a ChatGPT, la aplicación responsable de catapultar esta nueva tecnología hasta la popularidad de masas. GPT-4 es más potente —es decir, más inteligente— y añade nuevas funciones. Se presenta con un currículo impresionante: esta versión es capaz de aprobar un montón de exámenes de nivel universitario, en escritura, comprensión lectora o matemáticas, a menudo con unas notas que lo colocarían entre el 10% mejor de la clase.

Hay muchos ejemplos de sus capacidades. GPT-4 puede mirar una foto de un esquema pintado a mano y crear una web sencilla; puede programar pequeños videojuegos o resumir y comparar artículos largos. Yo le pasé el test de lógica de ‘Piensa claro’, que hizo muy bien.

Pero hoy quiero detenerme en una característica de estas inteligencias artificiales que se malinterpreta. Se presenta como una limitación de GPT-4 y otros modelos similares, cuando es, bajo mi punto de vista, un motivo de asombro.

Diferenciar entre capacidades y objetivos

Una crítica común a estas inteligencias artificiales consiste en decir que «solo» son modelos estadísticos que predicen cuál es la palabra más probable para continuar un texto. No hacen nada más, dicen sus críticos, no son nada espectacular.

Es al revés.

Es cierto que GPT-4 ha aprendido así, en gran medida. Su entrenamiento consistió en jugar un juego muy simple: dada una secuencia de texto, debía predecir la siguiente palabra (o token) y acertar con la máxima frecuencia que pudiese. Por ejemplo, ante la frase «Benidorm es un destino de sol y ___», seguramente ganaba diciendo «playa». Su aprendizaje consistió en jugar ese juego, una y otra vez, con una frase y luego con otra, hasta usar casi todo el texto de internet y acabar siendo buenísimo en ese juego diminuto.

Por lo tanto, sí, GPT entrenó con el objetivo de predecir palabras, pero sus capacidades que emergieron de ese aprendizaje pueden ser muchas otras. Habilidades de lenguaje, de lógica o de razonamiento. Y no es fácil saber exactamente cuáles tiene, porque lo que sucede dentro de una red neuronal es algo en gran medida desconocido.

Para apreciar la diferencia es útil entender cómo funciona GPT y cómo es su aprendizaje. Los grandes modelos de lenguaje son un tipo de redes neuronales, unas estructuras matemáticas que pueden verse como una enorme tabula rasa, con miles de millones de posibles conexiones entre nodos, conectando sus entradas (un texto; a veces imágenes) con sus salidas (otro texto). Imaginad una máquina de pinball gigantesca, donde las entradas son las bolas que rebotan por toda la estructura para, según sus propiedades, acabar en ciertas salidas. La red es una estructura flexible capaz de generar formas funcionales enormemente complejas.

Pero es trascendental entender que ningún programador altera esa estructura a mano. No inserta reglas concretas.

Entonces ¿cómo se organiza esa red para funcionar? ¿De dónde sale la configuración concreta que logra que GPT-4 sepa sumar, finja enfadarse o entienda qué es la adolescencia? Casi todo eso aparece en el entrenamiento que describía antes, un proceso autónomo, que justifica el término de “inteligencia artificial”. Arriesgándome a simplificar, el aprendizaje consiste en jugar millones de veces el juego de predecir la siguiente palabra de una frase, ajustando en cada tirada alguno de los parámetros o pesos que definen la red, en un viejo proceso de optimización matemática. “Al final, se trata de determinar qué pesos capturarán mejor los ejemplos de entrenamiento que se han dado”, resume Stephen Wolfram. Este proceder iterativo teje la madeja gigante que es la red neuronal para que resulte muy buena prediciendo palabras, porque esa es función objetivo.

¿Dónde está el malentendido del que hablaba? En pensar que eso es lo único que hace GPT-4 o cualquiera red neuronal. Su función objetivo define su meta, sí, pero no sus capacidades. En realidad, cualquier habilidad que resulte útil para predecir palabras puede emerger potencialmente dentro de la red. Si le ayuda saber multiplicar, razonar con lógica o saber pensar como un niño, podría —quizá— aprender todo eso.

Y esa es la razón de mi fascinación.

Por supuesto, esto no significa que estos artefactos estén vivos, que tengan conciencia ni nada parecido. Tampoco que sean inteligentes de la forma en que lo somos los humanos. Pero sí son emergentes: algoritmos capaces de tener habilidades que nadie puso en ellos, pero que aparecieron empujadas por un proceso de mejora en persecución de un objetivo. Uno simple —predecir palabras—, pero suficiente para que aprendan a escribir mala poesía y pintar bonitos paisajes.

Si queréis un símil exagerado, ¿sabéis qué es también el resultado de un proceso emergente parecido? Nosotros los seres humanos. La teoría de la evolución dice que el motor de la vida es maximizar un resultado: sobrevivir y propagar genes. Es un objetivo limitado, en realidad, ni elevado ni romántico, pero ha sido suficiente para traernos hasta aquí y empujarnos a pintar en paredes, contemplar las estrellas y pensar en bebés que duermen.

P.D. Este texto es un intento honrado de compartir mis impresiones sobre una tecnología que me interesa, y que estudié hace dos décadas, aunque no soy ningún experto. Si queréis una visión menos entusiasta, los escépticos han celebrado el artículo de Noam Chomsky: La falsa promesa de ChatGPT (inglés). También os recomiendo esto de Ezra Klein, entre la fascinación y el miedo, y si queréis detalles matemáticos, esto de Stephen Wolfram.

Otras historias

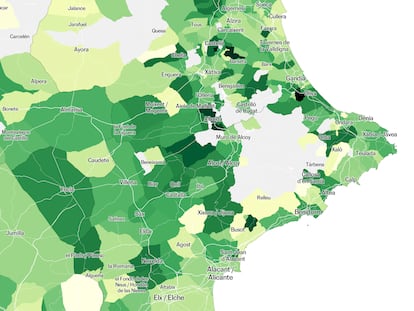

💶 1. Cuánto invierte tu municipio en educación

Mis compañeros han buceado en los datos de liquidaciones de todos los ayuntamientos de España para investigar cuanto invierten en escuelas, clases y otras partidas relacionadas con la educación. Hay ciudades como Pamplona que gastan 20 veces más que Almería: casi 500 euros por cada niño o joven, lo que supone un 10% de todo su presupuesto municipal.

En el artículo podéis consultar el gasto de vuestro municipio con un mapa interactivo.

💫 2. Nos fue bien prediciendo los Oscar

La semana pasada, acertamos los premios a mejor película, dirección, animación. También con tres de los cuatro premios a actores y actrices, todos menos el que veíamos más dudoso, la estatuilla a la mejor actriz de reparto, que eran casi un cara o cruz entre Angela Bassett (37% de probabilidad) y Jamie Lee Curtis (35%), y que acabó en manos de la segunda.

📺 3. Pregunta: ¿Salió GPT-4 en las noticias?

Con la publicación del nuevo modelo de lenguaje se puede cumplir una de mis predicciones para 2023, aunque todavía no he comprobado si salió en los telediarios. ¿Lo habéis visto allí?

¿Me ayudas? Reenvía esta newsletter a quién quieras, y si no estás suscrito, apúntate aquí. Es un boletín exclusivo para suscriptores de EL PAÍS, pero cualquiera puede recibirlo durante un mes de prueba. También puedes seguirme en Twitter, en @kikollan, o escribirme con pistas o comentarios, a kllaneras@elpais.es.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.