La UE pone límites a la inteligencia artificial pero se olvida de las armas autónomas

La Comisión presenta hoy un reglamento que prohibirá las aplicaciones más peligrosas de esta tecnología, como la “vigilancia indiscriminada”, pero que deja fuera las aplicaciones militares

Reconocimiento facial, conducción autónoma, escucha de redes, robótica, investigación de nuevos fármacos, mecanismos de cálculo de probabilidad de retorno de un crédito… La inteligencia artificial (IA) tiene muchas caras. La más temida es su versión orwelliana: este grupo de tecnologías –su crecimiento ha sido tal que ya no se puede hablar de una sola– ha demostrado ser muy útil para vigilar a los ciudadanos e influir en sus decisiones. Ya sucede en China y, según la matemática Cathy O’Neil, también en Occidente, aunque de forma velada. La Unión Europea no quiere dejar que florezca el lado oscuro de estos sistemas. La Comisión presenta hoy una propuesta de reglamento, cuyo borrador se filtró la semana pasada, que sentará las bases del desarrollo de la inteligencia artificial en el continente.

El texto inicia ahora el proceso de tramitación en el Parlamento Europeo, y por tanto puede alterarse. La aproximación de Bruselas al asunto es la misma que se aplicó al Reglamento General de Protección de Datos (RGPD), en vigor desde 2018: evalúa el riesgo de las distintas aplicaciones de la inteligencia artificial y restringe o prohíbe las que considera más peligrosas. La redacción de la norma deja claro en el preámbulo que su objetivo es que la inteligencia artificial asuma en la UE un enfoque “centrado en el ser humano”. Traducción: en Europa no se va a dejar a las empresas que hagan lo que les plazca.

Restricciones y prohibiciones

Entra en la categoría de “alto riesgo”, y por tanto queda prohibida, la “vigilancia indiscriminada”. Se entiende por ello a los sistemas que rastrean a los ciudadanos en entornos físicos, situándolos en una ubicación exacta en un momento determinado, o que extraen datos agregados sobre estos.

También son de alto riesgo los llamados “sistemas de identificación biométrica remota”, término que alude al reconocimiento facial, una tecnología cuya aplicación ha levantado airadas quejas en la Academia. El reglamento establece excepciones legítimas a su prohibición: estos sistemas solo se permitirán si así lo autoriza la UE o los Estados miembros, si se usan con “fines de prevención, detención o investigación de crímenes graves o terrorismo” o si su aplicación está limitada a un tiempo determinado y luego se borra.

Los sistemas de puntuaciones de crédito social, mediante los cuales se calcula la fiabilidad del individuo de acuerdo a una serie de variables, quedan también proscritos. Las autoridades chinas aplican uno, cuyo funcionamiento se desconoce, que puede tener graves consecuencias sobre quienes pierdan puntos.

Igual que el RGPD exige a quienes quieran manipular los datos de un individuo que este dé su consentimiento, el reglamento de inteligencia artificial establece que hay que notificar al aludido cuando interactúe con un sistema de IA. A menos, dice la normativa, que eso sea “obvio por las circunstancias y el contexto de uso”.

Vigilancia y sanciones

Asimismo, se especifica que se deberá supervisar los sistemas considerados de alto riesgo, una categoría que, aclara el texto, estará en constante proceso de actualización. Además de las aplicaciones ya mencionadas, entran ahora mismo en esta definición los sistemas de IA diseñados para decidir cómo y dónde asignar recursos en caso de emergencia, los usados para admitir o denegar solicitudes de acceso a instituciones educativas, para evaluar candidaturas en procesos de reclutamiento de personal, para calcular la solvencia crediticia de los individuos o para asistir a jueces, entre otros.

El reglamento establece también la creación de un “Consejo Europeo de la Inteligencia Artificial”, cuya principal atribución será decidir qué aplicaciones pasan a ser consideradas de alto riesgo.

Las empresas que no cumplan con la normativa se pueden enfrentar a multas de hasta 20 millones de euros o el 4% de su facturación, cifra que en el caso de las grandes tecnológicas puede ser muy abultada.

El principio del camino

La Secretaría de Estado de Digitalización e Inteligencia Artificial valora positivamente el reglamento. “Es un gran paso adelante para que desde la Unión Europea diseñemos la nueva realidad digital”, señalan fuentes del departamento que dirige Carme Artigas. “Es una propuesta equilibrada, que proporciona un entorno de confianza y de garantías a la ciudadanía, pero a su vez sin limitar la capacidad de innovación de una tecnología con tantas oportunidades como la IA”.

Borja Adsuara, consultor y experto en derecho digital, no está de acuerdo en este último punto. La intención de Bruselas de tratar de prever cuál puede ser el desarrollo del conjunto de tecnologías que llamamos IA, opina, encorsetará la innovación. “Europa, desde Justiniano pasando por Napoleón, siempre ha tenido un problema: es un sistema de código cerrado, todo lo que no está expresamente permitido está prohibido. Eso no es muy proclive a la innovación, porque innovar es precisamente hacer lo que no está previsto”, reflexiona. En Estados Unidos, en cambio, el método es el inverso: lo que no está expresamente prohibido está permitido. “Por eso las grandes startups se gestan allí”, añade.

Para este jurista, el reglamento es un buen punto de partida, aunque se pregunta si no tendría más sentido modificar las leyes ya existentes, desde el Código Penal a Ley de Procedimiento Administrativo, que crear una nueva para una tecnología particular. “Lo que interesa de la tecnología son sus aplicaciones, en concreto los malos usos. El derecho está para prevenir estos últimos”, indica.

Una ausencia destacada

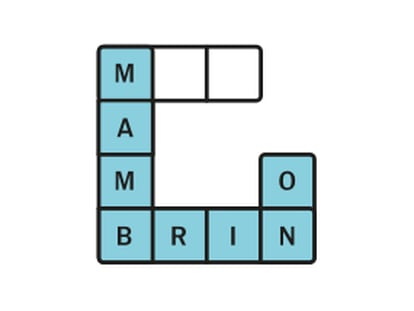

“Me ha decepcionado mucho que se hayan dejado fuera las armas letales autónomas”, destaca por su parte Ramón López de Mántaras, director del Instituto de Investigación en Inteligencia Artificial del CSIC. “El borrador habla de las aplicaciones de alto riesgo de la inteligencia artificial; no sé qué puede tener más riesgo que un arma que tome la decisión de matar de forma autónoma”, abunda. El documento dice textualmente que “esta regulación no aplica a los sistemas de IA usados exclusivamente para el manejo de armas u otros propósitos militares”.

El profesor López de Mantaras cree también que el reglamento es un buen punto de partida para regular la IA, algo que considera necesario. “Pero creo que será extremadamente difícil cumplir con esta regulación. En algunos casos por cuestiones técnicas, como conseguir una transparencia en los datos y algoritmos que cumpla las exigencias, y también por razones prácticas, como el coste derivado de hacerlo”.

Hay más elementos que van a hacer complicado que se cumpla la normativa. El borrador dice que los sistemas de alto riesgo tienen que asegurarse de usar datos que sean de alta calidad para que la inteligencia artificial haga lo que se supone que tiene que hacer, que no tenga sesgos. “Eso está muy bien, pero conseguir tener unas bases de datos de entrenamiento que sean relevantes, representativos y que no tenga errores es muy complejo”, explica López de Mántaras.

Luego están los sistemas que no son cerrados, los que están continuamente aprendiendo. Por ejemplo, los coches autónomos. “¿Cómo asegurar que un sistema que, en el momento de lanzarlo al mercado, tenía bases de datos sin sesgos, bien montadas y controladas, no se desmadre posteriormente a medida que vaya aprendiendo?”, se pregunta.

Puedes seguir a EL PAÍS TECNOLOGÍA en Facebook y Twitter.

Sobre la firma